Lösung für Energiespeicher: Heiliger Gral der Branche?

Neue Energielösungen, vor allem bei der Speicherung, werden benötigt, um des steigenden Bedarfs Herr zu werden. Anlagen in erneuerbare könnten bald rentabler sein als in traditionelle Energien – das wird die Branche umgestalten.

Da sowohl die Weltbevölkerung als auch die Urbanisierung weiterhin rasch zunehmen, steigt auch der Energieverbrauch unwiderruflich. Prognosen zufolge wird der globale Energiebedarf im Jahr 2040 43 Prozent höher sein als heute. Das wiederum sorgt für Bedenken in Bezug auf die Sicherheit der Energieversorgung. «Der Pro-Kopf-Energieverbrauch steigt in allen grossen Schwellenländern bereits rasch an und wird das wohl auch weiter tun. Ohne weitere Effizienzsteigerungen und unter der Annahme der Konvergenz des Energieverbrauchs in Richtung des OECD-Niveaus denken wir, dass die zunehmende Energienachfrage aus wichtigen Schwellenländern nahezu das 2,5-Fache des aktuellen Gesamtbedarfs für Europa und die USA zusammen ausmacht», sagt Eugène Klerk aus dem Bereich Global Thematic & ESG Research bei der Credit Suisse. Effizienzsteigerungen, insbesondere in Bezug auf den Transport von Erdölprodukten und Biokraftstoffen, dürften in den kommenden Jahren erreicht werden, aber das reicht noch nicht aus. Daher besteht ein dringender Bedarf an neuen Energielösungen – wie die Lösung des Energiespeicherproblems, das mit Verbesserungen bei der Batterietechnologie zusammenhängt – sowie einer stärkeren Nutzung erneuerbarer Energiequellen. «Die Speicherung ist der heilige Gral und wird möglicherweise für die grösste Umwälzung der Branche seit Jahrzehnten sorgen», erklärt Vincent Gilles, Leiter European Utilities Research.

Lösung des Speicherproblems würde die gesamte Branche umgestalten

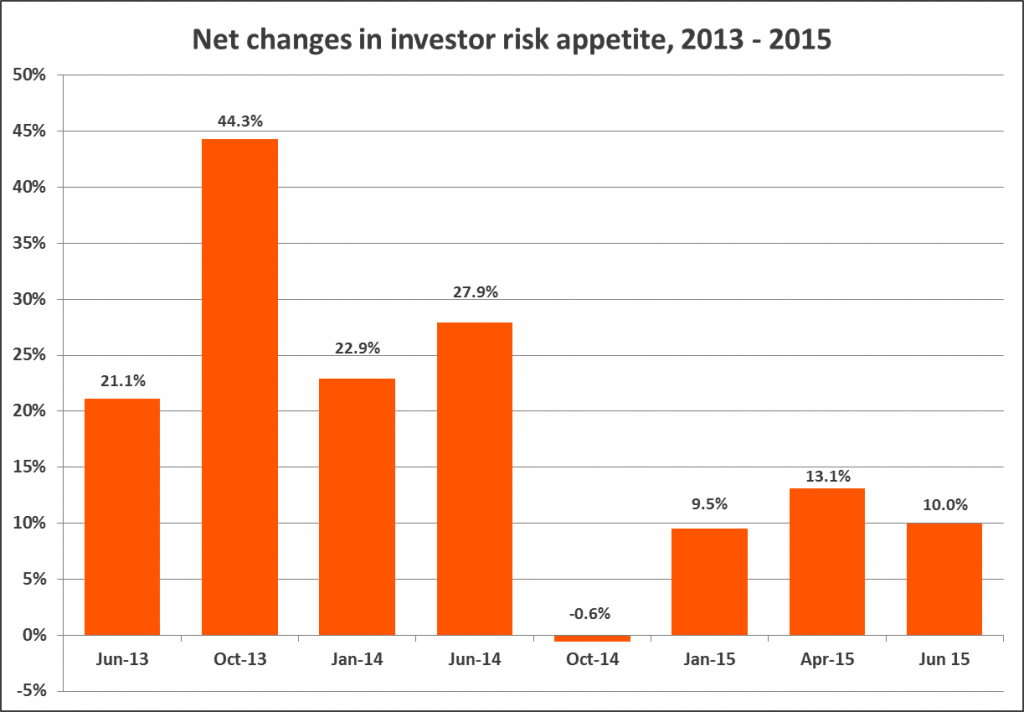

Kein Industrieland würde es akzeptieren oder könnte es sich leisten, länger als ein paar Minuten ohne Strom zu sein. Da Strom nicht gespeichert werden kann, neigt das traditionelle Geschäftsmodell der Energiebranche zur Überkompensation für die Sicherstellung der Stromversorgung, was die Spitzenlasterzeugung zu einem sehr rentablen Teil ihrer Geschäfte macht. «Eine günstige und zuverlässige Speicherung eliminiert diesen Anreiz und würde sich äusserst negativ auf die Rentabilität der traditionellen Stromerzeugung auswirken», so Vincent Gilles. Die heutigen Energiepreise werden jedoch grösstenteils weiterhin durch Subventionen verfälscht und verlangsamen so den scheinbar offensichtlichen Trend in Richtung wettbewerbsfähiger sauberer Energie. Allein in diesem Jahr sollen, IWF-Schätzungen zufolge, die globalen Energiesubventionen USD 5,3 Bio. erreichen, wobei Kohle am stärksten profitieren wird. (Abb. 1.) «Würden die Rohstoffpreise die Kosten (der örtlichen Umweltbelastung) voll widerspiegeln, wären die Öl-, Erdgas- und Kohlepreise um ein Vielfaches höher als zurzeit», meint Vincent Gilles und fügt hinzu, dass «eine effiziente Preisgestaltung den Ruf nach nicht fossilen Brennstoffen steigern würde.»

Energiespeicherkapazitäten – ein völlig unterentwickelter Markt

Die weltweiten Speicherkapazitäten liegen derzeit bei nur 2,2 Prozent der jährlichen globalen Energieproduktionskapazitäten; das Wachstumspotenzial scheint also solide zu sein. Um dies zu erreichen, konzentriert sich die Forschung derzeit auf neue Materialien, neue chemische Zusammensetzungen für alternative Batteriearten und die Entwicklung von Strategien zur anderweitigen Verwendung von Elektrofahrzeugbatterien. Die Lösung des Energiespeicherproblems ist daher tatsächlich der Schlüssel, um erneuerbare Energien wie Solarenergie attraktiver zu machen. Warum? Da erneuerbare Energien unter dem Effekt der Unbeständigkeit leiden. Solar- oder Windenergie werden beispielsweise dann produziert, wenn sie nicht benötigt werden oder umgekehrt. «Die Steigerung der Speicherkapazität würde die Unbeständigkeit reduzieren. Darüber hinaus würde die Existenz grösserer Speicherkapazitäten im gesamten Versorgungsnetz die Stromqualität und Zuverlässigkeit der (Energie-)Versorgung umfassender verbessern», so Eugène Klerk. Branchenexperten gehen davon aus, dass die Speicherkosten zwischen 2012 und 2030 um bis zu 75 Prozent sinken könnten. «Diese Tatsache gepaart mit fallenden Photovoltaik-Modulpreisen sollte eine integrierte Solar-Speichereinheit gegenüber anderen Energiequellen wettbewerbsfähig machen», unterstreicht Eugène Klerk.

«Neue Energie» bald rentabler als «alte Energie»

Alternative Energiequellen werden effizienter und dadurch wesentlich günstiger. Erträge aus alternativen Energiequellen steigen folglich schnell an, während jene traditioneller Stromerzeugungsunternehmen sinken. «‹Neue Energie› wird wahrscheinlich innerhalb von fünf Jahren, auf nicht subventionierter Basis, rentabler für Anleger sein als ‹alte Energie›», betonte Vincent Gilles. Einer der wichtigsten Treiber ist der zunehmende Kostenrückgang in der «ersten Generation» alternativer Energiequellen wie Wind- und Solarenergie. In vielen Regionen ist Onshore-Windenergie schon bei «Netzparität», d. h., die Wettbewerbsfähigkeit mit fossilen Brennstoffen wurde erreicht. Die Entwicklung bei der Solarenergie sieht ähnlich aus. Die Kosten für Solar-Grossanlagen sind seit 2011 um 60 Prozent gesunken, wodurch Solarenergie (ohne jegliche Subventionen) in mindestens 15 Ländern bezüglich der Kosten und gegenüber den Baukosten eines neuen Erdgaskraftwerks konkurrenzfähig ist. Im Vergleich zu Kohle ist Solarenergie zwar noch nicht wirtschaftlich, sie ist aber nur ca. 25 Prozent davon entfernt. Im letzten Jahr machte Solarenergie fast ein Drittel der neu erstellten Erzeugungskapazitäten in den USA aus, eindeutig getrieben durch sinkende (Installations-)Kosten. «Wir sind der Meinung, dass das Solarwachstum unterschätzt wird und bis 2040 nahezu 21 MMBoe (Mio. Barrel Öl-Äquivalent) entsprechen könnte. Trotz dieser Wachstumsgeschwindigkeit würden fossile Brennstoffe immer noch mehr als 70 Prozent der Energieversorgung ausmachen, mit erheblichen CO2-Emissionen von Kohlekraftwerken und mit einer Unsicherheit im Ölkomplex durch den zugrunde liegenden Rückgang der bestehenden Produktion. Durchsetzungsfähigere Energieeffizienz und Energieumwandlung scheinen erforderlich», so Edward Westlake, Co-Leiter von Global Equity Oil and Gas Research. (Abb. 2)

Batteriekosten sinken rascher als erwartet

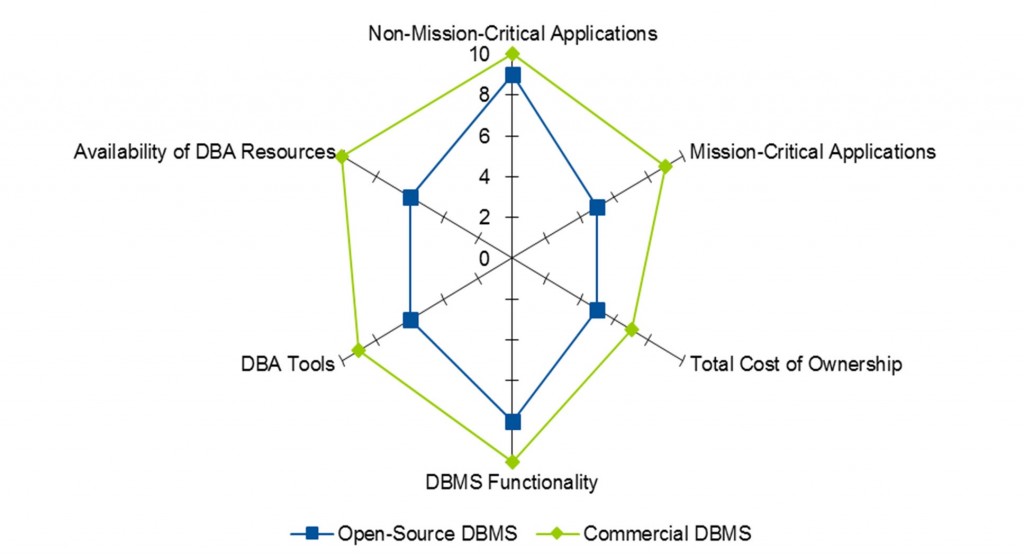

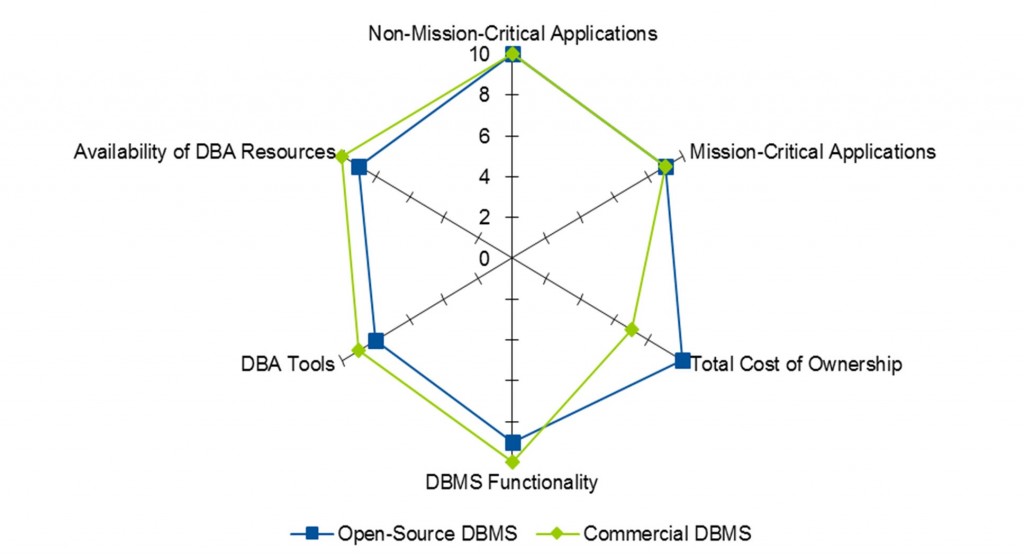

Bessere Energiespeicherung und der Elektrofahrzeugmarkt hängen direkt mit den Batteriekosten zusammen. «Die aktuellen Batteriepreise liegen tatsächlich unter dem Niveau, das Branchenexperten für diesen Zeitpunkt prognostiziert hatten», meint Dan Galves, Research-Analyst US Automotive and Auto Parts. Das Beispiel von Tesla, dem Hersteller reiner Elektroautos, zeigt, dass batteriebetriebene Autos viel mehr als ein Nischensegment sind. «Es gibt keinen Grund, warum der Rest der Branche nicht aufholen könnte», so Galves. Der Marktanteil von Teslas Modell S hat in seinem Preissegment fast 20 Prozent erreicht – trotz Lieferengpässen, einem unausgereiften Vertriebssystem und ohne Werbung. «Die wachsende Nachfrage nach Elektroautos wird für höhere Investitionen in Batteriekapazitäten sorgen, was die Kosten weiter senken wird. Diese Batterien zur Energiespeicherung schaffen ein stabileres (Elektrizitäts-)Netz, da sie in der Regel ausserhalb der Spitzenzeiten geladen werden, was einen grösseren Anteil erneuerbarer Energien an der Stromerzeugung ermöglicht», stellt Dan Galves fest. All diese Faktoren ermöglichen billigeren Strom, was im Gegenzug die Betriebskosten von Elektrofahrzeugen weiter senkt. Das wiederum sorgt für höhere Volumina, was zu niedrigeren Batteriekosten führt und so die Akzeptanz von Elektrofahrzeugen noch weiter steigert. Die Zahl der Elektro-Modelle dürfte daher in den kommenden Jahren rapide steigen. (Abb. 3) Die Reichweite reiner Elektroautos wächst rasch. So erreicht Tesla bereits eine Reichweite von über 322 Kilometern. Laut jüngsten Ankündigungen werden auch diverse Modelle anderer Autohersteller diesen Meilenstein bis 2020 erreichen. Traditionelle Autobauer können sich nicht länger auf ihren Lorbeeren ausruhen.

Bildquelle / Lizenz: Alle Bilder Copyright Credit Suisse; bis auf Aufmacher: flickr / tlegeltuf (CC BY-SA 2.0)

Quelle des Textes: Credit Suisse