Wie Hochleistungsdrähte die E-Mobilität revolutionieren

Gastbeitrag von Harald Lackner, Chief Sales Officer (CSO), bei HPW.

Wickeldrähte in Elektromotoren wirken auf den ersten Blick nur wenig innovativ. Doch spätestens mit der Energiewende und dem weltweiten Aufstieg der E-Mobilität wurden Drähte von einem „Allerweltsprodukt“ zu einem technischen Entscheidungsfaktor im Design und in der Entwicklung von automotiven Elektromotoren der neuesten Generation.

Ohne leistungsfähige Drähte mit Spezialbeschichtungen würden beispielsweise Windräder auf hoher See die enormen Qualitätsansprüche in Bezug auf Betrieb und Wartung nicht erfüllen. Schnellladen von Elektrofahrzeugen und die Elektrifizierung von LKW’s wäre utopisch.

Ein zunächst gewöhnlich wirkender Kupferdraht wird je nach Formgebung und Materialzusammensetzung der Isolation somit zum regelrechten Innovator für die E-Mobilitäts-Branche und trägt substanziell zum Erfolg der Elektrifizierung von Industrie, Energiegewinnung und Mobilität bei.

„HPW liefert High-Tech Draht der Zukunft von Österreich in die Welt.“

Hightech-Drähte: Die drei „L“ sind entscheidend

Technologieführer in dem Bereich – wie u.a. der österreichische Hidden Champion HPW, der sich auf die Produktion von High-Tech-Drähten spezialisiert hat – haben in den vergangenen Jahren Drähte kontinuierlich weiterentwickelt und somit technologisch erwünschte Entwicklungen ermöglicht. Ausschlaggebend sind die drei „L“: Leistung, Lebensdauer und Ladezeit. Um die Leistung in Elektromotoren zu steigern, wurden die Zwischenräume zwischen den gewickelten Drähten reduziert, indem diese nicht mehr rund, sondern flach und quadratisch hergestellt wurden. Das erlaubt mehr leitungsfähiges Material im festen Teil des Motors, dem sogenannten Stator, was wiederum die Leistungsfähigkeit deutlich erhöht.

Neben Kupfer kommt in Hochleistungsdrähten mittlerweile auch das wesentlich leichtere Aluminium zum Einsatz. Solche Aluminium-Flachdrähte werden beispielsweise als biegbare Stromschienen, sogenannten Busbars, in E-Fahrzeugen verbaut. Diese Aluminium-Busbars sind ein wichtiger effizienzsteigernder Bestandteil der E-Mobility und untermauern den kontinuierlichen Fortschritt in der Material- und Komponentenentwicklung in dem Bereich. Die neuartigen Bauteile kommen in Fahrzeugen als Verbindung der elektrischen Komponenten wie z. B. der Batteriemodule untereinander oder als Verbindung zwischen Batterie und Elektromotor zum Einsatz. Aluminium-Busbars weisen ein bis zu 50 % geringeres Gewicht gegenüber herkömmlichen Flachleitern bei gleicher elektrischer Leitfähigkeit aus. Damit werden sie zu einer entscheidenden Komponente für die nächste Generation leistungsstarker Fahrzeuge.

Damit ein Draht den Elektromotor effizienter und langlebiger macht, ist insbesondere die Materialbeschaffenheit der Isolation von hoher Bedeutung. Wird ein Wickeldraht beispielsweise mit einer speziellen Polyetheretherketon-Isolierung, auch PEEK genannt, beschichtet, ermöglicht er Anwendungen im Bereich der E-Mobilität mit Spannungen von 800V und darüber.

Nur so können die entsprechenden Leistungen für Commercial Vehicles wie Elektrobusse oder Elektro-Lkw erreicht werden. Diese Fahrzeuge werden immer gefragter in der E-Mobilitätsbranche, denn laut Marktstudien soll die Neuzulassung von elektrisch betriebenen Lkw bis 2040 auf über 85 % in den USA, Europa und China ansteigen. Doch dafür müssen alle Komponenten extrem robust sein – schließlich sollen Laufleistungen von bis zu einer Million Kilometer erreicht werden. PEEK-isolierte Flachdrähte sind durch ihre thermischen und elektrischen Eigenschaften in der Lage auch Schnellladezyklen zu ermöglichen, ohne dass es zu einem frühzeitigen Verschleiß kommt. Ohne Schnellladen, gerade im Schwerlastverkehr, ist eine Elektrifizierung des Straßengüterverkehrs somit undenkbar.

Klimawandel durch Innovation bekämpfen

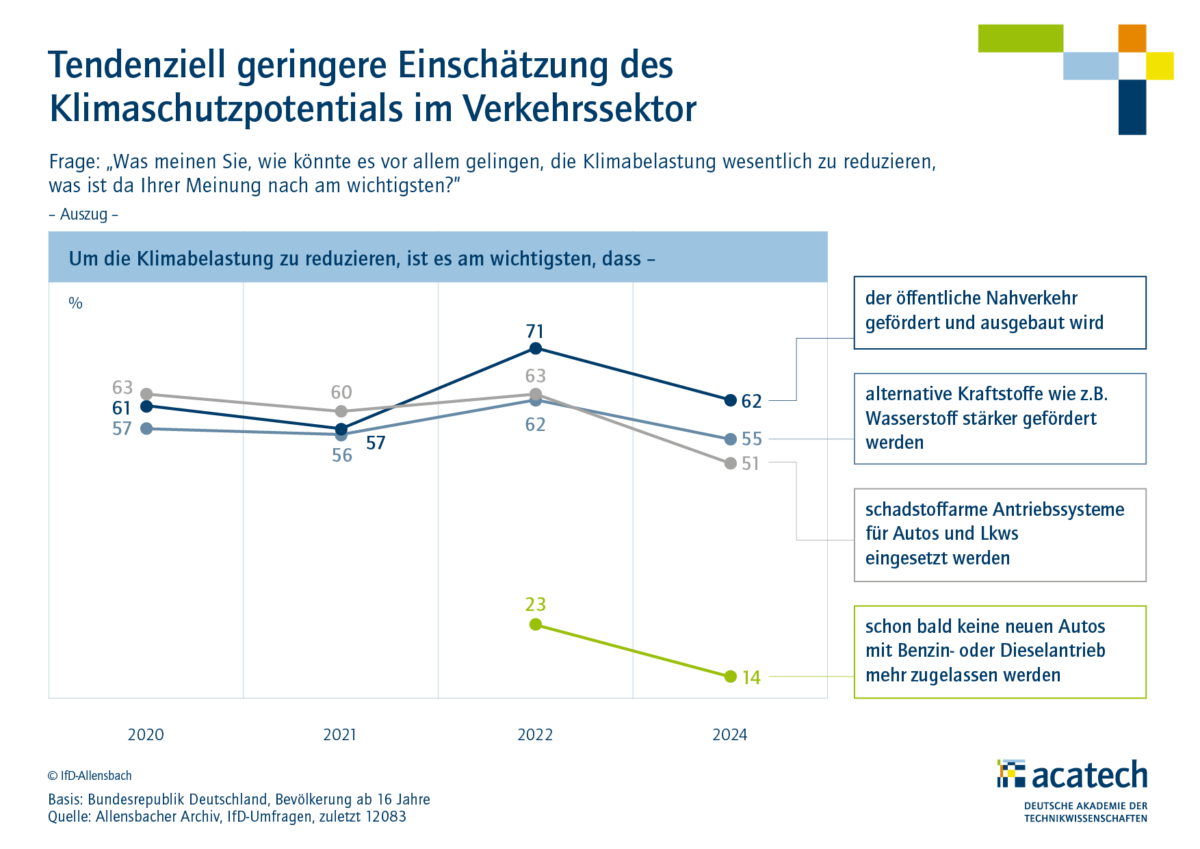

Wenn von nachhaltigen Technologien und der E-Mobilität die Rede ist, stehen oft Innovationen wie Batterietechnologien, Solarpanels oder die Kernfusion im Mittelpunkt. Doch um den technologischen Wandel voranzutreiben, braucht es ebenso eine ausgeprägte Innovationskraft in vermeintlich „profanen“ Dingen, wie beispielsweise Drähte. Solch altbewährte Produkte gilt es durch kontinuierliche Innovationen anzupassen, um die großen Megatrends wie die Elektromobilität überhaupt zu ermöglichen. Mit Hightech-Drähten für die Zukunft kann der Ausbau der erneuerbaren Energie-Landschaft weltweit beschleunigt werden. Nur durch solche hochtechnologischen Entwicklungen kann es gelingen, die Herausforderungen unserer Zeit, wie z. B. den Klimawandel, zu meistern. Modernste Drähte leisten dabei einen signifikanten Beitrag.

Über den Autor:

Mag. Harald Lackner ist als Chief Sales Officer (CSO)bei HPW für den Bereich Vertrieb & Marketing gesamtverantwortlich.