Die resilienten Unternehmen der Zukunft kooperieren mit ihren Wettbewerbern

Autoren: Gerrit Hoeborn, Daniel Spindler, Lukas Stratmann

Sixt, die Autovermietung, die immer wieder durch spontane und freche Werbung auffällt, hat sich im letzten Jahrzehnt zunehmend von einem reinen Mietanbieter zu einem globalen Mobi-litätsdienstleister entwickelt. Spätestens seit 2019 und dem Start der Mobilitätsplattform „Sixt One“ ist klar, dass Sixt auf ein Ökosystem für klimafreundliche Mobilität setzt (Sixt SE, 2022a). Ebendieser Mobilitätsplattform liegt die Sixt-App zugrunde. Über diese können nicht nur Mietwagen, sondern auch Shared-Fahrzeuge, Shared-Fahrräder, Elektroroller, Ladestati-onen und Dienstleistungen wie Taxifahrten oder Ride-Hailing gebucht werden(Sixt SE, 2022a). Viele dieser komplementären Angebote und Dienstleistungen liegen außerhalb der direkten Kontrolle von Sixt, da sie von verschiedenen Akteuren des Ökosystems bereitgestellt werden. Hierfür kooperiert Sixt auch mit vermeintlichen Wettbewerbern, etwa der Carsharing-Plattform FreeNow oder lokalen Taxiunternehmen.

Das Beispiel zeigt besonders deutlich, dass momentan ein echter Paradigmenwechsel in der strategischen Ausrichtung einiger Unternehmen stattfindet: vom darwinistischen „Survival of the fittest“ und der damit verbundenen unerbittlichen Konkurrenz der Wettbewerber um Res-sourcen und Marktanteile bzw. Kunden, hin zu Business Ecosystems. Diese sind typischerweise durch eine Beziehung der beteiligten Akteure gekennzeichnet, die sich als Koopetition, also einem Mix aus Wettbewerb (engl. „competition“) und Kooperation (engl. „cooperation“), beschreiben lässt.

Die wertvollsten und erfolgreichsten Unternehmen der Welt, wie Amazon, Alphabet oder Microsoft, agieren nicht mehr isoliert gegeneinander, sondern kooperieren in Business Eco-systems, um Kunden damit individualisierte Serviceangebote zu offerieren.

Was sind Business Ecosystems und Koopetition?

Der Begriff „Ökosystem“ wurde erstmals in den 1930er Jahren vom britischen Botaniker Tansley (1935) geprägt. Organismen können demzufolge in einem Ökosystem nicht isoliert betrachtet werden, da sie in fortlaufenden Wechselwirkungen mit ihrer Umwelt stehen. Sie konkurrieren und kooperieren miteinander, passen sich an ihre Umgebung an und entwickeln sich gemeinsam weiter (Tansley, 1935).

Der Begriff „Business Ecosystems“ wurde durch den US-amerikanischen Wirtschaftsprofes-sor James Moore (1993) geprägt, indem er das Konzept des natürlichen Ökosystems auf Unternehmen anwendete. Er zeigte auf, dass sich langfristig erfolgreiche und damit resiliente Unternehmen in Anlehnung an ein natürliches Ökosystem organisieren.

Heutzutage betrachten sich Unternehmen daher zunehmend nicht mehr als isolierte Einheit, sondern als Teil eines größeren Systems, das aus einer Vielzahl von Akteuren besteht – wie von Moore (1993) postuliert. Analog zu einem natürlichen Ökosystem arbeiten diese Unter-nehmen kooperativ und wettbewerbsorientiert zusammen. Mit ihrem Ökosystem wollen sie so das bestmögliche Angebot für ihre Kunden schaffen. Sixt hat erkannt, dass Mobilität nicht mehr getrennt betrachtet werden darf, sondern man die meisten Personen dann erreicht, wenn ein umfangreiches kundenorientiertes Angebot geliefert werden kann.

Business Ecosystems repräsentieren damit eine neue Form der Organisation von Unternehmen. Sie geht über Unternehmensgrenzen hinaus (De Meyer & Williamson, 2020). Unternehmen bieten sich ergänzende Produkte und Dienstleistungen an, die modular unterneh-mensübergreifend kombiniert werden, um gemeinsam individuelle Kundenwünsche erfüllen zu können.

Das Forschungsinstitut FIR an der RWTH Aachen prägte dazu eine Definition, nach der Unternehmen im Business Ecosystem autonom agieren, jedoch in voneinander abhängigen Be-ziehungen zueinander stehen, um die Erfüllung des Werteversprechens zu erreichen (Conrad et al., 2022). Koopetition zeichnet sich dadurch aus, dass Unternehmen auf der einen Seite kooperieren, auf der anderen Seite aber im Wettbewerb stehen. Das bedeutet: Jedes einzelne Unternehmen trägt zum Erfolg des Ökosystems bei, konkurriert gleichzeitig aber auch mit den anderen beispielsweise um Ressourcen und Kunden (Wieninger et al., 2019).

Sixt: Business Ecosystems und Koopetition in der Praxis

Anhand des bereits aufgezeigten Ökosystems von Sixt lässt sich Koopetition sehr gut verdeutlichen. Sixt bietet über die Mobilitätsplattform „Sixt One“ nicht nur Fahrzeuge aus der eigenen Flotte als Mietwagen oder im Carsharing an, sondern öffnet die Plattform auch für Partnerunternehmen. Diese können ihre Angebote und Dienstleistungen modular über die Plattform vermitteln und tragen damit zum Werteversprechen des Ökosystems bei. So können zum Beispiel Elektroroller von TIER, Shared-Fahrräder von nextbike – Europas größtem Bike Sharing Anbieter – oder Fahrten von lokalen Taxiunternehmen über die Sixt-App ge-bucht werden (Sixt SE, 2019, 2022b). Darüber hinaus erweiterte Sixt das Ökosystem durch eine Partnerschaft mit FreeNow, betrieben durch BMW und Daimler, den beiden größten Wettbewerbern im Bereich Carsharing (Handelsblatt, 2022). Die Unternehmen kooperieren, um die verfügbare Flotte an Carsharing Fahrzeugen in den Städten effizient zu erhöhen. So lässt sich ihr Werteversprechen der klimafreundlichen Mobilität gegenüber ihren Kunden bes-ser erreichen. Im Ökosystem darf jedes angeschlossene Unternehmen seine Preise und Stärke der Kooperation autonom festlegen, gemeinsam konkurriert man um denselben Kun-denkreis. Ziel ist es, mit dem erweiterten Angebot mehr Kunden als bisher anzusprechen, so dass am Ende eine Win-Win-Situation für alle Seiten entsteht.

Der Business Ecosystem-Ansatz erlaubt es Unternehmen zudem, externe Veränderungen schneller zu verstehen und darauf reagieren zu können (Hannan & Freeman, 1984; Teece, 2016). Somit stellen Business Ecosystems und die damit verbundene Koopetition der Unter-nehmen eine Basis für die Resilienz von Unternehmen dar. Am Sixt-Beispiel zeigt sich, dass durch die Integration weiterer Mobilitätsservices einfacher auf externe Schocks reagiert wer-den kann. Sollten etwa Events oder verkehrspolitische Maßnahmen das Autofahren innerorts unmöglich machen, kann schnell auf E-Bikes gewechselt werden. Andersherum ist bei Regenschauern ein direkter Umstieg vom Rad auf das Auto möglich. Diese Beispiele zeigen: Im Ökosystem stehen der Kunde und dessen Bedürfnisse im Mittelpunkt, die flexibel und schnell erfüllt werden.

Sind Business Ecosystems und Koopetition immer vorteilhaft?

Die klare Antwort: Nein! Wettbewerbern Zugang zu den eigenen Kunden zu geben, bedarf einer sauberen Strategie und einer vorgelagerten Analyse. Anderenfalls entstehen ungewollte Abhängigkeiten und weitere unerwünschte Nebeneffekte.

Im ersten Schritt ist daher zu analysieren, in welchem Ökosystem das eigene Unternehmen aktiv ist und welche Beziehungen es zu den weiteren beteiligten Unternehmen hat. Die ge-wonnenen Erkenntnisse dienen dazu, die Strategie anzupassen und durch entsprechende Maßnahmen die eigene Position im Ökosystem zu festigen oder zu verändern.

Wieninger et al. (2019) entwickelten ein leicht verständliches visualisiertes Modell zur strategischen Analyse der Abhängigkeiten von Business Ecosystems. In dieser Analyse steht im Mittelpunkt, welche Unternehmen, welche Beiträge zum Erreichen des Werteversprechens des Ökosystems erfüllen (Wieninger et al., 2019). Dafür wird nicht nur das Level an Kooperation und Wettbewerb zwischen den Unternehmen bewertet, der sogenannte Koopetitionsindex, sondern auch, inwiefern das Unternehmen ersetzbar bzw. wie erfolgskritisch für das Ökosys-tem ist (Wieninger et al., 2019). Die Austauschbarkeit eines Unternehmens zeigt, welche Verhandlungsmacht aber auch welche Abhängigkeit das Unternehmen gegenüber dem zentralen Akteur – dem Orchestrator – im Ökosystem hat. Je unverzichtbarer ein Unternehmen ist, desto größer ist seine Verhandlungsmacht und somit die Fähigkeit, höhere Profite zu realisieren. (Wieninger et al., 2019).

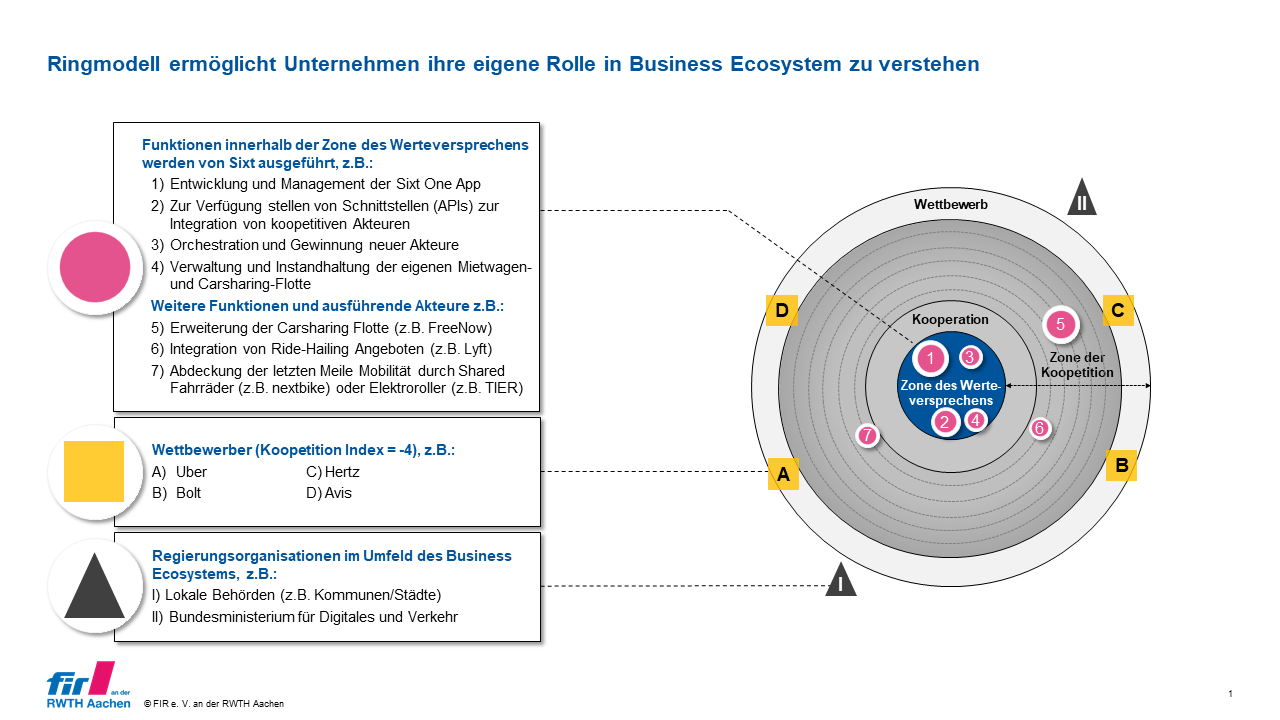

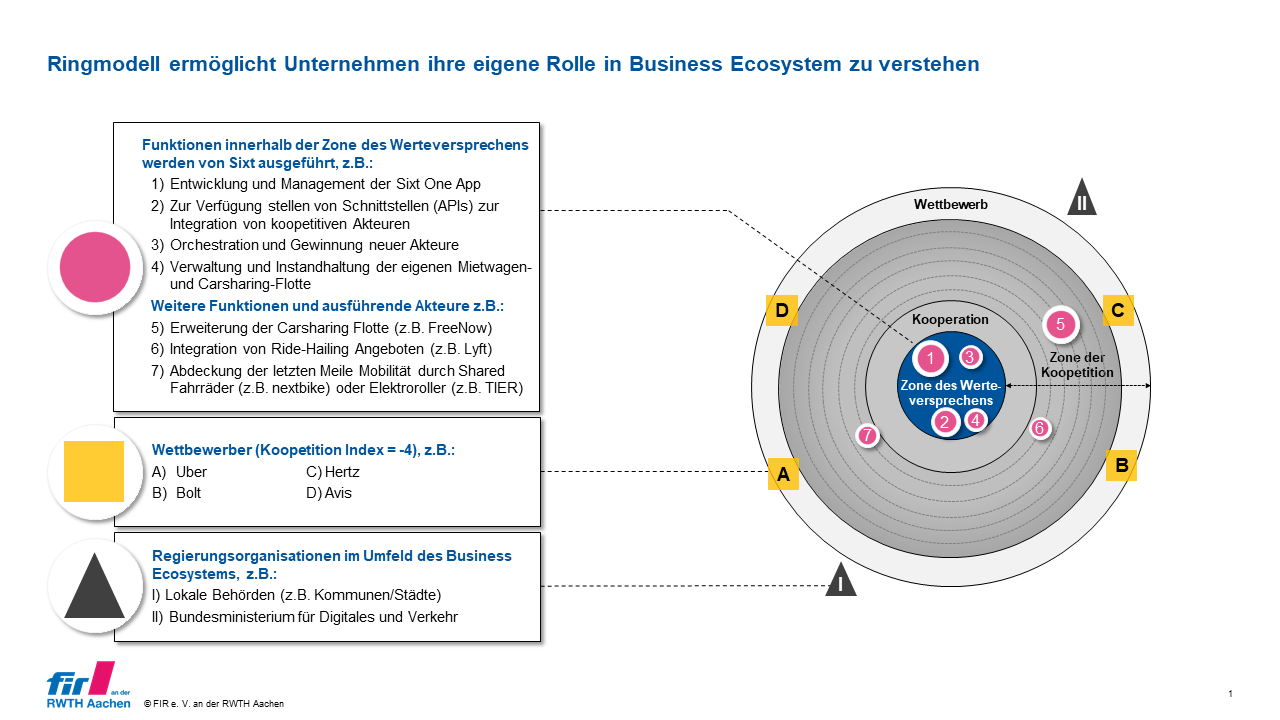

Zur Verdeutlichung zeigt die folgende Grafik einen exemplarischen Ausschnitt des Mobilitätsökosystems von Sixt und der darin verbundenen Akteure.

[Abbildung 1: Ringmodell zur Visualisierung des Business Ecosystems und der Koopetition der Akteure am Beispiel der „Sixt-One“-Plattform, i. A. a. Wieninger et al., 2019]

Die von Sixt ausgeführten Funktionen im Ökosystem sind innerhalb der „Zone des Werteversprechens“ abgebildet. Zu den Orchestrationsaufgaben gehören unter anderem die Bereitstel-lung der technologischen Infrastruktur für die Sixt One App sowie die Integration von weiteren Akteuren über Schnittstellen. Außerdem schafft Sixt Anreize zur Teilhabe im Ökosystem, schließt Kooperationen mit wichtigen Akteuren und verwaltet die eigene Mietwagen- bzw. Carsharing-Flotte. Die Beiträge der weiteren Beteiligten werden im Spannungsfeld der Koopetition eingeordnet. Während Tätigkeiten, die ausschließlich durch Kooperation gekennzeichnet sind, dem nächsten inneren Ring zugeordnet sind, werden reine Wettbewerber bzw. konkur-rierende Ökosysteme dem äußersten Ring zugeordnet (Wieninger et al., 2019). Dazwischen liegen die Tätigkeiten, die sich aus einem Mix von Kooperation und Wettbewerb zusammensetzen.

Reine Wettbewerber im Fall von Sixt sind etwa der Mobilitätsdienstleister Uber oder andere Mietwagenunternehmen wie Hertz bzw. Avis. Einen höheren Koopetitionsindex und damit einen Mix aus Kooperation und Wettbewerb weisen z. B. die integrierte Carsharing-Flotte von FreeNow (Nr. 5), Ride-Hailing Angebote von Lyft (Nr. 6) und Anbieter der „letzten Meile“ auf, etwa nextbike oder TIER (Nr.7). Die Größe der Kreise verdeutlicht die Ersetzbarkeit einer Funktion, d. h. je größer der Kreis, desto schwerer ist die damit verbundene Tätigkeit zu ersetzen.

Strategien für den langfristigen Unternehmenserfolg resilienter Unternehmen im Business Ecosystem

Um die Resilienz zu steigern müssen die Orchestratoren analysieren, in welchem Ökosystem sie aktiv sind und welche Beziehungen sie zu den beteiligten Unternehmen haben. Damit schaffen sie die Grundlage, um die richtigen Konsequenzen ziehen, ihre Strategie anpassen und durch eine entsprechende Positionierung ihre Abhängigkeit von anderen Akteuren im Ökosystem reduzieren.

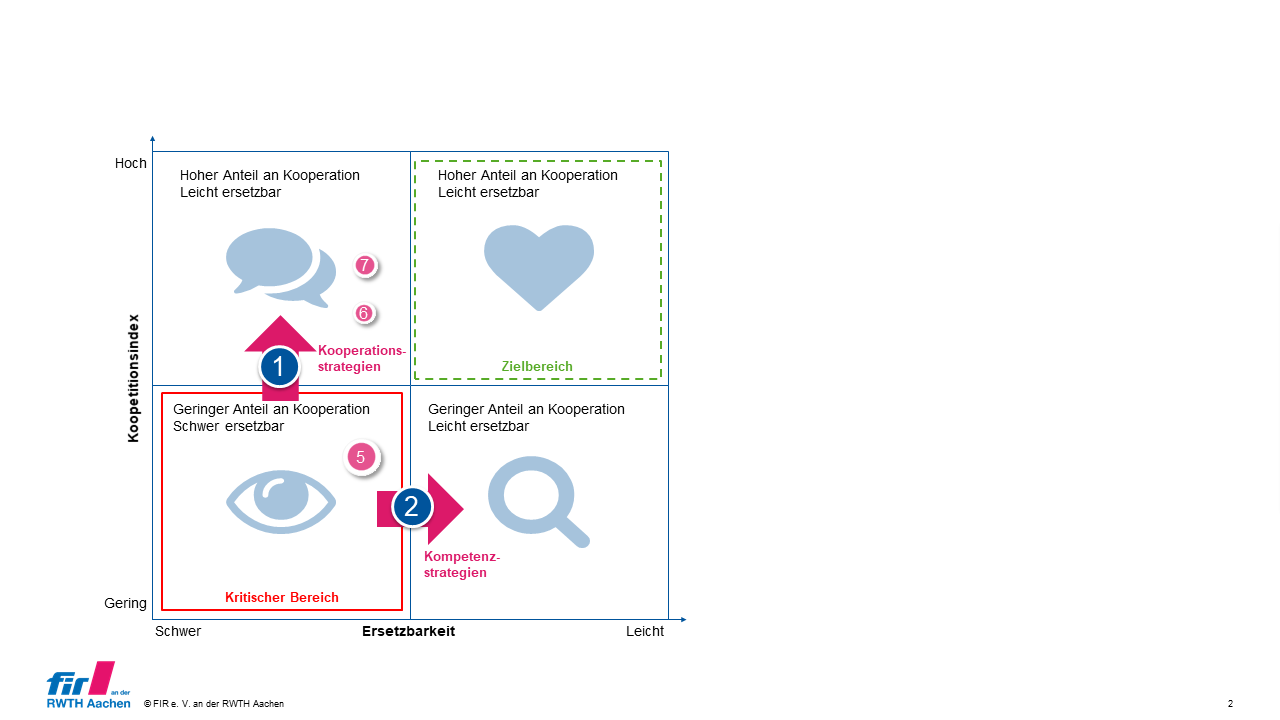

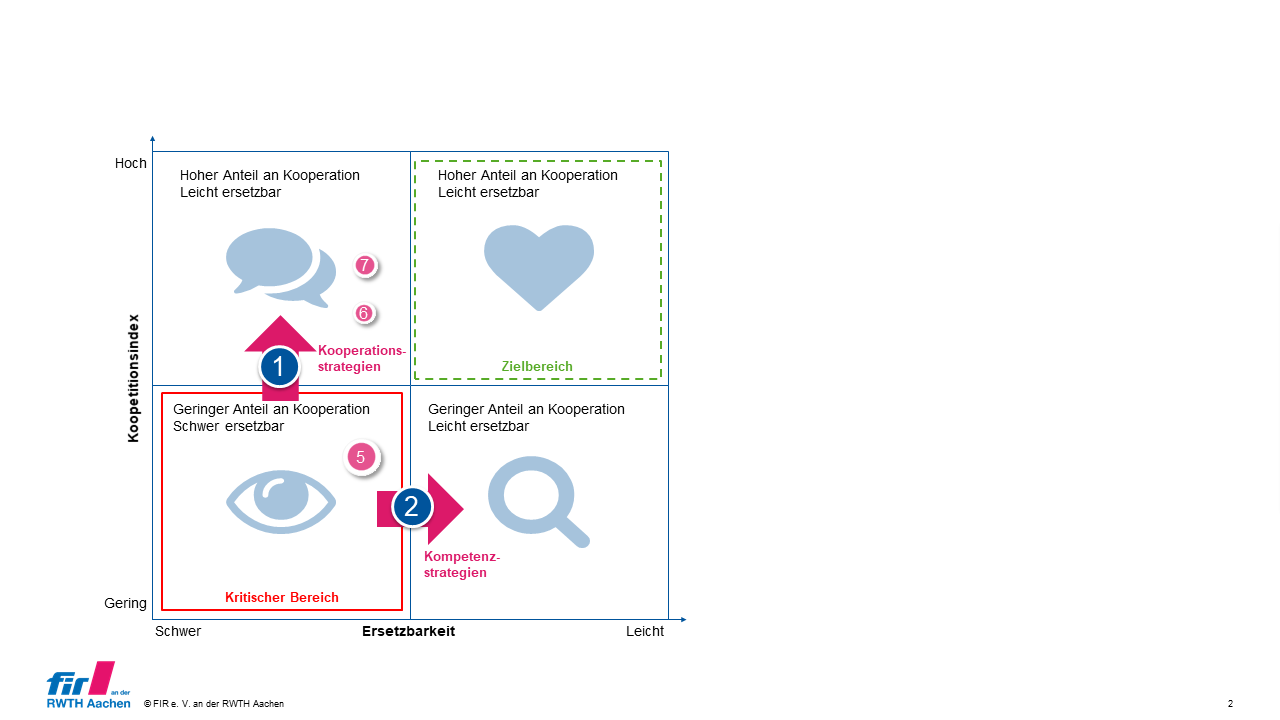

Kritisch sind vor allem Beziehungen des eigenen Unternehmens zu anderen Akteuren, die ein geringes Level an Koopetition aufweisen und zu denen gleichzeitig eine hohe Abhängigkeit zu besteht, da ihre Funktionen im Ökosystem schwer ersetzbar sind (siehe Abb. 2). „Sixt One“ begibt sich durch die Integration der Carsharing-Flotte von FreeNow in die Abhängigkeit zu einem Anbieter mit einer starken Markposition bei im Free-Floating-Carsharing. Ein Ersatz von FreeNow durch einen alternativen Anbieter ist schwierig. Weiterhin ist die Flotte wichtig für das Wertangebot von Sixt One. Es bedarf also einer Strategie, um die beschriebene erfolgskritische Abhängigkeit zu reduzieren.

[Abbildung 2: Resilienz-Matrix und Ableitung von Resilienz-Strategien für Business Ecosystems, i. A. a. Wieninger et al., 2019]

Die folgenden zwei Strategien unterstützen das eigene Unternehmen dabei, sich aus einer abhängigen Position herauszubewegen und somit die Resilienz sowie den damit verbundenen langfristigen Erfolg zu erhöhen:

1. Kooperationsstrategien: Um das Risiko der Abhängigkeit von schwer ersetzbaren Unternehmen zu reduzieren, sollten langfristige Kooperationen mit diesen Unterneh-men angestrebt werden. Hierfür eigenen sich vor allem Joint Ventures oder strategi-sche Allianzen.

2. Kompetenzstrategien: Für Unternehmen, mit denen keine Kooperation realisierbar ist, sollten Maßnahmen ergriffen werden, diese Unternehmen einfacher zu subsituie-ren. Als Beispiele seien hier Investitionen in Technologiestandards oder in Start-Ups genannt, die als Konkurrenten agieren.

Im Fall von FreeNow wäre die Kooperationsstrategie ein erster sinnvoller Schritt für „Sixt O-ne“, um die Resilienz des Business Ecosystems zu erhöhen. So könnte die Kooperation zwi-schen Sixt und FreeNow z. B. durch eine strategische Allianz im Sinne einer langfristig stei-genden Gewinnbeteiligung gefestigt werden.

Die Quintessenz: In Business Ecosystems denken? Unbedingt. Koopetition zulassen? Ja, aber nur mit einer klaren Strategie. Führen Business Ecoystems zu höherer Resilienz von Unternehmen? Durch resilientere Werteversprechen, ja. Aber auch hier gilt Nur ein gesundes Business Ecosystem trägt zur langfristigen Resilienz von Unternehmen bei. Ein Weg, um Ab-hängigkeiten zu erkennen und langfristig gesunde Business Ecosystem zu fördern, ist die strategische Business-Ecosystem-Analyse, die hier am Beispiel von „Sixt One“ vorgestellt wurde und beim Aufbau von Ökosystemen von zentraler Bedeutung für Unternehmen sein kann.

Nähere Informationen zum Aufbau von Business Ökosystemen bietet das FIR an der RWTH Aachen Interessierten auf seiner Website unter: https://www.fir.rwth-aachen.de/forschung/business-transformation/ecosystem-design/ und mit dem kostenfrei verfügbaren Whitepaper „Seizing the Potentials of Ecosystems“.

Die Autoren:

Gerrit Hoeborn, M. Sc. M.Sc.

Bereichsleiter Business Transformation

Tel.: +49 241 47705-302

E-Mail: Gerrit.Hoeborn@fir.rwth-aachen.de

Gerrit Hoeborn studierte Betriebswirtschaftslehre und Maschinenbau an der RWTH Aachen und der Tshinghua Universität. Er ist Leiter des Bereichs Business Transformation am Forschungsinstitut für Rationalisierung (FIR) an der RWTH Aachen. Seine Forschungsthemen fokussieren sich auf Business Ecosystems und digitale Geschäftsmodelle. Durch zahlreiche Beratungsprojekte in verschiedenen Industrien besitzt Gerrit Hoeborn umfangreiche Kennt-nisse im Bereich Ecosystem Design. In seinen Projekten untersucht er multilaterale Bezie-hungen zwischen Ecosystem-Akteuren, die damit verbundenen Transaktionen und inwieweit eine digitale Infrastruktur informationsbasierte Wertschöpfung ermöglicht.

Lukas Stratmann, M. Sc.

Fachgruppenleiter Ecosystem Design im Bereich Business Transformation

Tel.: +49 241 47705-317

E-Mail: Lukas.Stratmann@fir.rwth-aachen.de

Lukas Stratmann hat an der RWTH Aachen Wirtschaftsingenieurwesen mit Fachrichtung Maschinenbau studiert. Nach einer Station im Ausland begann er am FIR als Projektmanager und Doktorand für digitale und nachhaltige Transformationen. Dort leitet Lukas Stratmann innerhalb des Bereichs Business Transformation die Fachgruppe Ecosystem Design. Er un-terstützt Unternehmen dabei, Nachhaltigkeitsstrategien zu entwickeln und die Möglichkeiten der Industrie 4.0 zu nutzen, um im wirtschaftlichen Umfeld ökonomische, ökologische und soziale Nachhaltigkeitsziele zu erreichen.

Daniel Spindler, M. Sc.

Projektmanager Ecosystem Design im Bereich Business Transformation

Tel.: +49 241 47705-305

E-Mail: Daniel.Spindler@fir.rwth-aachen.de

Daniel Spindler hat an der Università Bocconi in Mailand International Management mit Fokus auf FinTech und Digitale Transformation studiert. Nach seinem Studium und einiger prakti-scher Erfahrung in der Unternehmensstrategie begann er am FIR an der RWTH Aachen als Projektmanager und Doktorand im Bereich Business Transformation. Innerhalb der Fach-gruppe Ecosystem Design bearbeitet Daniel Spindler vielfältige Industrie- und Forschungspro-jekte mit Fokus auf Nachhaltigkeit, Digitale Transformation und Finance.

Literatur

Conrad, R., Hoeborn, G., Neudert, P., & Betz, C. (2022). Seizing the Potentials of Ecosys-tems.

De Meyer, A. C. L., & Williamson, P. J. (2020). Ecosystem edge: Sustaining competitiveness in the face of disruption.

Handelsblatt. (2022). Free Now vermittelt künftig auch Mietwagen von Sixt. https://www.handelsblatt.com/unternehmen/handel-konsumgueter/carsharing-free-now-vermittelt-kuenftig-auch-mietwagen-von-sixt-/28183028.html

Hannan, M. T., & Freeman, J. (1984). Structural Inertia and Organizational Change. American Sociological Review(2), 149–164.

Moore, J. F. (1993). Predators and prey: a new ecology of competition. Harvard Business Review, 71(3), 75–86.

Sixt SE. (2019). Sixt baut integrierte Mobilitätsplattform ONE weiter aus: In Kooperation mit TIER sind in Kürze auch E-Scooter über die Sixt App buchbar. https://about.sixt.com/sixt-baut-integrierte-mobilitaetsplattform-one-weiter-aus-in-kooperation-mit-tier-sind-in-kuerze-auch-e-scooter-ueber-die-sixt-app-buchbar/

Sixt SE. (2022a). Ganzheitlich nachhaltig – Sixt beschließt weitreichendes Programm für mehr Klimaschutz. https://about.sixt.com/ganzheitlich-nachhaltig-sixt-beschliesst-weitreichendes-programm-fuer-mehr-klimaschutz/

Sixt SE. (2022b). Sixt baut Mobilitätsplattform ONE weiter aus und integriert Europas größten Bike Sharing Anbieter nextbike in die Sixt App. https://about.sixt.com/sixt-baut-mobilitaetsplattform-one-weiter-aus-und-integriert-europas-groessten-bike-sharing-anbieter-nextbike-in-die-sixt-app/

Tansley, A. G. (1935). The use and abuse of vegetational concepts and terms. Ecology – Ecological Society of America, 16(3), 284–307.

Teece, D. J. (2016). The Palgrave Encyclopedia Of Strategic Management. Business Eco-systems. Palgrave Macmillan.

Wieninger, S., Gotzen, R., Gudergan, G., & Wenning, K. M. (2019). The strategic analysis of business ecosystems: New conception and practical application of a research ap-proach. In 2019 IEEE International Conference on Engineering, Technology and Inno-vation (ICE/ITMC) (pp. 1–8). IEEE. https://doi.org/10.1109/ICE.2019.8792657

Aufmacherbild: ricardo-gomez-angel-WsEAiVwGrwo-unsplash