Helikoptergeld ist die bildhafte Bezeichnung für ein geldpolitisches Konzept. Es betrifft einen besonderen Fall der Ausweitung der Geldmenge durch Geldschöpfung. Dabei wird das neu geschaffene Zentralbankgeld nicht wie bei der Quantitativen Lockerung an die Banken gegen Anleihen, sondern direkt an Staat oder Bürger ausgezahlt. Ziel dieser extremen Form expansiver Geldpolitik ist es, durch vermehrte Konsumausgaben die Wirtschaft anzukurbeln, ein angestrebtes Inflationsziel zu erreichen beziehungsweise Deflation zu vermeiden oder zu vermindern. Das Konzept hat historische Vorläufer die teilweise auch praktisch umgesetzt wurden. Es wurde ab 2015 international intensiv und sehr kontrovers diskutiert.

Von Quantitativer Lockerung unterscheidet sich der direkte Transfer von Zentralgeld an Bürger oder Staat beim Helikoptergeld dadurch, dass das Helikoptergeld die Bilanz der Zentralbank nicht vergrößert. Bei Quantitativer Lockerung dagegen wechselt ein Wertpapier von der Geschäftsbank zur Zentralbank als Gegenleistung für das von der Zentralbank geschaffene und der Bank zur Verfügung gestellte Geld. Die Bilanz der Zentralbank wird also um den ausgegeben Betrag auf der Sollseite und den entsprechenden Gegenwert des Wertpapiers in der Zentralbank auf der Habenseite vergrößert.

„Helikoptergeld“ im Gedankenexperiment Friedmans 1969

Der Ausdruck „Helikoptergeld“ wurde erstmals 1969 von Milton Friedman verwendet. In seinem modellhaften Gedankenexperiment zur Illustration der Grundprinzipien seiner monetären Theorie des Geldes stellte Milton Friedman die Frage, was geschehen würde, wenn eine Zentralbank das von ihr gedruckte Geld in einen Helikopter laden und über den Bürgern einer Modell-Gemeinde abwerfen würden:

„Lasst uns annehmen, dass eines Tages ein Hubschrauber über diese Gemeinde fliegt und zusätzliche 1000 Dollar in Form von Geldscheinen abwirft, die natürlich von den Bewohnern hastig eingesammelt werden. Setzen wir weiter voraus, dass jeder überzeugt ist, dass dies ein einmaliges Ereignis sei, das niemals wiederholt wird.“

Im Unterschied zu den verbreiteten Interpretationen illustriert dieses Beispiel und sein Effekt bei Friedman nur die Neutralität der Geldmengenerhöhung, also gerade keine Anreizfunktion für den Konsum. Friedman setzte in seinem Beispiel zunächst außerdem voraus, dass jeder Mensch dieser Modell-Gemeinde nun doppelt soviel Geld habe wie vorher, nahm aber auch Vollbeschäftigung und Auslastung der Produktion an. Durch die Verdopplung der Geldmenge entstünde nach Friedmans Beispiel lediglich eine Verdopplung der Preise, weiter nichts.Friedman illustrierte damit Hauptprinzipien seiner monetären Theorie, wichtigster Punkt ist die Quantitätstheorie Friedmans: Es gibt ein stabiles Niveau von Geldmenge und Preisen. Die Geldmenge hat seiner Theorie nach keinen Einfluss auf die Realwirtschaft.

Das Konzept von Helikoptergeld ist hier also ein akademisches Gedankenexperiment, das ähnlich einer Parabel der Erläuterung des Funktionierens seiner monetären Theorie des Geldes dient. Später wurde das didaktische Beispiel Friedmans in eine Metapher für eine gezielte zins- und kreditlose Ausweitung der Geldmenge durch Transferzahlungen an Bürger zur Ankurbelung der Nachfrage oder zur Inflationssteigerung uminterpretiert.

Geschichte

Vorstellungen einer direkten Transferzahlung an Bürger oder einer Ausweitung der Geldmenge zur Staatsfinanzierung wurden schon vor der Diskussion um „Helikoptergeld“ von Major Douglas, dem Social Credit Movement und Silvio Gsell in seiner Freiwirtschaftslehre vertreten. Diese Konzepte wurden teilweise aufgrund der angeblichen Verbindungen oder Übereinstimmungen mit der Geldschöpfungspraxis sozialistischer oder faschistischer Regierungssysteme kritisiert.

Die erfolgreiche Wirtschaftspolitik Korekiyo Takahashis, des „japanischen Keynes“, während der Weltwirtschaftskrise beruhte auf monetärer Staatsfinanzierung zur Ankurbelung der Wirtschaft und Abwertung des Außenwertes der Währung. Es gelang Takahashi, die schwere Depression Japans in den 30er Jahren durch Abkopplung der Währung vom Goldstandard und direkte Finanzierung der Staatsausgaben ohne erhebliche inflatorische Wirkung zu bewältigen.

John Maynard Keynes hatte in seinem Werk Allgemeine Theorie der Beschäftigung, des Zinses und des Geldes vorgeschlagen, Geld in ungenutzten Bergwerken zu vergraben, wo es von Arbeitslosen ausgegraben werden könnte. Der Effekt wäre derselbe wie bei einer Zunahme der Goldgewinnung in einer Goldmine.

Anatole Kaletsky bezeichnete die Ausgabe von Geldgeschenken an die Bürger als “quantitative easing for the people”, ein Konzept, das 2014 auch von John Muellbauer unterstützt wurde.

Zur Bekämpfung der Finanzkrise ab 2007 sowie der darauffolgenden Eurokrise gingen viele Notenbanken zu einer stark expansiven Geldpolitik über. Als diese Maßnahmen nicht die gewünschte stimulierende Wirkung auf die Konjunktur zeigten, starteten verschiedene Notenbanken von reichen Ländern sogenannte Quantitative Lockerungs-Programme (oder QE, von englisch quantitative easing) und kauften im großen Stil private Anleihen und/oder Staatsanleihen auf. Da auch diese Maßnahmen noch nicht den gewünschten Wirtschaftsaufschwung brachten, führten mehrere Notenbanken Negativzinsen ein. Die Ausgabe von Helikoptergeld wäre eine weitergehende Maßnahme nach dem eingestandenen Scheitern aller bisher getroffenen Maßnahmen.

Eine Einführung von direktem Transfer von Zentralgeld wird am ehesten für Japan empfohlen und erwartet.

Rechtlicher Rahmen

Die Neue Zürcher Zeitung bezeichnete direkte Transferzahlungen von Zentralbankgeld in den meisten Ländern als illegal. „Wer die Idee deswegen aber als Hirngespinst abtut, unterschätzt die Biegsamkeit von Gesetzen und vergisst, dass vor zehn Jahren auch die Vorstellung negativer Zinsen bestenfalls als Scherz am Rand eines kalten Buffets taugte. Helikoptergeld, von der Financial Times bereits aktiv propagiert, dürfte manchem Geldpolitiker nicht mehr nur als surreales Gedankenexperiment erscheinen“. In der Zeit wurde dargestellt, dass die gegenwärtigen Regelungen der EU Helikoptergeld nicht zulassen. Es handele sich hier um die in Artikel 123,1 des EU-Vertrags von Lissabon verbotene monetäre Staatsfinanzierung. Sie ist verboten, weil sie zur Inflation beiträgt. Ein direkter Geldtransfer der Zentralbank an Bürger ist jedoch nicht explizit verboten. Experten wie etwa Jens Weidmann beurteilen dies jedoch als Kompetenzüberschreitung der Zentralbank, da diese keine Wirtschaftspolitik betreiben dürfe. Außerdem wäre nach Artikel 20 der EZB-Statuten eine Zwei-Drittel-Mehrheit im Rat notwendig.

Studie der Deutschen Bank

In einer Studie untersuchte ein Experten-Team der Deutschen Bank die Realisierbarkeit und die vermutlichen Effekte der Einführung des direkten Zentralgeldtransfers. Im geschichtlichen Teil der Studie wird aufgezeigt, dass die monetäre Staatsfinanzierung, also die Finanzierung von Staatsausgaben durch „Gelddrucken“, in der Geschichte ein häufiger Vorgang gewesen ist. Auch die dabei teilweise ausgelöste Inflation war vielfach die beabsichtigte oder eine in Kauf genommene Wirkung der Vergrößerung der Geldmenge. Ziele waren etwa die Reduktion von Schulden, der Nachweis der Zahlungsunfähigkeit angesichts von Reparationsforderungen (Weimarer Republik), die Finanzierung von Kriegskosten (1. und 2. Weltkrieg) und die Ankurbelung der Wirtschaft durch erhöhte Staatsausgaben (Japan 30er Jahre).

Die Ökonomen der Deutschen Bank halten das Konzept für ein wirksames Mittel bei Rezession und Deflation, wirksamer als die bisher eingesetzten Instrumente der Geldpolitik. Trotz der rechtlichen Schranken sehen sie Hintertüren für „Helikoptergeld“: Die EZB könne beispielsweise extrem langfristige Anleihen öffentlicher Kreditgeber wie der Europäischen Investitionsbank (EIB) zu einem Zins bei Null kaufen, um öffentliche Investitionen zu finanzieren. Zudem seien direkte Geldtransfers an Bürger und Unternehmen unter Umgehung des Staates möglich. „Ironischerweise“, so die Studie, „sei diese besonders unkonventionelle Variante des Helikoptergeldes rechtlich leichter durchzusetzen“.

Mediale Aufmerksamkeit

In den Medien tauchte der Begriff des Helikoptergeldes erstmals 2002 auf, nachdem der damalige Chef der US-Notenbank Fed, Ben Bernanke, in einer Ansprache Japan Helikoptergeld zur Bekämpfung seiner zähen Deflation empfohlen hatte.

In einer breiteren Öffentlichkeit wurde die Idee ab 2012 diskutiert, als deutlich wurde, dass die Wirtschaft stagnierte und die Konjunktur nicht in Gang gebracht werden konnte.

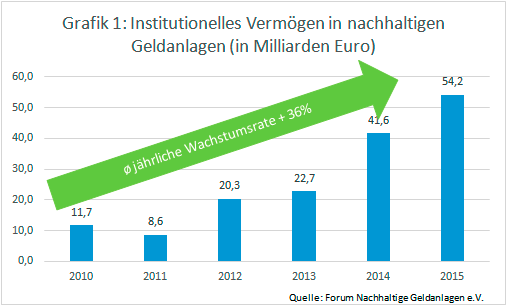

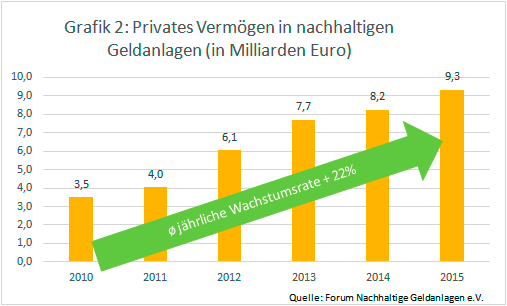

Über 1,5 Bio. Euro wurden durch Quantitative Easing in den Geldmarkt gepumpt, aber das neugeschaffene Geld wurde nur gespart, nicht ausgegeben. Das Geld sickerte nicht, wie beabsichtigt, in die Realwirtschaft ein, es gab weder mehr Konsum noch verstärkte Investitionen. Die Maßnahmen verpuffen bei den Banken und Finanzmärkten und schaffen eine Finanzblase. Die Welt stellt in einer Infografik dar, dass die Inflationsrate der Euro-Zone nahe bei O verharrt, obwohl sich die Bilanzsumme der Zentralbank extrem erhöht.

Im März 2015 unterschrieben 19 Hochschullehrer, darunter viele Ökonomen, einen Brief und veröffentlichten ihn in der Financial Times. Unter den Professoren waren Robert Skidelsky, David Graeber, Anne Pettifor, Richard A. Werner, Guy Standing, Joseph Huber, Helge Peukert, Steve Keen und Nigel Dodd. Die Fakten zeigten klar, schrieben sie, dass die bisherigen Maßnahmen des “quantitative easing” kein geeignetes Mittel für die Steigerung der Beschäftigung oder des BIP seien. Die Maßnahmen dienten nur den Wohlhabenden, die von Vermögenswerten profitierten. Die traditionelle Geldpolitik sei nicht länger wirksam. Neugeschaffenes Geld müsse direkt in die Wirtschaft „injiziert“ werden.

„Anstatt in die Finanzmärkte zu investieren, sollte das neue Zentralbankgeld besser für Regierungsausgaben (zum Beispiel für Investitionen in die Infrastruktur) verwendet werden; alternativ könnte man jedem EU-Bürger 19 Monate lang jeweils 175 Euro pro Monat überweisen, Geld, das man für Schuldentilgung oder Konsum einsetzen könnte. Durch die direkte Förderung von Ausgaben und Beschäftigung würde jeder dieser Wege mehr zum Erreichen der Ziele der EZB beitragen als das konventionelle QE.“

Während einer Pressekonferenz wurde Mario Draghi, Präsident der Europäischen Zentralbank EZF, im März 2016 auf Helikoptergeld angesprochen. Gemäß Draghi habe man im Zentralbankrat bisher nicht darüber nachgedacht oder gesprochen. Er sprach jedoch auch von einem „sehr interessanten Konzept“, das derzeit unter anderem unter akademischen Ökonomen diskutiert werde und auch „viele verschiedene Dinge“ bedeuten könne.

Seit März 2016 gab es nach Angaben der Welt 10 bis 30 Nachrichten täglich zu dem früher völlig unbeachteten Thema. In einer Grafik stellt die Welt den deutlichen Zusammenhang zwischen niedriger Inflationserwartung und Häufigkeit des Themas in den Medien von April 2015 bis April 2016 dar.

Formen des Transfers

Das durch Geldschöpfung erzeugte Zentralbankgeld kann den Bürgern direkt überwiesen werden. Eine andere Möglichkeit besteht darin, dass Regierungen mit dem erzeugten Geld die Steuern senken oder den Bürgern Steuern gutschreiben. Auch eine Reduktion von Krankenkassenprämien ist denkbar. Statt direkt an die Bürger können die Notenbanken das Geld auch an den jeweiligen Staat für den Haushalt überweisen. Dieser würde dann das Geld in Straßen oder andere Großprojekte investieren und so die Wirtschaft ankurbeln. Bei der Direktüberweisung an Bürger wäre das Problem zu lösen, wie man Informationen über 338 Millionen Bankkonten zentral erfasst und wie Bürger ohne Girokonto berücksichtigt werden können.

Der Guardian schlug vor, Maßnahmen gegen den Kilmawandel über zinslose Klima-Anleihen mit einer Laufzeit von 100 Jahren zu finanzieren. Die Zentralbank würde dem UN Green Climate Fund diese Anleihen abkaufen und ihm auf diese Weise praktisch nicht rückzahlbares Geld zur Verfügung stellen.

Beurteilung durch Ökonomen und Politiker

Ablehnung

Besonders in Deutschland sind viele Ökonomen und Politiker gegenüber Helikoptergeld skeptisch eingestellt. Helikoptergeld könne gefährliche politische Präzedenzfälle schaffen und die Illusion nähren, Notenbanken könnten für die Bürger und Regierungen einfach immer mehr Geld drucken und damit die Probleme lösen.

Strikt gegen die Ausgabe von Helikoptergeld ist Jens Weidmann, Präsident der Deutschen Bundesbank. Laut Weidmann ist Geldpolitik kein Allheilmittel, es ersetze nicht notwendige Reformen in einzelnen Ländern und löse auch nicht die Wachstumsprobleme Europas. Außerdem seien Geldgeschenke an die Bürger „eine hochpolitische Entscheidung“, die Regierungen und Parlamente fällen müssten. „Die Notenbanken haben dazu kein Mandat, auch weil damit eine massive Umverteilung verbunden wäre“, sagte Weidmann.

Die Ausgabe von Helikoptergeld birgt nach Darstellung der Kritiker große Gefahren. Die Bürger könnten sich daran gewöhnen, dass sie Geld nicht mehr durch Arbeit verdienen müssten. Bei einer nächsten Krise würden Wähler oder Politiker fordern, dass die Zentralbank erneut Helikoptergeld herausgibt. Die Menschen und Wirtschaft eines Landes würden stark verunsichert über die künftige Inflation mit womöglich dramatischen Folgen für Ersparnisse, Investitionen und Wachstumsaussichten. Das Vertrauen der Bürger in die Geldordnung und die Notenbanken ginge verloren.

Befürwortung

Es gibt jedoch auch maßgebliche Fürsprecher für das Konzept Helikoptergeld, so Adair Turner, ehemaliger Chef der britischen Finanzmarktaufsicht FSA und Lawrence Summers, ehemaliger US-Finanzminister unter Bill Clinton. Hauptgrund der Befürworter ist, dass die bisherigen Möglichkeiten der Geldpolitik ausgereizt seien, sodass als letztes Mittel der direkte Transfer übrig bleibe.

John Muellbauer begründete eine Ausweitung der Geldmenge durch Transferzahlungen an Bürger am 23. Dezember 2014 mit den Erfahrungen aus den Steuernachlässen der USA in den Jahren 2001 und 2008. Zwischen 20 und 40 % des Geldes wurde 2001 zum großen Teil in einem halben Jahr für kurzfristige Konsumgüter ausgegeben, 2008 dagegen ein Großteil für langlebige wie Autos. Die Besorgnis, dieses Geld würde nur gespart werden und nicht den Wirtschaftskreislauf in Gang bringen, habe sich nicht erfüllt. Der stimulierende Effekt auf die Wirtschaft sei besonders im zweiten Fall sehr deutlich ausgefallen. Den Effekt eines Transfers von 500 Euro pro Haushalt berechnet Muellbauer auf 1,1 % bis 2 % des BSP für Länder wie Spanien, Portugal und Griechenland. Wegen der hohen Sparquote in Deutschland würde hier nur ein Wachstum von 0,5 % ausgelöst. Eine solche Maßnahme der direkten finanziellen Förderung würde außerdem die Zustimmung der Bürger zu Europa vor allem in den wirtschaftlich angeschlagenen und sozial besonders stark getroffenen Ländern verstärken.

Die Geldschöpfung würde außerdem den Staatshaushalt nicht durch weitere Schuldenaufnahme belasten, wie dies bei kreditfinanzierten Konjunkturprogrammen der Fall war, die die Staatsverschuldung in unbezahlbare Höhen getrieben haben, da Tilgung und Zins über höhere Steuern oder Kürzungen des Haushalts bezahlt werden müssten.

Wirtschaftswissenschaftler weisen außerdem darauf hin, dass die Ausweitung der Geldmenge im Effekt durch Transferzahlungen oder durch Kauf von Anleihen gleich sei. Beim Transfer an die Bürger würde jedoch der Konsum direkt angekurbelt, während die Kapitalvergrößerung der Banken nur das Angebot von Krediten erhöhe. Diese Bankkredite stünden für Investitionen, aber kaum für Konsum zur Verfügung. Es fehle der jetzigen Wirtschaft aber nicht an der Ausweitung der Produktion durch Investitionen, sondern an der Ausweitung der Konsumnachfrage. Die Verbilligung von Krediten, die nicht abgerufen würden, schaffe letztlich nur eine Geldblase, während ein Transfer von zinslosem Geld an die Bürger den Konsum direkt ankurbeln würde.

Das Argument, diese Maßnahme würde das Vertrauen in die Währung erschüttern, weisen Befürworter zurück, da im Gegenteil das Erreichen des Inflationsziels gegenüber der gegenwärtigen Deflation und der Wirtschaftsstagnation erst wieder Vertrauen schaffe. Die Deflation drücke gerade den Vertrauensverlust aus.

Auch der Anreiz, durch Arbeit Geld zu verdienen, ginge nicht verloren, denn Arbeitslosigkeit sei nicht die Folge von Arbeitsscheu, sondern vom Mangel an Arbeitsplätzen.

Es sei auch nicht unethisch, Arme auf diese Weise zu unterstützen, weil die bisherige Währungspolitik eher die Reichen gefördert habe.

Prof. Marcel Fratzscher, Deutsches Institut für Wirtschaftsforschung, schließt Helikoptergeld in die Maßnahmen ein, die unter Umständen zu berücksichtigen seien, damit die Krise in Europa überwunden werden könne, hält sie aber für praktisch schwer umzusetzen.

Kritik auf der geldtheoretischen Ebene

Während Kritiker wie Otmar Issing die Debatte zum Helikoptergeld für „verheerend“ und eine „totale Geistesverwirrung“ halten, für eine „Bankrotterklärung der Geldpolitik“,äußert Thomas Mayer Zweifel am bisherigen Geldsystem. Ökonomen wie Mayer fordern die Überwindung des bisherigen theoretischen Rahmens der Geldpolitik und der Geldtheorie. Das Geldsystem sei in der bestehenden Form nicht mehr lebensfähig und schaffe nur neue Blasen auf den Finanzmärkten. Während bisher Geld nur als Schuldgeld aufgefasst worden sei, müsse Geld als „Reputationsgeld“ interpretiert werden. Helikoptergeld etwa werde nicht gegen eine neue Forderung produziert wie bisheriges Geld. Sein Wert hänge ganz allein davon ab, ob der Nutzer erwarte, das Geld gegen andere Dinge eintauschen zu können. Auch Gold sei in diesem Sinne Reputationsgeld. Diese Geldform diene nicht politischen Zwecken wie einer angestrebten Inflationsrate, sondern mache Geld – wie früher das Gold – gerade wieder zu einem aufgrund seiner Knappheit begehrten und geschätzten Aufbewahrungs- und Tauschmittel.

Textlizenz:

Dieser Artikel basiert auf dem Artikel Helikoptergeld aus der freien Enzyklopädie Wikipedia und steht unter der Lizenz Creative Commons CC-BY-SA 3.0 Unported (Kurzfassung (de)). In der Wikipedia ist eine Liste der Autoren verfügbar.

Lizenz Aufmacherbild:

In den „Conclusions“ werden auch einige Maßnahmen des lesenswerten „Amsterdam Call for Action on Open Science“ (

In den „Conclusions“ werden auch einige Maßnahmen des lesenswerten „Amsterdam Call for Action on Open Science“ (