Neue Maßstäbe im Versandprozess

Smarte Versandlösung bringt Wettbewerbsvorteil im Online-Handel

Die TREND-REPORT-Redaktion sprach mit Thomas Hagemann und Dr. Johannes Plehn über ihr innovatives Logistik-Geschäftsmodell im E-Commerce-Umfeld.

Herr Hagemann, welche Wettbewerbsvorteile erschließen Sie dem Onlinehandel, der hauptsächlich Marktpotenzial in Europa generiert?

Die Internationalisierung im Online-Handel kennt wenig Grenzen für den einzelnen Shop, dennoch gibt es aus Sicht des Händlers zahlreiche Dinge zu beachten.

Die Basis ist, stets eine auf das Zielland angepasste Shop-Seite anzubieten. Ferner müssen Marketingkanäle und -maßnahmen perfekt auf die Kunden im Ausland abgestimmt sein. Sind diese Hürden genommen, so gilt es die Herausforderung der cross-border Logistik anzugehen.

Im Unterschied zum stationären Handel wird die Logistik eines Online-Shops zumeist weiterhin aus dem Heimatland abgewickelt, denn eine dezentrale Lagerstruktur mit mehreren Lagerstandorten in Europa ist in der Regel nur für sehr große Händler wirtschaftlich.

„Wir heben alle Online-Händler mit unserer Plattform auf ein Level, welches sonst nur die großen oder eben die lokalen Konkurrenten im Zielland erreichen können“ erläutert Thomas Hagemann.

Diese Herausforderung, vor der die Händler stehen, haben wir erkannt und eine Lösung entwickelt, mit der man ohne großen Aufwand vieles besser und effizienter machen kann. Die deutschen Big Player wie z.B. Zalando oder Zooplus haben für sich teils andere, effizientere Logistikketten designt. Hier übergeben die Händler ihre Auslandssendungen nicht einem global agierenden Systemdienstleister, sondern sie betreiben eigenständig sogenannte „direct injection lines“. Das bedeutet, dass sie aus dem eigenen Lager direkt in die Hubs der lokalen Carrier im Zielland einliefern.

Für eine kosteneffiziente Abwicklung solcher Logistikketten benötigen die Händler allerdings täglich ein enorm großes Volumen in die einzelnen Länder. SEVEN SENDERS möchte Shops jeder Größe den Zugang zu den besten Carriern Europas bieten und dies ohne großen Aufwand und auf einem maximal schnellen und kostengünstigen Weg.

Die Basis für unsere Services bildet unsere technologische Plattform, welche die lokalen Carrier Europas zu einem virtuellen Carrier-Netzwerk verbindet und so allen Händlern zugänglich macht. So heben wir alle Online-Händler auf ein Level, welches sonst nur die großen oder eben die lokalen Konkurrenten im Zielland erreichen können.

Wenn ein Händler Schuhe oder Wein aus Deutschland heraus ins benachbarte Ausland verkauft, wo vielleicht ein ähnliches Angebot besteht, dann darf er nicht durch längere Versandzeiten oder -kosten negativ auffallen. Denn sonst kauft der Franzose oder Schweizer doch lieber bei einem lokalen Online-Shop, wenn dieser das Produkt zum gleichen Preis, aber eventuell schneller und günstiger liefern kann.

Wie lange dauert generell der Versand im europäischen Raum?

Je nach Standort des Händlers können wir bereits heute sogenannte „same-day-injection“ Lösungen anbieten. Das bedeutet, dass wir noch am Tag der Abholung im Hub des Carriers einliefern und die Ware am Folgetag in die Verteilung geht – der Kunde erhält das Paket bereits am nächsten Werktag.

Das Ziel europäischer Händler sollte stets eine Laufzeit von 2-3 Tagen ins Ausland sein. Wir können für den Großteil der deutschen Online-Shops bereits Laufzeiten von ein bis drei Tagen realisieren.

Wie schaffen Sie es einen Preisvorteil von bis zu 30 % für Auslandsversendungen für Ihre Kunden zu generieren?

Kleinere Shops können sehr wohl einen Preisvorteil von 20 – 30% erreichen. Wie in vielen Bereichen gilt aber auch hier, je größer der Shop bereits ist, desto geringer natürlich die prozentuale Kosteneinsparung, in absoluten Zahlen ergibt sich natürlich auch für diese Händler ein großer Hebel.

Unser Vorteil gegenüber global agierenden Dienstleistern liegt darin begründet, dass wir eben keine bestehenden Netzwerke und Routen haben, die wir auslasten müssen. Unsere Systeme bestimmen flexibel die optimale Route für die Sendungen des Versenders in das jeweilige Land.

Wir können auf die kundenseitigen Gegebenheiten wie Standort, Menge und gewünschte Laufzeit flexibel eingehen und arbeiten so, in einem sich täglich ändernden, aber auch sich selbst optimierenden Transportnetzwerk.

Wieviel Flexibilität haben Ihre Kunden bei der Auswahl der Paketdienstleister, die an dem Transportprozess ins europäische Ausland beteiligt sind?

Kosten und Geschwindigkeit sind tatsächlich nur zwei von mindestens drei offensichtlichen Vorteilen. Die Flexibilität, dem Shop die Wahl zu geben, welchen oder welche Carrier für den Versand genutzt werden sollen, darf man nicht unterschätzen.

Wenn Sie sich beispielsweise ein Paket eines ausländischen Shops hier nach Deutschland liefern lassen, haben Sie sicherlich auch Ihre ganz private Präferenz, ob es jetzt z.B. mit Hermes, DHL oder DPD geliefert werden soll.

Genauso ist das im Ausland. Ein Kunde in Frankreich möchte sein Paket vielleicht mit Colissimo, GLS oder Mondial Relay geliefert bekommen, da gibt es vor allem auch starke regionale Unterschiede in der Präferenz. Eine solche Flexibilität bietet Ihnen aktuell nur SEVEN SENDERS.

Die Komplexität bei der Anbindung an mehrere lokale Carrier im Ausland ist für viele Shops allein kaum zu bewältigen. Über unsere Plattform verbinden wir Shops systemseitig mit Carriern und managen die Logistikkette im Tagesgeschäft. Wir bieten einen Fächer von Carriern im jeweiligen Land an, der Händler aber hat die Wahl, welchen Carrier er nutzen möchte.

Herr Dr. Plehn, inwieweit wirkt sich Ihr Service positiv auf die Customer Journey aus?

Wie Herr Hagemann bereits betont hat, deckt unser Service sowohl das Management der physischen Logistikkette als auch die systemseitige Anbindung an die Carrier ab.

Schaut man sich das Themenfeld Paket-Tracking genauer an, so ist es interessant zu beobachten, dass Online-Shops viel Geld in die Kundengewinnung investieren, um diesen neugewonnenen Kunden nach dem Check-out gezielt auf die Fremdseite eines Logistikdienstleisters zu routen. Das aber ist fatal.

Als Versender möchte ich den Kunden in meinem Shop halten, so wie es die Big Player seit geraumer Zeit bereits umsetzen. Bei Zalando z.B. verfolgt man sein Paket in der Zalando-App und der Händler kann dies wiederum für up-selling Zwecke nutzen. Wie auch beim Paketversand möchten wir jeden Shop auf dieses Niveau heben, ihn befähigen seinen Kunden ein zeitgemäßes Paket-Tracking anzubieten – gegebenenfalls auch ohne Investitionen in eine eigene aufwändige Mobile-App.

Die Paketverfolgung ist letztlich nichts anderes als der Abschluss der Customer Journey – und welcher Händler möchte hier nicht positiv bei seinen Kunden punkten.

Die Realtime-Daten, die Sie über Ihre generelle Anbindung an die Carrier durch Ihre Software generieren, die geben Sie also weiter via Widget, welches ich auf meine Webseite einbinde und mit dem ich meinen Kunden den Service Paket- oder Sendungsverfolgung zur Verfügung stelle?

Thomas Hagemann: Ja. Das SEVEN SENDERS Tracking ist über alle europäischen Carrier hinweg standardisiert. Der Shop kann seinen Kunden entweder einen Link zum SEVEN SENDERS Tracking senden oder aber das Tracking in seine Shop-Seite integrieren, technisch ist dies mit wenig Aufwand durch ein Widget möglich.

So wird der Kunde über die gesamte „Customer Journey“ an den Shop gebunden, bis das Paket zugestellt wurde oder die Retoure zurück zum Shop gelangt ist. Und mehr noch: Unsere Software SEVEN SENDERS Analytics speichert die Carrier Daten und macht sie den Händlern zugänglich.

Diese Daten kann der Shop nutzen, um weitere Vorgänge auszulösen.

So können beispielsweise Regeln festgelegt werden, dass, wenn ein Paket in der Poststelle in Frankreich abgegeben wurde, eine SMS an den Endkunden gesendet wird. Durch die Software ergeben sich zahlreiche Möglichkeiten, um meine Kunden während der Customer Journey bis zum Empfang des Pakets immer wieder automatisiert kontaktieren zu können.

Erfahrungsgemäß führt eine proaktive Kundenkommunikation während des Versands zu weniger Kontaktpunkten im Kundenservice, wodurch der Händler Kosten einspart.

Herr Dr. Plehn, stehen Ihre ermittelten Echtzeitdaten im Kontext der Informationen über Lieferzeiten, Zustellquoten, usw. Ihren Kunden zwecks Datenanalyse zur Verfügung?

So ist es. Für den Logistikleiter im Unternehmen, der ständig alle Pakete im Blick haben muss, ist es eine immens wichtige Lösung.

Mit unserem Operations-Dashboard bieten wir eben eine solche Lösung, der Mitarbeiter loggt sich in die webbasierte Lösung ein, hat eine Übersicht zu allen Paket-Stati, erkennt sofort welche Pakete Probleme machen und welche nicht, kann also aktiv eingreifen, bevor der Kunde sich verärgert meldet.

Der Händler hat so die volle Kontrolle über die Pakete.

Alle Abläufe wurden für ein einmaliges Versanderlebnis optimiert. Was, wenn es trotzdem mal schiefgeht?

Natürlich kann immer mal etwas schief gehen, das sei vorangestellt. Man geht davon aus, dass je nach Lebenszyklus des Shops und dessen Prozessreife, zwischen zwei und fünf Prozent aller Pakete Probleme bereiten. Bei mehreren Millionen Paketen pro Jahr im Versand fordert bereits eine Fehlerquote von drei Prozent einen hohen Aufwand im Kundenservice.

Genau hier setzt unsere Software an, wir stellen Daten bereit, um Fehler zu erkennen bevor sie der Kunde erkennt. Ich möchte als Shop vermeiden, dass sich der Kunde

a) ärgert und nicht wieder bei mir kauft und

b) dass der Kunde einen Fehler bemerkt, bevor ich als Händler ihn bemerke.

Dadurch, dass wir dem Shop die Daten in Echtzeit bereitstellen, kann er proaktiv auf den Kunden zugehen und ihm die Situation erläutern, z.B. bei einem Paketverlust: „Wir versenden es erneut, Sie erhalten einen Gutschein für Ihren nächsten Einkauf.“

Wie definieren Sie Smart Service und Smart Citys im Kontext Ihrer Lösungen?

Johannes Plehn: Wenn wir über unsere heutigen Produkte hinaussehen und erläutern, was wir eigentlich tun im Kontext des Paketversands der Zukunft, dann muss man sagen:

Alles basiert auf der Grundlage von großen Datenmengen, auf deren Analyse und der richtigen Interpretation.

Thomas Hagemann: Die Analyse der Daten verläuft vollautomatisch. Auf Basis der Paketdaten, wie Größe, Gewicht und der Laufzeit, können unsere Systeme die Carrier auswählen. So generiert sich heute schon eine zum Teil selbststeuernde Paketzustellung.

Wenn ich weiß, wie schwer ein Paket ist, welche Abmaße es hat und welche Laufzeit zu welchen Kosten gewünscht ist, dann kann der Algorithmus selbständig entscheiden, welcher Carrier der richtige ist und entsprechend aussteuern.

Da gehen wir sicher in Richtung Smart Services, da sich Pakete auf Basis vorhandener Daten selbst den richtigen Weg suchen.

Richtung Smart City glauben wir, dass es gerade erst spannend wird in der Logistik.

Wenn man sich hier einmal anschaut, wie große Automobilhersteller und Händler im Bereich der Kofferraum-Zustellung zusammenarbeiten, dann wird sich auch hier für Online-Shops die Frage der Anbindung stellen.

So gibt es im Ausland, z.B. in Barcelona, einen sehr innovativen Partner, der die Kofferraum-Zustellung anbietet, aber der deutsche oder österreichische Shop hat auf dieses Angebot keinen Zugriff, weil er nicht vor Ort ist.

So verstehen wir uns als Enabler für diese intelligenten, Smart City Logistik-Lösungen auf der letzten Meile. Denn wir werden hier der Partner sein, der auf dem gesamten europäischen Raum Zugang zu diesen Lösungen schaffen kann und wir sind sehr erfreut, dass sich hier so viel tut. Sei es die Kofferraum-Zustellung, sei es innovative Paketboxen, etc., von denen eben auch kleine Händler profitieren können.

Wo steht SEVEN SENDERS in den nächsten zwei bis drei Jahren und welche Ziele verfolgen Sie?

Thomas Hagemann: Wir sind in den letzten ca. zwei bis drei Jahren, solange gibt es uns jetzt, sehr stark gewachsen. Mehr als 20 % im Durchschnitt pro Monat. Unser Ziel für die nächsten zwei bis drei Jahre ist ganz klar: Wir wollen die führende unabhängige Paketversand-Plattform in Europa sein und der führende Anbieter einer Operations-Software, die Logistiker vor allem im Bereich E-Commerce bevorzugt nutzen.

Wir haben zudem auch erste Kunden aus dem B2B-Bereich, mittelständische Unternehmen und Konzerne, die sich gleichermaßen für unsere Paket- und Softwarelösungen interessieren. Für das Thema Ersatzteil-Logistik beispielsweise kann unsere Lösung ebenfalls sehr spannend sein.

Johannes Plehn: Das ist es, was wir sein wollen, eine unabhängige Plattform für den Paketversand in Europa und der beste Anbieter für Logistiker-Software in diesem Bereich.

Maßgeblich für dieses Ziel ist, dass wir massiv in Technologie investieren, das ist für uns das A und O. Ein Drittel unserer Belegschaft arbeitet in der Entwicklung und wir treiben unsere Expansion in Europa weiter voran, wir gehen also deutlich stärker aus unseren deutschen Grenzen heraus und vertreiben unsere Produkte im Ausland.

Auf welche Technologien setzen Sie bei Ihrer Lösung heute und in Zukunft, Herr Dr. Plehn?

Wir investieren fortwährend in Technologie.

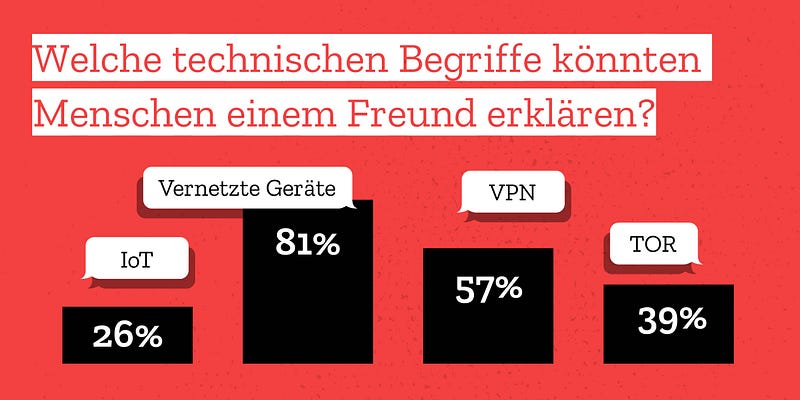

Zukünftig spannende Anwendungen erwarten wir für die Logistik u.a. in den Forschungsfeldern Internet der Dinge (IoT), rund um das Thema smarte Sensoren, aber auch das Thema Blockchain könnte einen großen Einfluss auf das Supply Chain Management haben.

So machen wir erste Tests mit smarten Sensoren zusammen mit ausgewählten Speditionspartnern. Wir statten dabei Paletten mit GPS-Tags aus, um die Echtzeit-Daten ins Tracking integrieren zu können. Ein Ziel könnte es sein, dem Endkunden zu zeigen wie sein Paket über die deutsche Autobahn Richtung Süden rollt, über die Grenze bis zu ihm nach Hause in Wien.

Das sind Möglichkeiten, die heute deutlich näher erscheinen als noch vor vier bis fünf Jahren. Wenn solche Themen durch ein junges Unternehmen wie SEVEN SENDERS verfolgt werden, können Sie davon ausgehen, dass diese nicht länger Theorie bleiben, sondern zeitnah relevant für die Praxis sein werden.

Innovative Lösungen für die Logistik zu entwickeln sind unser Antrieb.

Vielen Dank für das Gespräch!

weiterführende Informationen unter:

SEVEN SENDERS

Unsere Interviewpartner

Thomas Hagemann

Vor der Gründung von SEVEN SENDERS war Dipl.-Wirt.-Ing. Thomas Hagemann in der Berliner Logistikberatung 4flow AG schwerpunktmäßig in internationalen Projekten in den Bereichen Automotive und erneuerbare Energien tätig. Als Research Scientist am Fraunhofer-Institut für Materialfluss und Logistik IML leitete er Projekte im Forschungsfeld Internet der Dinge (IoT).

Dr. Johannes Plehn

Als COO des Project-A Onlineshops Wine in Black lag sein Fokus auf der Optimierung von Einkaufs-, Payment-, Fulfillment-Prozessen und Customer Service, sowie der Erarbeitung eines ganzheitlichen Order Management Systems. Während seiner Doktorarbeit an der ETH Zürich, entwickelte er ein Framework zur Optimierung der Eco-Efficiency von produzierenden Unternehmen, analysierte die Auswirkungen von bestehenden Freihandelsabkommen auf globale Supply Chains und erarbeitete eine Operationsstrategie für einen OEM aus der Transportindustrie.

Über Seven Senders

Die Seven Senders GmbH mit Sitz in Berlin wurde Anfang 2015 von Dr. Johannes Plehn und Thomas Hagemann gegründet. Als Full-Service-Dienstleister ist das Unternehmen auf den Versand von Online-Shops spezialisiert. Seven Senders ermöglicht es Händlern, ihre Kunden günstiger, schneller und mit innovativen Zusatzleistungen zu beliefern. Das Unternehmen optimiert die Materialflüsse und verbindet IT-Schnittstellen der Shops mit denen der KEP-Dienstleister im Ausland. Eine Software-Lösung ermöglicht die durchgängige Kontrolle der Lieferkette. Das Track & Trace-System stellt die lückenlose Sendungsverfolgung von Abholung bis Zustellung sicher. Weitere Informationen unter: www.sevensenders.com