Eine digitale europäische Souveränität funktioniert nur mit Open Source

/in Digitalisierung, Open Source, Sicherheit, Unternehmen & Märkte/von Bernhard Haselbauer„Wer als Arbeitgeber im Wettbewerb um die besten Talente attraktiv bleiben will, muss handeln“

/in Allgemein, Freie Inhalte, Gesundheit, Nachhaltigkeit, Studien, Unternehmen & Märkte/von Daniela HaselbauerRenato Salvatore, CEO Corporate Services bei Sodexo Deutschland, ist überzeugt: Arbeitsplätze sind mehr als Räume, in denen Menschen arbeiten. Arbeitsplätze sind Orte, an denen man sich begegnet, austauscht und gemeinsam Fortschritte macht. In den letzten drei Jahren hat sich die Arbeitswelt durch die Corona-Pandemie grundlegend verändert. Damit haben sich auch neue Anforderungen und Bedürfnisse von Arbeitnehmenden ergeben. Vor diesem Hintergrund hat Sodexo gemeinsam mit dem Meinungsforschungsinstitut YouGov Deutschland eine Online-Befragung durchgeführt. Die Besonderheit: Unter den 1.000 Umfrage-Teilnehmenden befanden sich sowohl Produktionsangestellte („Blue Collar Worker“) als auch Büroangestellte („White Collar Worker“). Die Ergebnisse der Studie geben Auskunft darüber, welche Erwartungen und Wünsche Beschäftigte in Unternehmen an die Arbeitswelt und die damit verbundene Infrastruktur haben.

Die Pandemie war für die Arbeitswelt ein Wendepunkt. Drei Jahre später sind Covid-Restriktionen aufgehoben und Arbeitgeber stehen vor der Frage: Was erwarten Angestellte in Büro und Produktion heute? Und was bedeuten die veränderten Anforderungen der Mitarbeitenden für die Facility Management- und Reinigungsbranche sowie für HR-Verantwortliche? Wir als Dienstleister sind davon überzeugt, dass wir die Entwicklungen in der Arbeitswelt aktiv mitgestalten können. Dabei geht es nicht nur um Antworten rund um die Gestaltung des Arbeitstages im Büro oder Homeoffice, sondern um alle geforderten Angebote und Services im Gebäude. Denn Menschen erwarten, wo sie sich aufhalten, ein einfaches, durchdachtes Kundenerlebnis. Hinzukommt: Die Industrie 4.0 beschleunigt den Anpassungsbedarf in der Standortinfrastruktur, alle Unternehmen sind gefordert, in ihren Einrichtungen nachhaltig zu wirtschaften, überall tobt ein Wettbewerb um die besten Talente und der Wunsch nach Sicherheit, Gesundheit und Lebensqualität ist omnipräsent. Kurz gesagt: Es besteht Handlungsbedarf! Die Ergebnisse der Studie geben genau zur richtigen Zeit Auskunft darüber, welche Erwartungen und Wünsche Beschäftigte in Unternehmen an die Arbeitswelt und die damit verbundene Infrastruktur haben.

Veränderte Bedürfnisse bestimmen den Arbeitsalltag von heute und morgen

In den Ergebnissen der Studie wird zunächst deutlich, dass das Gebäude als Arbeitsort bei weitem nicht ausgedient hat. Allerdings ist der Wunsch nach modern ausgestatteten, flexiblen Arbeitsflächen und -modellen hoch. So besteht bei den White-Collar-Beschäftigten auch nach der Corona-Pandemie der Wunsch nach hybridem Arbeiten (44 %) und für ein Fünftel ist eine flexible Einteilung von Homeoffice- und Office-Tagen erwünscht – auch auf Seiten der Vorgesetzten. Dabei bieten beide Arbeitswelten ihre Vorteile: ungestörtes Arbeiten im Homeoffice (69 % vs. 5 % am Arbeitsplatz) oder der persönliche Austausch während Office-Tagen (64 % vs. 9 % im Homeoffice). Bei all der Flexibilität sind feste Arbeitsplätze (68 %) jedoch weiterhin die bevorzugte Wahl gegenüber Flex Desks – auch für diejenigen, die unregelmäßig vor Ort sind. Auf Workplace Design bzw. die Organisation und Gestaltung von Bürogebäuden legen 58 Prozent aller Büromitarbeitenden wert, während 74 Prozent der befragten Führungskräfte im „Kampf um die besten Talente“ vor allem besondere Angebote wie Betriebsrestaurants, Rückzugsräume und Co-Working-Spaces nennen. Zutreffend ist laut Umfrage auch die Annahme, dass die Work-Life-Balance noch immer an Bedeutung gewinnt. In Bezug auf die Gestaltung der Pausenräume wünscht sich die Mehrheit unserer Befragten (77 %) eine Tee- und Kaffeeküche, gefolgt von einer Kantine (48 %). Insbesondere Produktionsangestellte fordern außerdem Automaten für Snacks und Getränke (56 %). Ein voll ausgestaltetes Café spielt wiederum nur für 28 Prozent aller Befragten eine Rolle. Beim Essensangebot ist der Wunsch nach einem gesunden Speiseplan (75 %) und einer frischen Zubereitung (80 %) hoch: 42 Prozent der Befragten finden eine vegane oder vegetarische Essensauswahl wichtig, 40 Prozent aller Mitarbeitenden legen Wert auf Bio-Angebote in der Kantine und 55 Prozent darauf, dass Zutaten aus der Region kommen.

Anforderungen im Subgruppenvergleich: Büro-Angestellte vs. gewerbliche Arbeitende

Mit Blick auf mögliche Unterschiede zwischen den Anspruchsgruppen zeigt sich, dass diese zunächst gar nicht so groß sind: Bei der Wahl des Arbeitgebers zählen neben dem Gehalt (Blue Collar 94 % vs. White Collar 95 %) sowie der Anzahl der Urlaubstage (92 % vs. 90 %) auch ein gutes Verhältnis mit Vorgesetzten (87 % vs. 89 %) oder der Ausblick auf ein ausgewogenes Verhältnis von Arbeits- und Privatleben (83 % vs. 87 %) zu den wichtigsten Aspekten. Auch beim Wunsch nach einer Tee- bzw. Kaffeeküche (71 % vs. 79 %) herrscht ein Konsens. Als IFM-Experte ist es für Sodexo jedoch entscheidend, wo sich Erwartungen, Positionen und Wünsche zu bestimmten Thematiken zwischen den beiden Gruppen unterscheiden. Einige davon überraschen nicht und gehen deutlicher auseinander: Während sich White Collar-Beschäftigte von ihrem Unternehmen viel stärker mobiles Arbeiten (50 % vs. Blue Collar 10 %) und Kostenerstattungen für Fahrtwege (40 % vs. Blue Collar 31 %) wünschen, setzen Blue Collar-Beschäftigte eher auf Prämien (66 % vs. White Collar 53 %). Auch die Priorität in Bezug auf Büroreinigung (White Collar 79 % vs. Blue Collar 59 %) oder technische Unterstützung (White Collar 74 % vs. Blue Collar 62 %) am Arbeitsplatz variiert. Das Angebot eines Betriebsrestaurants (55 % vs. White Collar 46 %) und insbesondere von Snackautomaten (56 % vs. White Collar 36 %) spielt für die Gruppe der Produktionsangestellten eine größere Rolle.

Was wollen und brauchen Arbeitnehmende?

Für uns als Dienstleister, aber auch als Unternehmen steht fest: Wer als Arbeitgeber im Wettbewerb um die besten Talente attraktiv bleiben will, muss handeln und sich konsequenter als je zuvor an den Anforderungen seiner Mitarbeitenden ausrichten. Wo fangen Arbeitgeber an, um den Ansprüchen ihrer Mitarbeitenden gerecht zu werden? Sodexo empfiehlt an dieser Stelle im ersten Schritt immer eine eingehende Analyse der jeweiligen Ausgangslage. Es geht nicht darum, unüberlegt Wände einzureißen oder Räume unbedacht umzugestalten. Zuerst sollte sich immer die Frage gestellt werden: Was wollen und brauchen die eigenen Arbeitnehmenden im Besonderen? Die „Employee Journey“ ist bei jedem Unternehmen anders. Daraus gilt es, Services abzuleiten, die im Gebäude vorhanden sein müssen. Welche Co-Working-Spaces und Kreativflächen Unternehmen brauchen und wie diese auszusehen haben, folgt dann im zweiten Schritt. Mit unserem neuen Ansatz ‚Vital Spaces‘ ist Sodexo in diesem Prozess zunehmend Berater. Durch unsere Services direkt vor Ort beim Kunden tragen wir schon seit Jahrzehnten dazu bei, Räume zu Orten der Begegnung zu machen. Die Gestaltung eines modernen Betriebsrestaurants, die Einführung digitaler Steuerungsprozesse und die Entwicklung kreativer Büros sind die Basis für zeitgemäße Einrichtungen. Dabei kommt es auf Flächen an, auf denen man ankommt, konzentriert arbeitet, sich austauscht, sich vernetzt und gerne verweilt. Denn das Gebäude ist ein Aushängeschild – die Menschen, die es betreten, sind Botschafter. Und sie haben Vorstellungen von guter Ausstattung, Design und Services.

Als einer der wenigen Marktteilnehmer bieten wir die volle Bandbreite an Gebäudedienstleistungen aus einer Hand: Foodservice, Soft- und Hard-FM. Neben diesen traditionellen Feldern entwickeln wir uns zu strategischen Beratern rundum Workplace Strategie und Design. Wir sind fest davon überzeugt, dass Foodservice und technische Gebäudeausstattung eng miteinander verzahnt sind und hervorragend zusammenpassen.

Gesunde Pausen – viele der Befragten legen Wert auf ein Essensangebot und Getränke im Pausenraum oder Kantine. Dabei gilt es zudem immer häufiger, eine Auswahl an Bio-Lebensmitteln sowie vegetarische und vegane Optionen anzubieten. © Kelvin Cuff for ID21

Über den Autor:

Renato Salvatore wurde im November 2021 zum CEO der Corporate Services Deutschland, dem größten Geschäftssegment von Sodexo Deutschland, ernannt. Zudem ist er seit 2011 CEO der Sodexo Technologietochter GA-tec und Mitglied der GA-tec Geschäftsleitung. Unter seiner Führung wird die Kompetenz Soft-, Hard- und Food-Services aus einer Hand zu bieten, weiter ausgebaut. Salvatore ist mit insgesamt über drei Jahrzehnten Anstellung bei GA-tec und Sodexo erfahrener Branchen- und Soft-FM-Experte mit fundierten Kenntnissen von Markttrends und Marktbedürfnissen.

Über SODEXO Deutschland:

Sodexo wurde 1966 von Pierre Bellon in Marseille gegründet, ist in in 53 Ländern tätig und weltweit führend im Bereich Quality of Life Services, einem wesentlichen Faktor für individuelle und organisatorische Leistung. Die 8.500 Mitarbeitenden in Deutschland unterstützen Kunden aus verschiedensten Branchen, Industrien und Institutionen direkt vor Ort in deren Betrieben und Einrichtungen – darunter Pharma, Konsumgüter, Professional Services, Technologie und Gesundheitswesen. Sodexo ist bundesweit an über 550 Standorten tätig. Mit einer einzigartigen Kombination von Dienstleistungen für Unternehmen, Behörden, Kliniken, Senioreneinrichtungen und Verbraucher:innen erreicht Sodexo Deutschland täglich mehr als eine Million Menschen. Zu unseren Leistungen zählen Technische FM-Services, Infrastrukturelle FM-Services, Food Services sowie Benefit & Reward Services. Bei Sodexo Onsite Services umfasst unser Leistungsspektrum Reinigung, Catering, Cafeterien-Betrieb, Logistik, Sicherheits- und Empfangsdienste, Konferenzservices sowie Technisches Gebäudemanagement. Zur Sodexo-Familie auf dem deutschen Markt gehört auch die hundertprozentige Tochtergesellschaft GA-tec, ein führender Experte für technische Gebäudeausrüstung und technisches Facility Management. Bei all unserem Denken und Handeln stellen wir stets unsere Kund:innen in den Mittelpunkt und verstehen uns als „B2B4C“-Dienstleister, der den Alltag von Menschen bei der Begegnung und hinter den Kulissen ein bisschen besser macht: „to create a better everyday for everyone to build a better life for all.”

Industrielle KI – Im Tal der Tränen?

/in Creative Commons CC BY-ND, Digitalisierung, Freie Inhalte, Künstliche Intelligenz, Unternehmen & Märkte/von Daniela HaselbauerAutor: Dr.-techn. DI Andreas Schumacher

Autorenvorwort: Der Reiz Teile dieses Textes mit einem KI-Textgenerierungstool zu verfassen oder zumindest zu konzeptionieren, lag unbestreitbar auf der Hand, diesem Reiz wurde widerstanden. In naher Zukunft werden Texte dieser Art wohl die Minderheit darstellen.

Künstliche Intelligenz als (Industrielle) Revolution?

Bereits das Wort „künstliche Intelligenz“ (KI) löst aktuell, auch im industriellen Kontext, den Anschein einer Revolution aus, welche mit dem Ausruf der „Industrie 4.0“ bereits im Jahr 2011 erwartet wurde. Künstliche Intelligenz etwa definiert als „[…] the ability of a digital computer or computer-controlled robot to perform tasks commonly associated with intelligent beings” (vgl. Britannica) ist konzeptionell seit der ersten Revolution und Automatisierungswelle im 18. Jhdt. bekannt. Während jedoch vormalige technologische Revolutionen, wie jene der Automatisierung, die Ersetzbarkeit manueller und kognitiver Routinearbeiten aufzeigten, rüttelt die Künstliche Intelligenz nun erstmals an den noch verbleibenden Nicht-Routine-Arbeiten wie Kreativtätigkeiten, welche als unantastbar menschliche gelten. Sogar Charakteristiken wie Empathie oder Leidenschaft werden neuerdings bereits von Algorithmen ununterscheidbar abgebildet. So bewerteten Empfänger:innen von medizinischen Online-Ratschlägen die Konversationen mit einem KI-Tool als empathischer als jene mit menschlichen Mediziner:innen. Dies zeigt, dass philosophische und ethische Aspekte von KI intensiv zu diskutieren sind, etwa ob KI-generierte Inhalte als solche gekennzeichnet werden müssen. Die Chancen stehen jedenfalls gut, dass wir die Lawine an KI-Lösungen ex-post als Start einer industriellen Revolution bezeichnen werden, wie wir uns diese vom Ausruf der Industrie 4.0 erwartet hätten.

Ist die Industrielle KI im Tal der Tränen?

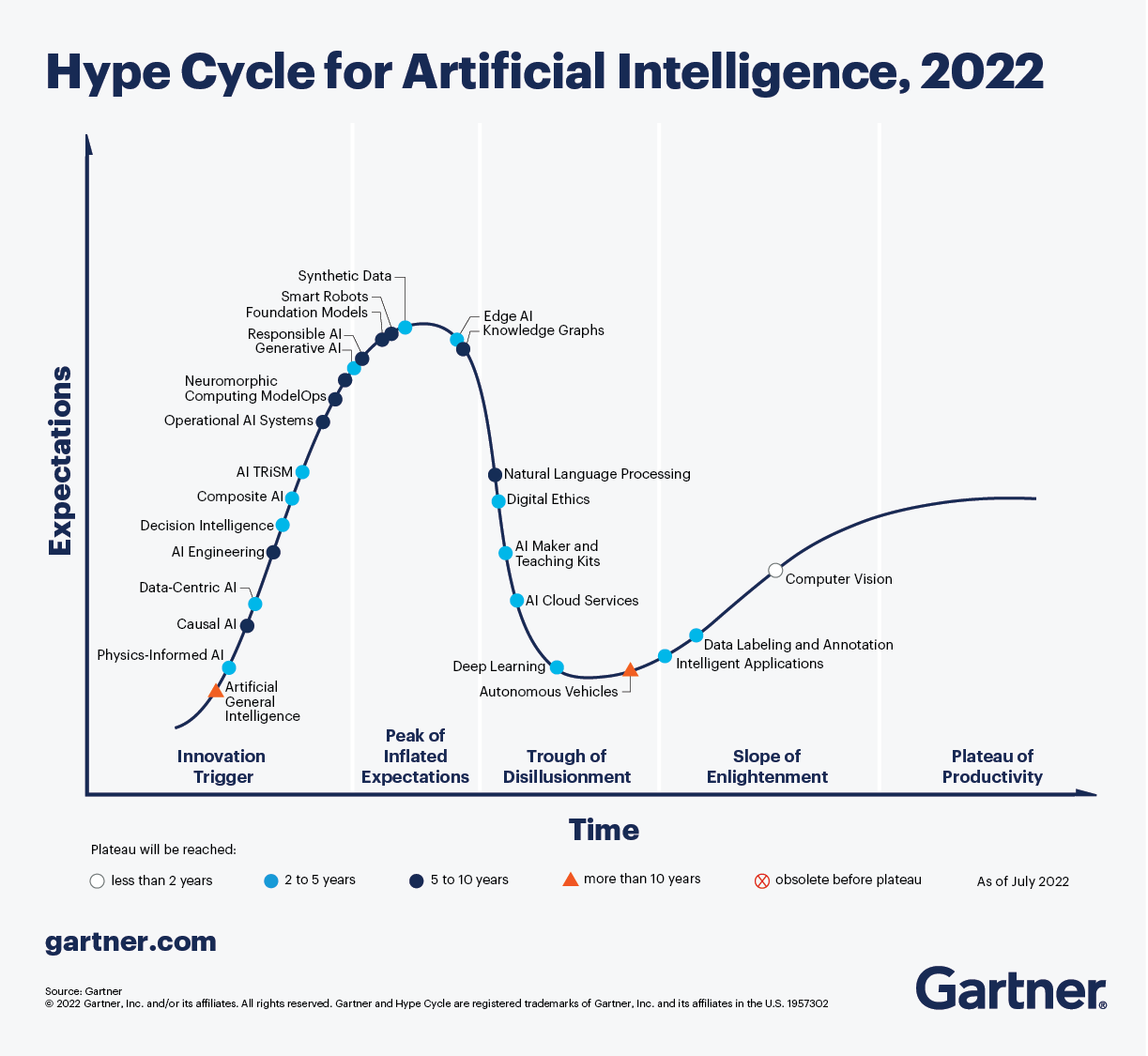

Der bekannte Gartner Hype Cycle prophezeit für jede Technologie eine Phase überzogener Erwartungen, bevor diese nach einer Bereinigung der Erwartungen (Tal der Tränen) die Phase der produktiven Anwendungen startet und Technologien Einzug in den Mainstream finden.

Im relativ wenig reglementierten Consumer-Bereich durchlaufen Technologien diesen Zyklus schneller als im Industriebereich, wobei digitale und vor allem datenfokussierte Technologien hier die kürzesten Durchlaufzeiten aufweisen. Im Bereich Künstlicher Intelligenz hat die Technologie der sog. „Large Language Models“, in Produktform intelligenter Chatbots auf frei zugänglichen Webseiten, zu einer rekordverdächtigen Technologieadaption im Consumer-Bereich geführt. So wurde die Technologieverbreitung des aktuell dominierenden KI-Chatbots ChatGPT (Chatbot Generative Pre-trained Transformer) zur Erfolgreichsten bis dato, mit 100 Mio. Nutzer:innen in den ersten 2 Monaten. Diese rasante Entwicklung der KI-Technologien im Consumer-Bereich führen zu einer effizienten Bereinigungsphase im Hype Cycle, und es werden Lösungen mit hohem gesellschaftlichem Beitrag, wie Medizin-KI-Chatbots für Personen ohne Zugang zu medizinischen Ressourcen, absehbar.

Im industriellen Umfeld ist vom Hype der aktuellen KI-Tools noch weniger zu vernehmen, und hier durchlaufen KI-Technologien den Hype Cycle mit dem gewohnten „Industrial Pace“, also der vergleichsweise langsameren industriellen Technologieadaption. Hierfür gibt es gute Gründe:

- Anwendungsfokus: Aktuelle „Out-of-the-box“-KI-Tools fokussieren auf Inhalte, welche im Zusammenhang mit Text, Sprache, Bildern oder Videos stehen – also Inhalte des täglichen Lebens. Getrieben ist dieser Fokus vor allem durch die öffentlich zugänglichen Trainingsdaten, welche für die Entwicklung der Lösungen zur Verfügung stehen. Für spezielle industrielle KI-Tools, wie Planungs-KIs für Anlagenplanungen oder Projektmanagement-KIs zur Abwicklung komplexer Bauprojekte, stehen keine ausreichenden Trainingsdaten dieser Qualität zur Verfügung.

- Anforderungstiefe: Industrielle KI-Anwendungen, etwa zu Verbesserung der Energieflusssteuerung in Fabriken, erfordern zum Training von KI-Lösungen individuelle Daten der zu optimierenden Energiekreisläufe. Daten dieser Detailtiefe einzelner industrieller Prozesse sind nicht öffentlich verfügbar, und so können KI-Tools, welche nur mit öffentlich zugänglichen Daten des Internets trainiert werden, hier keine Ergebnisse in ausreichender Qualität liefern.

- Wissenstiefe: Aktuell betreiben gut ausgebildete Fachkräfte industrielle Anlagen und Prozesse. Hier wirkt ein komplexes Zusammenspiel aus Erfahrung, Intuition und Interaktion mit anderen. Dieses Zusammenspiel können aktuelle KI-Lösungen nicht ausreichend gut abbilden. So sind etwa langjährig tätige Instandhaltungsmitarbeiter:innen in der Lage, Ausfälle von Maschinen verblüffend genau abzuschätzen, ohne dafür stets eine rationale Erklärung zu haben. Hier ist aktuell noch ein unverhältnismäßig hoher Aufwand zur Entwicklung von KI-Lösungen erforderlich, um diese Wissenstiefe und letztendlich Effektivität abzubilden.

- Sicherheitsanforderungen: Industrielle Anlagen stellen unweigerlich einen Gefahrenbereich für Menschen dar, in welchem alle Ursachen und deren Auswirkungen bestmöglich kontrolliert werden müssen. Unternehmen als auch Behörden sind noch nicht bereit, sicherheitsrelevante Entscheidungen an KI-Lösungen auszulagern, da deren Ursache-Wirkungsketten oft nicht validierbar und im Schadensfall rekonstruierbar sind.

- Daten- und IP-Sicherheit: KI-Lösungen nutzen eingegebene Daten sowie erzeugte Ergebnisse, um das Kernmodell weiter zu trainieren und um zukünftige Ausgaben zu verbessern. Industrieunternehmen hantieren mit meist vertraglich geschützten Daten innerhalb des Unternehmens, auch entlang der umliegenden Wertschöpfungskette. Aktuell ist die rechtliche Abbildung dieser Datenströme schlicht noch zu wenig ausjudiziert und stellt damit für Industrieunternehmen ein nicht kontrollierbares Risiko dar.

Zusammenfassend lassen sich also KI-Technologien des Consumer-Bereiches nicht ohne Weiteres auf den industriellen Kontext umlegen, da Industrieunternehmen speziellere Tätigkeiten durchführen und strengere Anforderungen an Technologien setzen müssen.

Die Hypothese, dass sich KI im industriellen Kontext im Tal der Tränen befindet, kann jedoch aufgrund etwa eines simplen Vergleiches mit dem Consumer-Bereich nicht gestützt werden. So gibt es seit Jahrzehnten KI-Lösungen im Produktivbereich industrieller Unternehmen, welche die Anforderungen der Industrie erfüllen: etwa die Steuerung von fahrerlosen Transportsystemen in Logistikhallen über Schwarmintelligenz, die kamerabasierte Inspektion von Elektronikbauteilen über Visual Computing oder die Optimierung der Reihenfolgeplanung in Produktionsanlagen über Machine Learning. Im Unterschied zum Consumer-Bereich durchliefen diese Lösungen den Hype Cycle jedoch langsamer und kontrollierter, was im Vergleich zu aktuellen KI-Entwicklungen den Anschein einer Schockstarre oder sogar Verweigerung erwecken mag. Dies ist jedoch schlicht auf die erforderliche größere Risikoaversion industrieller Unternehmen zurückzuführen und stellt sicher, dass KI-Lösungen kaufmännisch, technisch und sicherheitstechnisch verträglich sind.

Industrielle KI – was kommt nun?

Selbst führende Vertreter:innen der KI-Szene sind sich einig, dass aktuelle Entwicklungen rund um Large Language Models keine wirkliche KI-Revolution aus technologischer Sicht darstellen. Die eigentliche Revolution findet in den Köpfen aller Menschen statt, da sich nun ein umfassender Diskurs über das Zusammenspiel zwischen Mensch und Maschine entwickelt, wie man diesen schon seit Jahrzehnten führen hätte sollen. Technologisch wird ein Schneeballeffekt erwartet, da die Vielzahl neuer Lösungen im Zusammenspiel mächtige KI-Lösungen ermöglicht, oder deren Funktionen zumindest die Entwicklungen neuartiger KI-Tools beschleunigt.

Es ist daher Industrieunternehmen geraten, sich aktiv mit KI-Tools zu beschäftigen und diese operativ im Unternehmen zu verankern. Denn genau in der täglichen Arbeit kommen die beiden Hype Cycles, jener des Consumer-Bereiches und jener des Industriebereiches, zusammen. Mitarbeiter:innen lernen aktuell viele neue KI-Tools im privaten Bereich kennen und nutzen diese aktiv, was eine große Chance auch für Industrieunternehmen bietet, diesen Schwung für die Arbeit im Unternehmen zu übernehmen. Ob aktiv im Unternehmen getrieben oder nur verfolgt – eine Vielzahl an Tätigkeiten wird, über ein Zusammenspiel aus Automatisierung und KI über die nächsten Jahre, von Maschinen teilweise ersetzt oder umfassend unterstützt. So werden KI-Copilot:innen und KI-Assistenzen in Office-Software-Tools bereits angekündigt, und spätestens dann werden sich alle Jobprofile verändern.

Eine maßgebliche Barriere zur aktiven Einführung von KI-Lösungen stellt die Angst vor Jobverlusten dar. Aber, legt man den zeitlichen Verlauf der Arbeitslosigkeit mit technologischen Veränderungen übereinander zeigt sich, dass die Arbeitslosigkeit des letzten Jahrhunderts in keiner negativen Korrelation mit technologischem Fortschritt steht. Mit Zukunftsaussagen zu Jobverlusten durch Automatisierung und KI sind bereits renommierte Universitäten und Forscher:innen gescheitert. Denn oftmals wird die Veränderungen von Jobprofilen mit dem Wegfall von Jobs gleichgesetzt. Da diese Entwicklungen jedoch gerade im industriellen Bereich verlangsamt Einzug halten, haben Mitarbeiter:innen Zeit, sich an das eigene veränderte Jobprofil anzupassen oder es sogar mitzuformen. Dass etwa Backoffice-Mitarbeiter:innen in wenigen Jahren keine langwierigen Terminkoordinationen mehr durchführen müssen, ist naheliegend. Dieser wegfallende Anteil des Jobprofiles kann zum Beispiel durch Tätigkeiten zur persönlicheren Betreuung neuer Mitarbeiter:innen beim Onboarding aufgefüllt werden – eine Veränderung des Jobprofiles mit hohem Mehrwert für das Unternehmen, ohne Jobverlust.

Als Industrieunternehmen sollte man seinen individuellen KI-Hype Cycle durchlaufen, um sinnvolle Lösungen zu identifizieren und einzuführen. Von einer pauschalen Verurteilung der KI-Technologien, aus welchen Gründen auch immer, sei dringend abgeraten, da die Gefahr besteht, die wirklich nützlichen Tools zu übersehen.

Über den Autor:

Andreas Schumacher arbeitet seit Januar 2022 bei VTU und ist in unserem Unternehmen der Experte für Digitalisierungsstrategien und deren Umsetzung.

Andreas Schumacher verfügt über mehr als 10 Jahre Erfahrung in den Bereichen Unternehmensberatung, Forschung und Innovation. Als CDO bei VTU entwickelt er eine Digitalisierungsstrategie auf Konzernebene und setzt digitale Lösungen auf allen Ebenen um. In der Digitalisierung der Wertschöpfung, das Feld in dem Schuhmacher auch promovierte, liegt seine Expertise und ist die Grundlage seiner Arbeit. Er publiziert seit mehreren Jahren wissenschaftlich im Bereich Industrie 4.0 und berät Unternehmen bei der Umsetzung von industriellen Digitalisierungsstrategien. Seine Arbeit bei VTU umfasst die Bereiche Internal Digital Work, Digital Project Execution und Customer Digitalization. Andreas treibt die Digitalisierung durch die Integration von Operational und Digital Excellence voran und konzentriert sich auf Competence Center Ansätze, um digitale Agenden nachhaltig in die VTU Organisation einzubetten.

Andreas Schumacher bringt die Digitalisierung aus einer menschenzentrierten Perspektive voran, in der Aspekte wie individuelle Arbeitsstile, unterschiedliche Kompetenzniveaus und die Integration in tägliche Routinen eine zentrale Rolle spielen.

Dr. Andreas Schumacher

Chief Digital Officer

VTU Group

Der Beitrag ist freigegeben unter CC BY-ND

Forschung und Innovationen sind die Triebfedern einer zukunftsfähigen IT

/in Digitalisierung, Expertenpanel, Globalisierung, Künstliche Intelligenz, Specials, Unternehmen & Märkte, Wissenskultur/von trendreportVon Dr. Angela Carell und Thomas Bendig

In kaum einer Branche spielen Forschung und Innovation eine so herausragende Rolle wie in der Informationstechnologie. Ob das Internet, das Smartphone oder Künstliche Intelligenz (KI) – allein diese Innovationen haben das Leben der Menschen auf vielfältige Weise verändert und erleichtert. Sie wären ohne ständige Forschung und Innovationen als Triebfedern für Fortschritt nicht möglich gewesen. Neue technologische Entwicklungen haben das Potenzial, eine rasante Dynamik zu entfalten und damit unsere Welt, in der wir leben, auf den Kopf zu stellen. So war es mit der Erfindung der Dampfmaschine, so ist es mit KI und ganz aktuell mit ChatGPT. Das hat einen enormen Einfluss auf viele Bereiche des täglichen Lebens, wie beispielsweise die Kommunikation, die Unterhaltung, die Bildung, die Geschäftswelt und die Gesundheitsversorgung. Doch erst wenn aus den Forschungsergebnissen Lösungen werden, die auf ein Interesse des Marktes oder der Gesellschaft stoßen, wird daraus eine Innovation. Forschung und Innovation sind deshalb eng miteinander verflochten, aber nicht identisch: Nicht aus jeder Forschung wird eine Innovation. Forschung und Innovation erfordern denn auch unterschiedliche Herangehensweisen, Mindsets und Methoden. Dabei hat sich die Arbeitsweise zweier Teams, die sich jeweils mit einer der beiden Perspektiven intensiv auseinandersetzen und gleichzeitig im ständigen Austausch miteinander stehen bewährt. Gemeinsam werden so neue Ansatzpunkte für Forschung und Innovation entwickelt.

Wie forscht ein IT-Dienstleister?

IT-Unternehmen haben nicht nur die Aufgabe, im Tagesgeschäft zu liefern, die Branche muss auch langfristig denken. Anwendungsorientierte Forschungsprojekte im engen Schulterschluss mit der Wissenschaft sind ein wirksames Mittel zur frühzeitigen Entwicklung neuer Technologien. Bei der Auswahl von Forschungsthemen stehen dabei einerseits die eigenen Kunden und ihr jeweiliges Geschäftsfeld im Fokus, andererseits aber auch die Impulse und neuen Entwicklungen, die die Wissenschaft beisteuert. Darum forscht adesso zum Beispiel zu Themen wie dezentrale Energienetze, eHealth und Datenökosysteme. Denn das sind die Themen, die bereits jetzt vor allem aber in Zukunft für die Kunden große Relevanz haben. Darüber hinaus lohnt es sich eine eigene isolierte FuE-Abteilung zu betreiben, oder Forschung in den jeweiligen operativen Einheiten umzusetzen – also nah am Markt. Berater- und Entwickler-Teams werden so zugleich Forschende. Durch diese enge Anbindung wird gewährleistet, dass Forschung den Bedarf der Praxis im Blick behält.

Innovationen sind Ideen, die erfolgreich sind

Im Innovationsbereich werden Zukunftsszenarien entwickelt, neue Trends und Technologien frühzeitig identifiziert und bewertet sowie deren Potenzial für neue Produkte, Dienstleistungen und Geschäftsmodelle ermittelt. In unserer schnelllebigen VUCA-Welt müssen dabei auch Unsicherheiten berücksichtigt werden. Um als Unternehmen in Zukunft nicht nur zu überleben, sondern auch wachsen zu können, reicht es dabei nicht aus, nur zu wissen, dass Unsicherheiten existieren. Sie müssen auch aktiv in die strategische Planung einbezogen werden. Innovation und Foresight leben vom proaktiven Umgang mit Unsicherheiten. So werden zum Beispiel beim Scenario Planning, besonders unsichere Faktoren mit starkem Einfluss auf den Unternehmenserfolg identifiziert und darauf basierend alternative Zukunftsszenarien entwickelt. Mit diesem Hintergrundwissen können dann auch neue Ideen fundiert bewertet werden, um zu entscheiden, welche davon weiterentwickelt und umgesetzt werden und welche zurückgestellt oder ganz verworfen werden.

Voraussetzung ist natürlich, dass man als IT-Dienstleister sein eigenes Handwerk beherrscht. Die souveräne Nutzung der Technologien in der Softwareentwicklung gehört ebenso dazu, wie die Herausforderungen auf Kundenseite vollends nachzuvollziehen. Ein tiefes Branchenverständnis ist ein wichtiger Erfolgsfaktor. Wer aus diesem Blickwinkel Innovationsthemen betrachtet, kann besser einschätzen, welchen konkreten Mehrwehrt sich der oder die Kunden davon erhoffen dürfen. Kann diese konkrete Idee oder neue Technologie der Kundschaft dabei helfen, wirtschaftlich erfolgreicher zu sein? Sorgt sie für bessere und effizientere Produkte oder Geschäftsmodelle? Wenn diese Fragen mit „ja“ beantwortet werden, macht es Sinn sich mit dem jeweiligen Thema zu beschäftigen. Auf dieser Basis kann man vorausschauend analysieren und sieht, welche Veränderungen auf die Unternehmen zukommen – wie man sie zum Vorteil nutzen kann und welche Kompetenzen dafür notwendig sein werden. So hat man im besten Fall die richtigen Antworten parat, bevor Kunden überhaupt die Fragen stellen. Das alles funktioniert natürlich nur in einem Umfeld, das neue Ideen fördert und unterstützt. Dafür sind Freiräume, Freizeiten und eine Fehlerkultur notwendig, die auch aus verworfenen oder gescheiterten Ideen etwas Positives zieht.

Partnerschaftliche Zusammenarbeit gehört zum Geschäft

Austausch, Kollaborationen und das Zusammenbringen vielfältiger Perspektiven sind wesentliche Bestandteile von Forschung und Innovationen. Große mehrjährige Forschungsprojekte sind deshalb immer als Konsortium angelegt. Hier wird interdisziplinär mit unterschiedlichen Partnern an einem gemeinsamen Ziel gearbeitet. Das Ziel: Aktuelle wissenschaftliche Erkenntnisse konkret zu erproben, Herausforderungen zu identifizieren und praxistaugliche Lösungen dafür zu entwickeln. So baut man fundiertes Wissen über neue Technologien auf, wie zum Beispiel aktuell in Bereichen wie Künstliche Intelligenz, Maschinelles Lernen oder etwa der Blockchain-Technologie und Quantencomputing. Dabei legt adesso zum Beispiel großen Wert auf einen Dreiklang: Die Projekte müssen die eigene Unternehmensstrategie unterstützen, sie müssen für die Kunden nützlich sein und auch eine gesamtgesellschaftliche Relevanz besitzen. Dennoch: IT-Dienstleister sind zunächst Unternehmen und keine wissenschaftlichen Institute, hier wird praxisorientiert geforscht, um das eigene Unternehmen und auch nicht zuletzt die eigenen Kunden fit für die Zukunft zu machen.

Scheitern ist erlaubt

Ohne den Mut, visionär zu denken, gibt es keine Forschung, die uns wirklich voranbringt. Deshalb wird auch nicht aus jedem einzelnen Forschungsprojekt eine marktgängige Lösung. Wenn das so wäre, hat man wohl zu klein gedacht. Forschung braucht einen langen Atem, braucht Kontinuität bis man die Früchte ernten kann.

Häufig geht es dabei um Themen, die noch weit weg vom eigentlichen Kundengeschäft sind. Spannend ist der Zeitpunkt, an dem klar wird, dass ein Thema, eine Technologie vor dem Durchbruch steht, aber noch unklar ist, wie schnell genau das passiert. Dann muss man entscheiden, in welchen Strängen ein Innovationsprozess behandelt wird: Im Rahmen großer Forschungsprojekte, im Rahmen interner Innovationsprojekte oder auch zusammen mit Kunden als Proof of Concept oder Pilot-Projekt um gemeinsam ein neues Thema strategisch aufzubauen. Manchmal entwickelt ein Thema eine so große Dynamik, dass verschiedene Stränge parallel angegangen werden. In den meisten Fällen ist es aber eine Pipeline, die die Themen durchlaufen. Im Forschungskontext steht bei adesso das Thema Datenökosysteme aktuell im Vordergrund. Bei Innovationen fokussieren wir uns auf IT-Themen, die für uns als Softwareunternehmen relevant werden könnten, beispielsweise Software-Entwicklungsmethoden und Werkzeuge auf der Basis von KI oder No-Code- und Low-Code-Ansätzen. Wir prüfen gemeinsam mit unseren Expertinnen und Experten, welche Auswirkungen sie auf unsere Arbeit haben und wie wir sie mit maximalem Nutzen für uns und unsere Kunden einsetzen können.

Besonders hervorzuheben ist, dass die Beschäftigung mit Forschung und Innovation nicht nur unmittelbaren wirtschaftlichen Nutzen hat. Es hilft auch, Mitarbeiter zu motivieren und eine Unternehmenskultur zu leben, die auf Offenheit und Neugierde setzt, im Neuen Chancen sieht und bereit ist, ein Wagnis einzugehen – neue Möglichkeiten zu sehen, neue Wege zu gehen.

Kurzbiografien:

Dr. Angela Carell leitet nicht nur seit mehr als zehn Jahren bei adesso den Forschungsbereich, sie brennt für die Forschung und ist zutiefst davon überzeugt, dass Forschung im Unternehmen wichtig ist. Zusammen mit ihrem Team entwickelt Angela Carell Zukunftsthemen in Anwendungsbereichen der IT. Mit zahlreichen Forschungskonsortien werden so wichtige Erkenntnisse für neue IT-Lösungen gesammelt, um anschließend diese auch direkt bei adesso zu verwerten.

Thomas Bendig ist CIO von adesso und zuständig für Strategic Foresight, Trendscouting, Technologiefrüherkennung und Innovationsmanagement. Wichtig ist für Thomas Bendig, neue gesellschaftliche, wirtschaftliche und digitale Trends und Technologien frühzeitig zu erkennen, zu bewerten und zu nutzen, um sowohl das eigene Unternehmen als auch Kunden vorausschauend auf Veränderungen und Innovationen vorzubereiten. Mit den Ergebnissen werden bei adesso die Weichen so gestellt, dass man auch zukünftig in der Lage ist, seinen Kunden innovative Softwarelösungen anzubieten.

Aufmacher by Canva Studio

Neuer Branchenreport analysiert aktuelle Situation in der Intralogistik

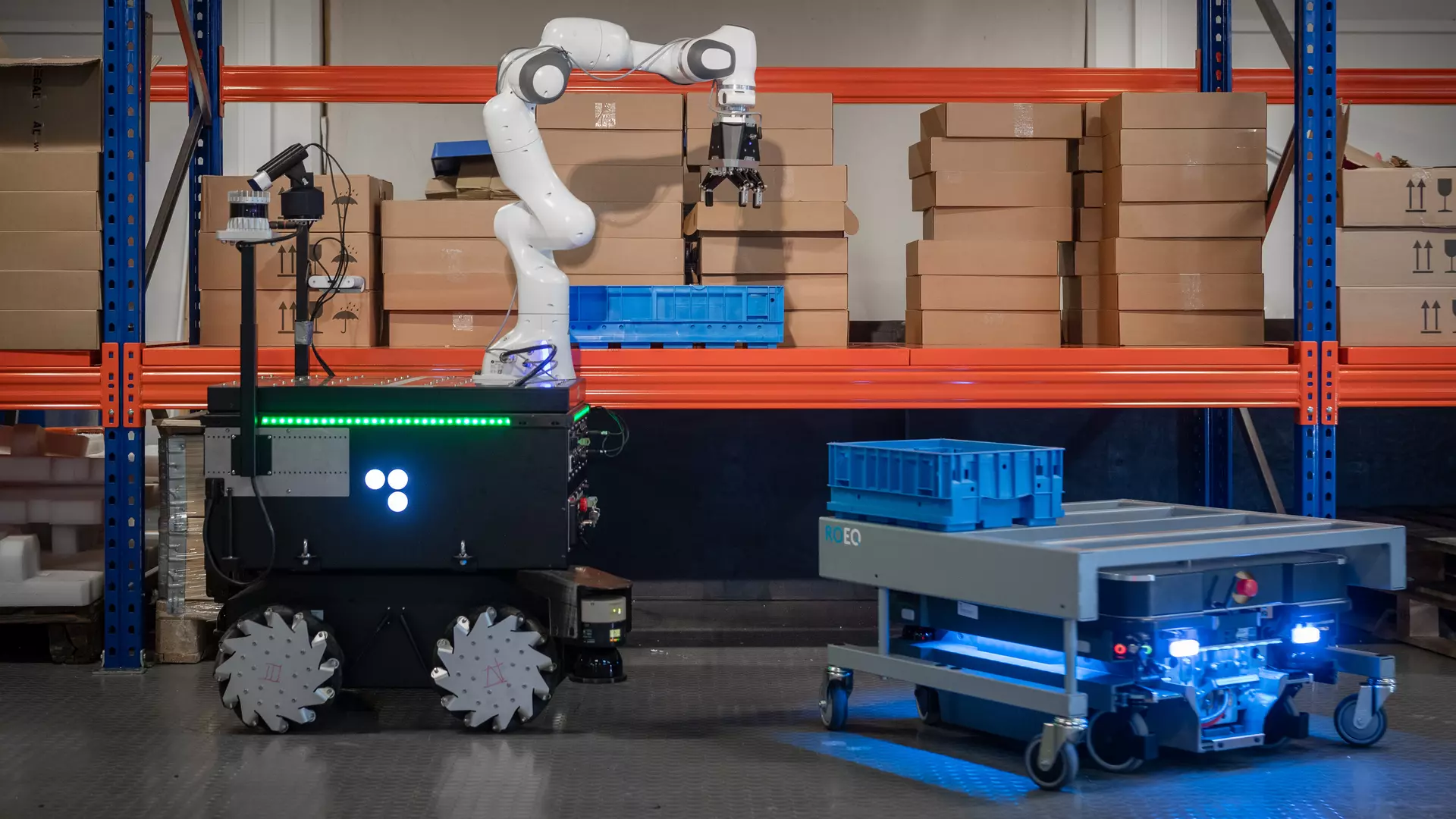

/in Digitalisierung, Future Store, Globalisierung, Künstliche Intelligenz, Mobilität, Nachhaltigkeit, News, Pressemitteilungen, Unternehmen & Märkte/von trendreportAktuelle Herausforderungen in der Intralogistik-Branche erfordern ein Umdenken im Lager – Modernisierungen mit skalierbaren Automatisierungslösungen können Abhilfe schaffen

Neuer Branchenreport von Addverb analysiert aktuelle Situation in der Intralogistik

Köln, 31. Mai, 2023 – Addverb, ein weltweit agierender Anbieter für Robotik- und Automatisierungslösungen, hat einen neuen europäischen Branchenreport veröffentlicht.

Die Studie („Unlock the True Potential of Your Warehouse“) untersucht die aktuelle Situation in der Intralogistik-Branche und zeigt wie Unternehmen mit automatisierten Lagerlösungen in Bestandsanlagen sicher in die Zukunft blicken können.

Der Report analysiert im Detail, inwieweit Modernisierungen (Brownfield-Projekte) dabei helfen dem Fachkräftemangel entgegenzuwirken und den steigenden Kundenerwartungen gerecht zu werden.

Addverb befragte im Rahmen der Studie Branchenexperten und Entscheider aus den Niederlanden, Deutschland sowie aus Großbritannien.

Der Grad der Automatisierung ist in allen drei untersuchten Regionen unterschiedlich. So berichten fast die Hälfte der deutschen Befragten (42 Prozent) von einem „sehr geringen“ Automatisierungsgrad im Lagerbereich ihres Unternehmens. In den Niederlanden (42 Prozent) und in Großbritannien (36 Prozent) gibt jeweils eine Mehrheit an, dass in ihren Unternehmen in diesem Bereich bereits eine Mischung aus manuellen und automatisierten Prozessen besteht.

Auf die Frage nach der Umsetzung einer vollständigen Automatisierung in den einzelnen Regionen gaben nur einige wenige Befragte (11 Prozent in Deutschland, 10 Prozent in den Niederlanden und sieben Prozent in Großbritannien) an, in bereits vollautomatisierten Lagerstrukturen zu arbeiten. Obwohl die Umstellung auf Automatisierung in allen untersuchten Ländern schon weit fortgeschritten ist, gibt es dennoch viele Möglichkeiten für einen weiteren Automatisierungsausbau im Intralogistik-Umfeld.

Intralogistik-Entscheider erkennen Notwendigkeit für Automatisierungsausbau

Der Startschuss für Brownfield-Projekte zur Lagerautomatisierung ist sowohl in Deutschland als auch in den Niederlanden gefallen, um mit flexiblen und nachhaltigen Automatisierungslösungen gut gerüstet in die Zukunft zu gehen.

Während in den Niederlanden 34 Prozent der befragten Entscheider in den nächsten drei Jahren weitere Automatisierungsmaßnahmen ergreifen wollen, planen in Deutschland mehr als ein Viertel der Befragten (26 Prozent) eine Erhöhung der Automatisierung ihrer Anlagen bereits in den nächsten 12 Monaten.

In den Niederlanden gaben zudem 40 Prozent der Befragten an, dass eines der dringendsten Probleme ihrer Branche auch steigende Kosten sind. Auch diese Bedenken veranlassen die Unternehmen, in Verbindung mit sich verändernden Anforderungen auf Kundenseite eine weitere Automatisierung in Betracht zu ziehen. Darüber hinaus ist auch die aktuelle Dynamik des Arbeitsmarkts für niederländische Führungskräfte in der Lager- und Logistikbranche ein wichtiges Thema: 36 Prozent geben den Mangel an qualifiziertem Personal als derzeit größte Herausforderung an und 40 Prozent glauben, dass die hohe Verfügbarkeit anderer Beschäftigungsmöglichkeiten im Arbeitsmarkt die Lagerhaltung für niederländische Arbeitnehmer unattraktiv macht. Auch für ein Viertel (24 Prozent) der deutschen Befragten stellt die Suche nach qualifiziertem Personal eine der aktuell wichtigsten Herausforderungen dar.

Vorteile der Brownfield-Automatisierung

„Moderne Lagerhäuser stehen vor zahlreichen Herausforderungen. Sowohl Fachkräftemangel als auch steigende Kosten und Unterbrechungen in der Lieferkette wirken sich direkt auf die Produktivität und das Endergebnis aus.

Im Gegensatz zu einer kompletten Neuentwicklung bietet die Automatisierung von Bestandsanlagen sehr flexible Lösungen, die nahtlos integrierbar sind: Teile der Lagereinrichtungen bleiben bestehen, während sich z.B. innerbetriebliche Materialflüsse durch autonome und mobile Robotik automatisieren lassen und dadurch flexibel skalierbar werden.

Für Unternehmen bedeutet das Arbeiten innerhalb bereits vorhandener Strukturen, dass sie eine weitergehende Automatisierung mit geringen oder sogar gar keinen Produktionsausfällen einführen können. Außerdem können sie durch die technologische Fortbildung ihrer Mitarbeiter die Attraktivität des Arbeitsplatzes erhöhen und auf lange Sicht so auch ihre Betriebskosten senken“, erklärt Pieter Feenstra, CEO von Addverb EMEA.

Bedenken gegenüber einer schnellen Automatisierungsumsetzung

Trotz der klaren Vorteile einer Modernisierung und Automatisierung des Lagers haben viele der Befragten aber Bedenken. So fürchtet ein Fünftel der niederländischen Entscheider (20 Prozent) eine Beeinträchtigung ihrer Betriebsabläufe. Auch unter den deutschen Unternehmen sind nur 18 Prozent vollends von der Investition in Automatisierung überzeugt. 44 Prozent sehen in ihr aber immerhin einen gewissen Nutzen. Gleichzeitig sieht fast jeder sechste Befragte (16 Prozent) die Rolle der Automation für Umweltschutz und Nachhaltigkeit als „äußert hoch“ an.

In allen drei untersuchten Regionen bezogen sich die von den Entscheidern geäußerten Bedenken dabei auf die Interaktion zwischen Menschen und Roboter. Da für die Bedienung der Systeme hochqualifizierte Fachkräfte erforderlich sind, könnte dies einen neuen Anreiz schaffen, Mitarbeiter zu gewinnen und zu halten. Zugleich müssen Mitarbeiter durch Schulungen aber auch kontinuierlich für die neuen Technologien aus- und weitergebildet werden.

„Unsere Studie hat gezeigt, dass wir gerade in Ländern wie Deutschland, Großbritannien und den Niederlanden in Fragen der Automatisierung insgesamt optimistisch in die Zukunft schauen können. Allerdings lassen sich auch gewisse Defizite beim Verständnis darüber erkennen, wie Automatisierungsprozesse verbessern und dazu beitragen kann, ein modernes Lager zukunftssicher zu machen“, so CEO Pieter Feenstra. „Der Faktor Mensch wird auch weiterhin eine entscheidende Rolle in der Intralogistik spielen. Deshalb konzentriert sich Addverb darauf, das einzigartige menschliche Know-how mit den Vorteilen der Automatisierung für eine optimale Produktivität und Sicherheit zu kombinieren. Wir stehen unseren Kunden im europäischen Markt bei diesen Veränderungsprozessen zur Seite und beraten sie, um eventuelle Wissenslücken zu schließen. Unser Ziel ist es, Unternehmen nachhaltig zu stärken und sie wettbewerbsfähig zu halten.“

Unternehmen erkennen den Mehrwert einer flexiblen Automatisierungslösung

Angesichts der von allen Befragten in den drei Regionen geäußerten Bedenken in Bezug auf Personalknappheit, Umsetzungskosten und sich verändernde Kundenanforderungen, empfiehlt es sich für Unternehmen, über den Einsatz von Automatisierung bestehender Anlagen nachzudenken. Dies könnte dazu beitragen, einige dieser Herausforderungen ohne hohe Anfangsinvestitionen oder Beeinträchtigungen des laufenden Betriebs lösen zu können. Um den Lager- und Logistiksektor unter den aktuellen Wirtschaftskonjunkturbedingungen zukunftssicher zu machen, müssen Unternehmen künftig in der Lage sein, schnell auf Veränderungen zu reagieren – am besten gestützt durch skalierbare Lösungen. Eine Voraussetzung dafür ist das noch bessere Verstehen des erheblichen Mehrwerts einer flexiblen integrierten Automatisierung. Denn die Möglichkeiten einer flexiblen und skalierbaren Automatisierungslösung und der Mehrwert im Hinblick auf Wirtschaftlichkeit und ROI sind nicht immer für alle Beteiligten sofort ersichtlich. Sie müssen zunächst mit dem Kunden aufgenommen, gemeinsam erarbeitet und verständlich aufgezeigt werden.

Der vollständige Report mit allen Detailinformationen steht unter diesem Link zum Download bereit.

Was bedeutet Modernisierung durch Brownfield-Automation?

Brownfield-Automation ist der Prozess der Implementierung von Automatisierung in Anlagen, die bereits bestehen und in Betrieb sind. Solche Anlagen können sowohl mit statischen als auch mit flexiblen Lösungen modernisiert werden. Diese verbessern die Effizienz, Zuverlässigkeit, Genauigkeit, Sicherheit und die Fähigkeit proaktiv auf Marktschwankungen zu reagieren. Gleichzeitig senken sie die Betriebskosten und mindern die Auswirkungen von menschlichen Fehlern.

Zur Methodik der Studie

Die quantitative Studie wurde in den Monaten Januar und Februar 2023 durchgeführt. In drei Ländern (Deutschland, Großbritannien und den Niederlanden) wurden 300 Entscheidungsträger in Unternehmen mit über 500 Mitarbeitern aus den Branchen Einzelhandel/Großhandel (55 Prozent), Fertigung (33,33 Prozent) sowie aus dem Versand/Vertrieb (11,66 Prozent) befragt, darunter sowohl Entscheider auf Fachebene (Supply-Chain-/Logistik-Manager) als auch auf Geschäftsführungsebene (Vice Presidents, Gründer und Chief Executive Officers).

##

Über Addverb

Addverb Technologies ist ein globales Unternehmen für Robotik und Lagerautomatisierung mit Niederlassungen in den Niederlanden, Deutschland, den USA, Indien (Hauptsitz), Singapur, Australien, den Vereinigten Arabischen Emiraten und Malaysia. Das Unternehmen arbeitet mit einer Reihe von Unternehmen zusammen, von jungen Start-ups bis hin zu etablierten Fortune-500-Unternehmen, wie Reliance, Amazon, Johnson & Johnson, PepsiCo, DHL, Unilever, TATA, Coca-Cola und Colgate-Palmolive. Durch die Bereitstellung von Robotik- und Intralogistik-Automatisierungslösungen auf der Grundlage von Industrie 4.0-Technologien hilft es Unternehmen, ihre intralogistischen Herausforderungen in Bezug auf Lagernutzung, Produktivitätsprobleme, betriebliche Kosteneffizienz, Bestandsmanagement und Materialhandling zu bewältigen.

Weitere Informationen stehen auf der Addverb Webseite zur Verfügung .

Aufmacherfoto / Quelle: https://www.pexels.com/de-de/@tiger-lily/

13. Auflage B2B Social Media Studie geht an den Start

/in Allgemein, Digitalisierung, Future Store, Gesundheit, Globalisierung, Journalisten, Neue Gesellschaft, New Work, Studien/von trendreport

Machen Sie mit?

Bereits Ende April 2023 startete die 13 Runde der einzigen Langzeitstudie zur Untersuchung der Social-Media-Kommunikation von B2B-Unternehmen. Die Ergebnisse dürften 2023 besonders interessant werden. Die Auswirkungen eines in vielen Unternehmen veränderten Führungsverhalten in der Nutzung von Social Media dürfte in diesem Jahr noch deutlicher zum Ausdruck kommen. Damit unterstreicht die Studie erneut, dass ihre Resultate und Vergleichsmöglichkeiten der Unternehmen aller Wirtschaftsbereiche und Größenordnungen wertvolle Orientierung und Entscheidungshilfen für ihre Budget- und Strategieplanung.

Die Studie untersucht auch in ihrer aktuellen Auflage die Veränderungen, die sich im Nutzerverhalten der Social-Media-Kanäle in der B2B-Sektor ergeben haben. Gerade das Alleinstellungsmerkmal eines Datenvergleichs über den Zeitraum von 13 Jahren hinweg, bietet Kommunikationsentscheidern von B2B-Unternehmen im DACH-Raum die einmalige Möglichkeit, ihr eigenes Social-Media-Nutzungsverhalten konkret, kontinuierlich und auf sicherem Fundament zu analysieren, sich mit dem richtigen Kommunikationsmix von Wettbewerbern abzugrenzen und Trends sowie Entwicklungen auf Grundlage valider Datenauswertung richtig einzuordnen und umzusetzen.

Die Schlussfolgerungen ermöglichen es Kommunikationsentscheidern, sich in den sozialen Online-Netzwerken durch passgenaue und glaubwürdige Auftritte von Mitbewerbern zu unterscheiden.

Insbesondere wird die Weiterentwicklung der im vergangenen Jahr deutlich gewordenen Trends, dass Corporate Influencer weiter auf dem Vormarsch sind und kooperativ sowie laissez faire geführte Unternehmen ihre Mitarbeiter dahingehend fördern.

Folgende Schlüsselfragen stehen für die Langzeitstudie des „Erster Arbeitskreis Social Media in der B2B-Kommunikation“ daher im Fokus:

- Wie hat sich die Social Media Nutzung im vergangenen Jahr weiterentwickelt?

- Welche Trends und Entwicklungen zeichnen sich nun ab oder etablieren sich?

- Welche Erwartungen stellt die B2B-Community an ihre Social Media Präsenz?

Rückblickend auf die Ergebnisse des letzten Jahres erläutert Jacqueline Althaller, Herausgeberin der Studie und Kommunikationsexpertin: „Wir sehen deutlich, dass das Pendel umschwingt. Mitarbeiter von B2B-Unternehmen erhalten mehr Freiheiten und stehen damit aber auch in größerer Verantwortung. Es wird nun spannend zu sehen, wie sich das in diesem Jahr in den neuen Studienergebnissen widerspiegelt. Mit Hilfe von erfahrenen und medienaffinen Studienpartnern wollen wir unsere Teilnehmerzahlen in diesem Jahr noch einmal deutlich steigern und freuen uns über jeden, der sich aktiv beteiligt!“

Die Kooperation mit der »OBSERVER« GmbH hebt das Potenzial noch einmal deutlich für Österreich an. Wie auch im letzten Jahr wird die Studie in der Schweiz durch die KünzlerBachmann Directmarketing AG unterstützt.

Die Datenerhebung für den gesamten DACH-Raum läuft bis zum 1. August. „Mit der Teilnahme an der Online-Umfrage über diesen Link sichern Sie sich den kostenlosen Erhalt der Ergebnisse im Herbst“, ergänzt Althaller abschließend.

Über den Ersten Arbeitskreis für Social Media in der B2B-Kommunikation:

Im Sommer 2010 wurde der „Erste Arbeitskreis Social Media in der B2B-Kommunikation“ von Jacqueline Althaller, Gründerin der gleichnamigen Agentur ALTHALLER communication ins Leben gerufen, um konkrete Fragestellungen von Seiten B2B zu beantworten und dieses Wissen auch weiterzuvermitteln. Umfragen führt der Arbeitskreis jährlich durch, um Trends und Entwicklungen in der Social Media Kommunikation feststellen zu können. Zu den Mitgliedern gehören Unternehmen unterschiedlichster Branchen und Größenordnungen – von IT bis Healthcare. Begleitet wird der Arbeitskreis von Vertretern aus Wissenschaft und Forschung. Der Arbeitskreis verfolgt keine wirtschaftlichen Interessen.

Pressekontakt

Jacqueline Althaller

ALTHALLER communication GmbH

Elisabethstraße 13

80796 München

Tel: +49 89 38 66 52 61

Angst ist ein schlechter Berater

/in Digitalisierung, Künstliche Intelligenz, Sicherheit, Specials, Trend Monitor/von Martina Bartlett-MattisDigital und nachhaltig zu mehr Resilienz

/in Digitalisierung, Expertenpanel, Future Store, Globalisierung, Neue Gesellschaft, Sicherheit, Unternehmen & Märkte, Wissenskultur/von trendreportDigitalisierung und Nachhaltigkeit können die Resilienz von Unternehmen stärken. Warum beide Trendthemen zusammen gut funktionieren und wie sie mit intelligentem Datenmanagement die Kundenkommunikation optimieren, lesen Sie im Folgenden.

Von Thomas Sperl, Director Digitisation, Steffen Mahlmeister, Solution Manager Inbound, und Andreas Keck, Head of Sustainability & Business Development bei Paragon DACH & CEE, ein führender Dienstleister für erfolgreiche Kundenkommunikation.

Hohe Erwartungen von Kunden und Mitarbeitern, Digitalisierungsthemen und Gesetzesvorgaben wie die Verpflichtung für einen Nachhaltigkeitsbericht setzen Unternehmen zunehmend unter Druck. Was gerne auf die lange Bank geschoben wurde, ist inzwischen zu dringenden Pflichtthemen geworden. Diesen Herausforderungen zu begegnen kann allerdings einfacher sein als man denkt, denn sie bedingen sich oftmals gegenseitig. Das kann Potenziale freisetzen und im besten Fall ganz neue Lösungswege ebnen – und so die Resilienz von Unternehmen stärken, wie Paragon anhand von Kommunikationsprozessen zeigt.

Es braucht zeitgerechten Informationsaustausch

Der große Trend im Bereich der Kommunikationsprozesse heißt Digitalisierung. Für viele Unternehmen stellt Paragon transaktionale Kommunikation, wie bspw. Rechnungsprozesse von analog auf digital um – damit tragen Unternehmen auch maßgeblich zu der CO2-Reduzierung bei, im Vergleich zum traditionellen physischen Versand. Das ist nachhaltig im Sinne des Klimas, kostengünstiger als der bisherige Postweg und schneller, da die Bereitstellung unverzüglich stattfindet. Ein großer Kunde aus dem Telekommunikationsbereich konnte so in nur einem Jahr rund 3 Mio. Euro einsparen und einen erheblichen Anteil zur ökologischen Nachhaltigkeit beitragen. Informationen an seine Kunden stellt er damit schneller als zuvor zur Verfügung und verbessert so den Kundenservice. Die Kosteneffizienz bei gleichzeitig nachhaltigem Handeln liegt damit auf der Hand – der Schritt ist wirtschaftlich und auch ökologisch nachhaltig und trägt dabei auch noch zur Kundenzufriedenheit bei.

Anpassungsfähige Kommunikation stärkt die Kundenbindung

Aber ist es damit genug? Nein. Während die Digitalisierung durchaus wie ein Katalysator für Nachhaltigkeitsthemen wirkt, müssen wir uns, um auf Resilienz zu setzen den Gesamtkontext des Kunden anschauen und nachhaltig, im Sinne von langfristig wirkungsvoll mit ihm kommunizieren. Das heißt, wir müssen seine persönlichen Vorlieben und Bedürfnisse kennen und die Kommunikation darauf anpassen – das stärkt die Kundenbindung. Wir müssen wissen, was der Kunde wirklich will – digitale Kommunikation? Physische Post? Für verschiedene Anlässe etwas Unterschiedliches? Oder eine Kombination aus beidem? Und dabei sollte man sich immer überlegen: Was mute ich mit meinen Anpassungen – zum Beispiel mit einer etwaigen Komplettumstellung von physisch auf digital – dem Kunden zu? Einen weiteren digitalen Kommunikationskanal? Die unzähligen Portale samt Logins, E-Mails, Postfächer und Messenger schaffen eine Komplexität, die zunehmend lästiger wird – für die meisten von uns. Wie oft haben Sie sich schon gefragt: Wie lautetet mein Passwort? Oder: Wo finde ich jetzt wieder was?

Kunden von morgen, die jeden Monat digitale Rechnungen im Portal erhalten, wie etwa mit ein- und demselben monatlichen Betrag für ihr Handy und eine E-Mail mit dem Hinweis auf die Rechnung, fragen sich: Brauche ich das überhaupt in einem ohnehin schon überquellenden E-Mail-Postfach? Vielleicht reichen auch eine Jahresaufstellung und ein Hinweis, wenn es mal abweichende Beträge gibt? Darauf sollten Unternehmen reagieren und die Kommunikation auf die Bedürfnisse ihrer Kunden flexibel anpassen. Gleichzeitig sind Verbraucher durch Behörden, die alles per Post schicken und Arztpraxen und Apotheken, die per Gesetzesvorgaben am Fax festhalten, an alte Strukturen und alte Formate gewöhnt.

Am stärksten wird dies an Kündigungsschreiben sichtbar: Im Jahr 2023 schickt der deutsche Konsument die Kündigung eines Vertrags immer noch per Post, meist per Einschreiben. Dies zeigt: Die hybride Kommunikation bleibt erst mal unerlässlich, weil es sie braucht.

Für Unternehmen heißt das, im Informationsaustausch hochindividuell entlang der kompletten Customer Journey konsequent die idealen Kommunikationskanäle und -formate zu definieren und zu personalisieren. Viele tun sich allerdings schwer mit der Entscheidung, was wirklich analog bleiben sollte – vor allem wenn sie nachhaltig arbeiten wollen.

Digital ist nicht gleich nachhaltig, aber ermöglicht nachhaltige Lösungen

Es ist wichtig, zu verstehen, dass digital ist nicht immer automatisch auch nachhaltig ist – weder ökonomisch noch ökologisch. So schaffen Unternehmen mit haptischer Marketingkommunikation (Print-Mailings) zur Absatzförderung mit jedem investierten Euro 7,34 Euro Umsatz. Warenkorbumsätze steigen durch Print-Mailings sogar um 6,4 Prozent[1]. Das schafft keine E-Mail, auch wenn sie günstiger ist und vermeintlich weniger Emissionen verursacht. Denn für denselben Werbeeffekt der haptischen Kommunikation müssten mindestens 5- bis 6-mal so viele E-Mails verschickt werden – so löst sich der ökologische Nachhaltigkeitsaspekt einer E-Mail in Luft auf. Digital allein ist also nicht immer gleich nachhaltig. Umso wichtiger ist es, herauszufinden und zu unterscheiden, wen man digital oder physisch erreicht – da steckt noch viel Potenzial in den Unternehmen. Meist trägt das Zusammenspiel von Kunden-orientierten Kommunikationsprozessen, Nachhaltigkeit und Digitalisierung zu einer sinnvollen Lösung bei, die den Kunden passend anspricht.

[1] CMC-Print-Mailing-Studie 2022

Best Practice: Wie Digitalisierung die Nachhaltigkeit von Printmailings erhöht

Ein Beispiel dafür, wie Digitalisierung und Nachhaltigkeit gut zusammenspielen, kommt aus dem täglichen Instrumentarium von Paragon: Ein Versandkonzept, das Emissionen im Postversand bzw. bei Printmailings spart. Ist ein haptisches Mailing in der Kommunikation aus strategischen Gründen sinnvoll, erhöhen Unternehmen mithilfe von Paragon die Nachhaltigkeit des Postversands, indem sie ihre Adressen anhand von Daten digital sortieren und die Mailings Empfänger-nah an einem vom vier Standorten in Deutschland drucken sowie versenden lassen. Das ist ganz einfach und spart durchschnittlich 20 Gramm CO2 pro Briefsendung. Hier gehen Digitalstrategie im Sinne von Datennutzung und Nachhaltigkeitskonzept Hand in Hand. Gleichzeitig garantiert Paragon eine schnelle Zustellung über Partnerschaften mit lokalen Zustellern und reduziert über Portooptimierung damit Kosten. Vorgelagerte Maßnahmen verringern außerdem Streuverluste und Fehler: Paragon überprüft Adressen vorab digital auf Aktualität und reduziert so Falschsendungen oder auch unnötig produzierte Sendungen auf ein Minimum. Dies spart wiederum CO2 aus Produktion und Versand. Mehr zu den nachhaltigen Möglichkeiten in der Kundenkommunikation finden sich in den Nachhaltigkeitsberichten von Paragon, die das Unternehmen bereits freiwillig seit 2020 erstellt.

Wie bekommen Unternehmen die Prozesse in den Griff?

Um nachhaltige Konzepte umzusetzen und sie auf die Zielgruppen zuzuschneiden, braucht es ein perfektes Zusammenspiel von umfassenden Dokumentenmanagement und digitalen Prozessen, die alle Daten zusammenbringen, strukturieren und für unterschiedliche Szenarien, etwa Empfänger-bezogen automatisiert, aufbereiten.

Informationen aus Briefen, E-Mails samt Anhang in jeglichen Formaten bis hin zum Messenger, Social-Media und Apps, müssen digital in strukturierte Daten gebracht werden, um sie automatisiert, nachhaltig und Kunden-bezogen verarbeiten zu können. Dies betrifft nicht nur das Marketing, sondern jeglichen Informationsaustausch mit Kunden aus vielen Bereichen innerhalb eines Unternehmens – auch die Rechnungsstellung, den Kundenservice und Vertragsthemen. Das erfordert wesentlich mehr Flexibilität von Unternehmen im Umgang mit ein- und ausgehenden Formaten und deren intelligenten Verarbeitung.

In den meisten Unternehmen ist die Orchestrierung von Informationsflüssen komplexer als jemals zuvor. Dies wird weiter zunehmen. Die Kanalisierung von Daten und die Übersetzung in eine verwertbare Nutzung ist immer noch eine Mammut-Aufgabe für viele Unternehmen. Aus der täglichen Zusammenarbeit mit zahlreichen Kunden weiß Paragon, dass die größte Herausforderung für die meisten Unternehmen ist, die zahlreichen Informationen aus unterschiedlichen Systemen und Kanälen zentral zu nutzen. Durchschnittlich sind es 7 bis 10 Systeme, in denen relevante Daten und Informationen gespeichert sind, die jedoch nicht oder meist nur unzureichend konsolidiert werden. Die Notwendigkeit dafür wird aber immer mehr Unternehmen bewusst und durch deren Kunden auch eingefordert.

Personalmangel, Hackerangriff und andere Hindernisse überwinden

Die gute Nachricht ist, dass Unternehmen das gar nicht alles selbst machen müssen. Insbesondere der aktuelle Personalmangel, gerade bei Fachkräften, erweist sich als Bremse für Digital- und Nachhaltigkeitsthemen. Das muss aber nicht sein. Mithilfe von externen Partnern können Unternehmen ihre Kundenkommunikation, Digitalisierungsprojekte und Dokumentenmanagement weiter voranbringen. Ob laufend als langfristiger Partner oder Projektbezogen kann Paragon unterstützen und übernimmt die Aufbereitung, Zusammenführung und Nutzung der Daten sowie die Abwicklung von Kundenkommunikation und Lieferantenkorrespondenz für Unternehmen. Selbst bei unvorhersehbaren Ereignissen – etwa einem Systemausfall oder Hackerangriff über mehrere Tage, welche eine nachgelagerte Aufarbeitung Kundenkommunikation erfordern können – ist es möglich, die Bearbeitung der angestauten Kommunikation schnell auszulagern. So haben wir dies zuletzt für einen Kunden aufgrund eines Cybersicherheitsvorfall übernommen. Nach Personalrekrutierung in unseren europäischen Standorten, wo die Situation der Fachkräfte eine weitaus entspannter als in Deutschland ist, und intensiver zweiwöchiger Schulung, können 70.000 Kundenanliegen innerhalb von 3 Monaten abgearbeitet werden. Das sind über 1.000 E-Mails an einem Tag. Unternehmen schätzen hierbei vor allem, dass sie sich währenddessen weiter ihrem Kerngeschäft widmen können.

Aufmacherbild:

Alex Shute auf Unsplash

3D-Anatomie in der medizinischen Ausbildung

/in Allgemein, Digitalisierung, Gesundheit, Unternehmen & Märkte/von Daniela HaselbauerGastbeitrag

3D-Anatomie in der medizinischen Ausbildung: Ein Weg für mehr Inklusion und bessere medizinische Versorgung

Im Laufe der letzten Jahre ist mir klar geworden, dass technologischer, medizinischer und sozialer Fortschritt Hand in Hand gehen. Die gesellschaftlichen Fortschritte, die wir im 20. und 21. Jahrhundert gemacht haben, haben die Rechte und die Repräsentation von People of Color gestärkt und zu sichtbaren Veränderungen in Film und Fernsehen und auch der Politik geführt. Doch die notwendige Entwicklung ist in diesen und vielen anderen Bereichen längst nicht abgeschlossen. Wenn ich gefragt werde, wo die Repräsentation von Frauen und People of Color besonders aus der Zeit fällt, ist meine Antwort: In der medizinischen Ausbildung. Heutzutage sind Medizinstudierende, Dozierende und ärztliches Personal trotz vieler gesellschaftlicher Fortschritte weiterhin mit Materialien, Texten sowie Lehrplattformen und Technologien konfrontiert, die auf größtenteils jahrhundertealten, weißen und männlichen Modellen basieren. Als ein global führendes Unternehmen für medizinische Ausbildung und klinische Lösungen haben wir daher beschlossen, dass es an der Zeit ist, die Lücken zu schließen, um ein integrativeres Gesundheitssystem für alle zu ermöglichen. Dies hat praktische Auswirkungen auf Ausbildung, Gesundheitsversorgung und den medizinischen Fortschritt – insbesondere für People of Color.

Viele Studien belegen das Problem: Eine Studie aus dem Jahr 2006 zeigt, dass der sogenannte schwarze Hautkrebs (Malignes Malom) bei People of Color häufig nicht oder zu spät diagnostiziert wird. Daher ist das Risiko, an der Krankheit zu sterben, doppelt bis dreifach höher als bei Menschen mit heller Hautfarbe. Bei Borreliose-Patient*innen, so eine aktuelle Studie, weisen 34% der Patient*innen of Color neurologische Symptome auf, verglichen mit nur 9% der hellhäutigen Patient*innen.

Die negativen Auswirkungen der Unterrepräsentation sind eindeutig und alarmierend. Es ist zwingend notwendig, ein viel stärkeres Augenmerk auf Inklusion in der medizinischen Versorgung und Ausbildung zu legen. 2018 hat eine amerikanische Studie in der renommierten Zeitschrift Journal of Medical Education and Curricular Development Abbildungen in allgemeinmedizinischen Texten unter Gesichtspunkten der Diversität untersucht. Das schockierende Ergebnis war, dass nur 5% der Abbildungen dunkle Hauttöne enthielten. Die Medizin hat über Jahrhunderte hinweg ein helles, männliches und europäisches Modell für die Lehre übernommen und dieser Tatsache wurde lange wenig Aufmerksamkeit geschenkt.

Die gute Nachricht ist, dass sich an diesem Umstand etwas ändert. Es hat ein Prozess eingesetzt, in dem Lehrmaterialien kritisch reflektiert werden, um die Vielfalt der Gesellschaft besser abzubilden und den sogenannten „Unconscious Bias“ in der Medizin für zünftige Generationen zu bekämpfen. Nicht zuletzt tragen auch die Digitalisierung der medizinischen Ausbildungen und technologische Fortschritte zu dieser Entwicklung bei.

Anatomische 3D-Modelle haben während der Covid-19 Pandemie einen Boom erlebt. 3D-Learning ist nun ein wichtiger Bestandteil in der Ausbildung medizinischer Fachkräfte. Als einer der größten Anbieter medizinischer Lehrangebote und Lernplattformen, ist es ein wichtiges Anliegen von Elsevier, die neuen Möglichkeiten des technologischen Fortschritts in der 3D-Animation für mehr Diversität und Inklusion in der Lehre zu nutzen. Beim Blick auf die bestehenden anatomischen 3D-Modelle vor einigen Jahren haben wir festgestellt, dass sich dringend etwas ändern muss. Nordeuropäische Körper und Gesichtsmerkmale waren stark überrepräsentiert, weil der Großteil des vorhandenen anthologischen Materials auf dieser Art von Körper basierte.

Jan Herzhoff President Global Health Markets; Elsevier

Heute kann ich mit Stolz sagen, dass Complete Anatomy 2023, die jüngste Version von Elseviers 3D-Anatomie-Plattform, als weltweit erstes umfassendes 3D-Modell der menschlichen Anatomie viele verschiedene Hautfarben und Gesichtsmerkmale umfasst. Complete Anatomy hat 3,4 Millionen Nutzer*innen, wurde schon 20 Millionen Mal heruntergeladen und wird von mehr als 500 wissenschaftlichen Institutionen verwendet. Angesichts dieser Reichweite sehen wir uns in der Verantwortung etwas zu tun. Bereits letztes Jahr haben wir das weltweit erste weibliche 3D-Anatomie-Modell eingeführt. Es hat also bis 2022 gedauert, bis Medizinstudierende nicht mehr mit rein männlichen Modellen lernten. Mit der neuesten Version unserer Plattform kann nun neben den männlichen und weiblichen Modellen auch aus einer breiten Palette von Hauttönen und Gesichtsmerkmalen gewählt werden, um die Lernenden selbst sowie ihre späteren Patient*innen besser zu repräsentieren. Das leistet einen Beitrag für eine bessere Gesundheitsversorgung und genauere Diagnosen – besonders für People of Color.

Indem wir die menschliche Vielfalt besser darstellen, wollen wir zwei Dinge erreichen: Jeder Mensch, sowohl die Mediziner*innen als auch die Patient*innen, soll sich in der anatomischen Lehre repräsentiert fühlen. Außerdem hoffen wir, dass Ärzt*innen unterbewusste Vorurteile aktiv hinterfragen, indem wir auf diese Sachverhalte aufmerksam machen.

Die neuen Funktionen von Complete Anatomy sind Teil einer Entwicklung, die wir als Unternehmen durchlaufen. Wir sind bestrebt, unsere Inhalte für alle zugänglich zu machen und wir setzen uns für notwendige Veränderung in der Branche ein. Es ist wichtig, dass führende Unternehmen wie Elsevier ihre Produkte weiterentwickeln, um technologisch fortschrittlich zu bleiben und innovativ zu sein. Mit diesen Innovationen wollen wir aber auch zu gesellschaftlichem Fortschritt beitragen und alle Menschen repräsentieren und einbeziehen.

Über den Autor:

Jan Herzhoff ist Präsident der Geschäfte des globalen Gesundheitswesens von Elsevier. Diese liefern Lösungen zur Informationsanalyse für Krankenhaussysteme und akademische Einrichtungen. Im Jahr 2012 kam Jan zu RELX, der Unternehmensgruppe, zu der Elsevier gehört. Er verfügt über ein breites Spektrum an Geschäftserfahrungen im Gesundheitswesen in verschiedenen Sektoren und war in verschiedenen Positionen bei Elsevier tätig, zuletzt als Managing Director für APAC Health in Singapur mit Schwerpunkt auf wichtigen Wachstumsmärkten wie China, Indien und Japan. Zuvor war er General Manager des internationalen Bildungsgeschäfts von Elsevier in London, wo er durch wichtige Produkteinführungen und Akquisitionen maßgeblich an der Umwandlung von Printmedien zu elektronischen Produkten beteiligt war. Bevor er zu RELX kam, war Jan als Engagement Manager bei McKinsey & Company in München tätig. Er hat einen PhD und einen Master in Informationssystemen von der London School of Economics sowie einen Master in Finanzen und Rechnungswesen von der Universität Bayreuth.

Bildquelle: pixabay.com/

KI.Fabrik: Roboter als Teammate

/in Digitalisierung, Expertenpanel, Finanzen, Future Store, Globalisierung, Künstliche Intelligenz, Mobilität, Nachhaltigkeit, News, Pressemitteilungen, Unternehmen & Märkte, Wissenskultur/von trendreportNeues Robotik-Lab der TUM im Deutschen Museum

Aktuelle Fabriken kommen aus Zeiten der großen Stückzahlen und der Programmierung, in denen der Roboter eine spezielle Aufgabe perfekt und beliebig oft ausführen kann. Doch die Kundenanforderungen haben sich geändert und werden immer kleinteiliger. Deshalb wird sich auch die Fabrik wandeln. „Um spezialisierte, individuelle und häufig mechatronische Produkte zu vertretbaren Kosten konstruieren und schnell herstellen zu können, sind eine skalierbare flexible Manufaktur nötig und Roboter, die lernfähig sind“, ist Prof. Klaus Bengler von der TUM überzeugt.

Diese Fabrik der Zukunft zu schaffen ist das Kernziel des Mitte 2021 gestarteten Leuchtturmprojektes KI.Fabrik, das der Executive Director des Munich Institute of Robotics and Machine Intelligence (MIRMI), Prof. Sami Haddadin, initiiert hat und dessen Leitung für die Forschungs- und Entwicklungsprojekte der Ergonomie-Professor Bengler übernommen hat. In dem neuen Forschungslaboratorium wird dieser neue Ansatz nun in die Praxis gebracht.

Bayerns Wissenschaftsminister Markus Blume lobte: „Hier gibt’s KI zum Anfassen – ein Forschungslabor direkt im Museum, das ist einzigartig: Dank der Hightech Agenda Bayern erforschen kluge Köpfe im KI.Fabrik-Lab die Fragen: Wie können Mensch und Künstliche Intelligenz voneinander lernen, wie voneinander profitieren? Der Standort im Deutschen Museum macht den direkten Blick auf Forschung und Fortschritt möglich. Das ist Wissenschaftskommunikation und -dialog der besten Art.“

Wissenschaftlerin Keija Chen beobachtet, wie ihr Roboter Kabel in die richtige Position bringt. Bildmotiv: Andreas Heddergott / TUM

„Auf die menschliche Expertise kommt es an“

Die technologische Basis bieten digitale Zwillinge und Robotik-Hardware, die von einer KI-Plattform gesteuert werden. Bengler will anhand dieses Systems zeigen, dass Roboter Aufgaben selbständig ausführen können, lernfähig sind und dass sie den Menschen zuarbeiten können. „Auf die menschliche Expertise kommt es an“, sagt Psychologe Bengler, „der Roboter fungiert als Teammate.“ Im neuen Robotik-Lab des MIRMI sind aktuell knapp 100 Roboterarme damit beschäftig sind, sich Kabel zu reichen, nachzumachen, was Wissenschaftler:innen ihnen zeigen, gemeinsam zu lernen und Getriebeteile zusammenzusetzen.

Auf acht so genannte Cases fokussieren die Doktorand:innen und Post-Docs aus acht Lehrstühlen der TUM. Von Teleoperation über kollektives Lernen bis hin zum Netzwerkdesign werden wichtige wissenschaftliche Themen erforscht. Und die Fähigkeiten der lernfähigen Roboter wachsen ständig: Der Roboter weicht Kollisionen aus, kommuniziert über weite Strecken via Teleoperation oder kooperiert mit anderen Robotern. Sämtliche Fähigkeiten stehen über eine Softwareplattform auch anderen Robotersystemen plattformunabhängig zur Verfügung. Zudem kann der Roboter gewisse Fähigkeiten auf vergleichbare Aufgaben anwenden. „Der Roboter trainiert selbständig und transferiert sein Wissen“, so Prof. Bengler.

Weitere Informationen und Links

- Leuchtturmprojekt KI.Fabrik

- Von industrieller Seite unterstützen der Autohersteller BMW, der Spezialist für Antriebstechnik Wittenstein, die Robotikunternehmen Franka Emika und Reactive Robotics, das Elektronikunternehmen TQ-Systems und der Maschinenbauer Linde Material Handling die technischen Entwicklungen im Leuchtturmprojekt KI.Fabrik.

- Die TUM ist u.a. durch die Departments für Maschinenwesen, für Elektrotechnik und Informationstechnik sowie für Informatik im Konsortium vertreten. Insgesamt stehen für das Gesamtprojekt bis 2025 etwa 13 Millionen Euro zur Verfügung, die primär in den Aufbau von Infrastruktur investiert werden. Eine Gesamtlaufzeit bis 2030 ist geplant.

Kontakte zum Artikel:

Prof. Klaus Bengler

Technische Universität München

Lehrstuhl für Ergonomie

Tel: 089 289 15400

bengler@tum.de

www.tum.de

MLOps bringt ML-Modelle schnell in die Produktion

/in Allgemein, Creative Commons CC BY-ND, Digitalisierung, Freie Inhalte, Künstliche Intelligenz/von Martina Bartlett-MattisGroße Chance für den Mittelstand

/in Digitalisierung, Expertenpanel, Freie Inhalte, Future Store, Gesundheit, Globalisierung, Journalisten, Künstliche Intelligenz, Mobilität, Nachhaltigkeit, New Work, Sicherheit, Specials, Wissenskultur/von trendreportGroße Chance für den Mittelstand: Digitalisierungspotenziale erkennen und nutzen

Gastbeitrag:

Jedes Unternehmen muss anders digitalisiert werden – davon ist Matthias Aumann, Geschäftsführer der vollständig digitalen Unternehmensberatung Mission Mittelstand, überzeugt. Gemeinsam mit seinem Team hat er bereits über 3.000 Partnerbetriebe bei der Transformation begleitet und ihnen zum Wachstumserfolg verholfen. Sein Praxiswissen aus über zehn Jahren Unternehmertum teilt er zudem als Mittelstandsexperte. Im Folgenden gibt er Einblicke in seine strategische Beratung zur Bewältigung anfänglicher Hürden im Bereich der Digitalisierung kleiner und mittelgroßer Unternehmen.

Kleine und mittelgroße Unternehmen (KMU) bilden das eigentliche Herzstück der deutschen Wirtschaft. Sie gelten branchenübergreifend als wichtige Arbeitgeber, Innovatoren und Wachstumstreiber. In den aktuellen krisengeprägten Zeiten sehen sich KMU jedoch mit vielfältigen Herausforderungen konfrontiert und müssen ein extrem hohes Maß an Anpassungsfähigkeit beweisen. Sie sollten deshalb vermehrt auf ihr großes Entwicklungspotenzial und ihre Stärken, wie ausgeprägte Kundennähe und schlanke Strukturen für schnelle Entscheidungen, setzen. Doch mittelgroßen Unternehmen mit dynamischem Wachstum fehlt meist noch die passende Strategie, um die nächsten Schritte zu gehen und sich strukturell gut aufzustellen. Der Einsatz von digitalen Technologien kann hier den entscheidenden Unterschied machen und Unternehmen auf das nächste Level bringen. Doch gerade hiermit haben viele Entscheider, vor allem im Handwerk, noch Berührungsängste.

Autor: Matthias Aumann unterstützt seit 2017 mit seiner digitalen Unternehmensberatung Mission Mittelstand kleine und mittelständische Unternehmen in den Bereichen Strategie, Digitalisierung, Neukundengewinnung und Recruiting.

Eine Studie[1] der Bitkom in Zusammenarbeit mit dem Zentralverband des Deutschen Handwerks hat die größten Hemmnisse für die Digitalisierung im Handwerk offengelegt. Mit 76 Prozent sehen die meisten Unternehmen die vermeintlich hohen Investitionskosten als größte Hürde auf dem Weg zur Digitalisierung. Darauf folgen die Sorge um die IT-Sicherheit, hohe Anforderungen an den Datenschutz und die mangelnde Digitalkompetenz der Mitarbeiter. Zudem gibt es noch immer eine große Hemmschwelle, wenn es um das Thema Digitalisierung im Allgemeinen geht.

Diese Herausforderungen können mit dem richtigen Know-how und einer nachhaltigen Strategie gut überwunden werden.

Schrittweise Annäherung an digitale Prozesse

Die Philosophie von Mission Mittelstand „Groß denken, klein handeln“ spiegelt sich in unserem Beratungsansatz wider. Eine Geschäftsführung sollte eine klare Vision der eigenen digitalen Zukunft haben, muss aber nicht alles gleichzeitig umsetzen. Erst, wenn wir den Ist- und den Soll-Zustand definiert haben, können wir effizient an der Transformation arbeiten. Unternehmer sollten sich deshalb im Vorfeld die Frage stellen: Welche Unternehmensbereiche bieten das größte Potenzial für Digitalisierungsmaßnahmen? Die erste Hürde ist bereits genommen, wenn man sich digitalen Prozessen schrittweise annähert.

Doch wo liegen die größten Chancen für Unternehmen und wo können schnell erste Erfolge erzielt werden?

Quick Wins: Diese Unternehmensbereiche bieten das größte Potenzial

- Interne Kommunikation

- Marketing

- Buchhaltung

- Personalverwaltung

- Bewerbungsprozesse

Je nach Unternehmenssituation, -größe und -entwicklungsstufe sieht die Digitalisierungsstrategie anders aus. Denn es gibt vielfältige digitale Wege, um bestehende Schwachstellen zu verbessern, die nicht zu jedem Unternehmen passen. Liegt der Fokus auf der internen Kommunikation und dem Projektmanagement, sind Tools von der Stange ohne großen Implementierungsaufwand wie Slack oder Asana eine gute Wahl. Eine digitale Buchhaltung wirkt sich im besten Fall direkt positiv auf die Umsatzzahlen aus. Nur wer die Bearbeitung seiner Kundenrechnungen und auch das Forderungsmanagement automatisiert, bleibt liquide. Individuell empfehlen wir, über Schnittstellen ein CRM oder Tools wie Trello oder Sepia einzusetzen. Die Entscheidung für eine Digitalisierung der Personalverwaltung hängt stark von der Unternehmensgröße ab. Hier gilt es den Nutzen abzuwägen.

Marketingmaßnahmen und die Neukundengewinnung gehen oft Hand in Hand. Neue Möglichkeiten wie Social Media, Google Ads oder eigene Content Formate sollten getestet werden. Wir haben etwa mit Webinaren sehr gute Erfahrungen gemacht. Daraus resultieren direkte Leads für Neukunden und mögliche Funnel für eine weitere Ansprache.

Wenn die Expertise und die Kapazität für die digitale Transformation im eigenen Unternehmen fehlen, ist es ratsam und oft auch günstiger, externe Hilfe und Ressourcen heranzuziehen. Gemeinsam können die unternehmensspezifischen Schwachstellen und Wünsche mit der Erfahrung von Spezialisten kombiniert und in einen Maßnahmenplan umgesetzt werden.

Grundsätzlichen bilden folgende sechs Schritte branchenunabhängig die Basis für eine erfolgreiche Transformation:

- Bestehende Abläufe konkret dokumentieren

- Prozesse kritisch hinterfragen

- Neue Strategie aufsetzen

- Passende Tools auswählen

- Mitarbeiter schulen

- Neue Prozesse evaluieren und nachjustieren

Mit digitalgestütztem Recruiting gegen den Fachkräftemangel

Modernes Recruiting ist einer der wichtigsten Aspekte für dauerhaften Erfolg und Wachstum. Ohne genügend qualifizierte Mitarbeiter wird es auch trotz optimaler Unternehmensstrategie und guter Auftragslage eng. Gerade in Zeiten des Fachkräftemangels sind KMU gefordert, ihr Recruiting neu aufzustellen, um im „War for Talents“ nicht neben Konzernen unterzugehen. Das beginnt mit dem Auftreten als Arbeitgeber und geht über das Bewerbermanagement bis hin zum Onboarding neuer Mitarbeiter. Genau an dieser Stelle machen sich Unternehmen das Leben sehr viel leichter, wenn sie auf digitale Tools setzen, die sie bei diesen Aufgaben unterstützen.

Für ein erfolgreiches Recruiting sind zwei Schritte essentiell: Hürden abbauen und Bewerbungsprozesse effizient gestalten. Ein häufiger Fehler ist, dass Bewerbern die erste Ansprache unnötig erschwert wird. Die Zeiten für postalische Bewerbungen und komplizierte Vorgehensweisen sind auch für KMU schon lange vorbei. Unternehmen nutzen im besten Fall digitale Bewerber-Portale und Eingabeformulare. Noch niederschwelliger sammeln sie Bewerbungen auch über die Sozialen Medien oder verlinken zu einem Bewerbungsportal. Leichtere Bewerbungsprozesse bedeuten in den meisten Fällen mehr Bewerber. Mehr Bewerbungen und gute Recruitingabläufe sorgen für eine größere und bessere Auswahlmöglichkeit unter den Kandidaten – so können Unternehmen die passendsten Fachkräfte für ihr Unternehmen identifizieren. Je nach Unternehmenssituation und -größe raten wir zu einem softwaregestützten Bewerbermanagementsystem. Dazu gibt es digitale All-in-One-Lösungen, mit deren Hilfe Abläufe vereinfacht und zentralisiert werden. Denn sind erst einmal neue Mitarbeiter eingestellt, gibt es viele Folge-To-dos.

Konsequenterweise sollten Unternehmen auch digitale Hilfsmittel für das Onboarding einsetzen. Es eignen sich beispielsweise Softwarelösungen für eigene Wissensplattformen und digitale Learning-Tools. Dort stehen neuen Mitarbeitern Lernmaterialien und Schulungsvideos zur Verfügung und vermitteln grundlegendes Wissen für den Einstieg. Das Unternehmen stellt auf diese effektive Weise sicher, dass alle Mitarbeiter die gleichen Voraussetzungen haben. Ein gutes Onboarding ist auch deshalb so wichtig, weil es dafür sorgt, dass sich neue Mitarbeiter im Unternehmen wohl fühlen, sich mit der Unternehmensmission identifizieren und eine nachhaltige Bindung zum Arbeitgeber entwickeln.

Sichtbarkeit als Arbeitgeber

Viele KMU scheuen davor zurück, ihren Arbeitgeberauftritt digital auszuweiten, dabei ist genau das der Weg zu einer größeren Sichtbarkeit gegenüber dem Wettbewerber. Es geht zudem darum, noch stärker für das Berufsbild und die eigene Arbeitgebermarke zu werben und zu begeistern. Das Employer Branding über verschiedene Digitalkanäle, Jobportale, Anzeigen und auch die Unternehmenshomepage ist der geeignetste Weg, um direkte Botschaften auszusenden oder über Wissenslücken aufzuklären. Eine direkte Ansprache mithilfe eines digitalen Arbeitgeberauftritts hilft zudem, Vorbehalte oder Geschlechterklischees, wie sie zum Beispiel im Handwerk vorhanden sind, abzubauen. Das funktioniert auch mit einzelnen Ressourcen, wie beispielsweise über die Sozialen Medien. Geschäftsführer von KMU bedenken meist nicht, wie viel mehr sie erreichen können, wenn sie digitale Kanäle, wie zum Beispiel Instagram oder TikTok, nutzen – gerade für den Bereich Recruiting. Vielen unserer Partnerbetriebe empfehlen wir daher, sich mit dem Thema Social Media auseinanderzusetzen.

Digitalisierungsstrategien konsequent verfolgen

Nur wer seine Kernprozesse digitalisiert, wird mit seinem Unternehmen erfolgreich wachsen. Allein beim Thema Personalrekrutierung spürt man schnell die Auswirkungen einer guten digitalen Strategie. Unsere Erfahrung zeigt zudem: Digitalisierung beginnt bei der Geschäftsführung und der Vision für das eigene Unternehmen. Sie ist nicht nur ein technologisches, sondern auch ein kulturelles Thema. Die Einführung digitaler Tools erfordert eine Anpassung der Arbeitsprozesse und der Unternehmenskultur. Daher sollte die Geschäftsführung die Mitarbeiter auf diesem Weg mitnehmen und die Veränderungen transparent kommunizieren. Wenn die Geschäftsführung selbst von digitalen Werkzeugen überzeugt ist, sind Auswirkungen schnell für das gesamte Unternehmen spürbar. Für KMU in der Wachstumsphase ist es mitunter schwierig zu entscheiden, wohin sie weiter investieren sollen. Ein Geschäftsführer mit Weitblick sucht die strategische Beratung, um die wichtigsten Digitalisierungschancen zu identifizieren und den Transformationsprozess erfolgreich zu starten.

[1]https://de.statista.com/statistik/daten/studie/681897/umfrage/hemmnisse-fuer-die-digitalisierung-im-handwerk-in-deutschland/

Über den Autor:

Matthias Aumann unterstützt seit 2017 mit seiner digitalen Unternehmensberatung Mission Mittelstand kleine und mittelständische Unternehmen in den Bereichen Strategie, Digitalisierung, Neukundengewinnung und Recruiting. Als erfolgreicher und leidenschaftlicher Unternehmer gibt er Praxiswissen auf Augenhöhe weiter.

Namensnennung-Keine Bearbeitung 3.0 Deutschland (CC BY-ND 3.0 DE)

https://creativecommons.org/licenses/by-nd/3.0/de/

Open-Source vs. Proprietäre Software

/in Allgemein, Creative Commons CC BY-ND, Digitalisierung, Expertenpanel, Freie Inhalte, Open Source, Specials/von Martina Bartlett-MattisChance zur Fachkräftegewinnung und -sicherung

/in Allgemein, New Work, Reportagen, Unternehmen & Märkte, Wissenskultur/von Daniela HaselbauerZukunftsorientierte Unternehmen vermitteln Azubis Digitalkompetenzen