Ein Baustein von Industrie 4.0 sind Assistenzsysteme

Um die Smart Factory Wirklichkeit werden zu lassen, sind digitale Assistenzsysteme für die Fertigung unabdingbar geworden.

von Dipl.- Ing. (FH) Johann Hofmann

Es braucht Erfindungsgeist und Ausdauer, wenn Visionen wahr werden sollen. Die Realisierung der Vision der Hochleistungsfertigung der Zukunft ist dafür ein hervorragendes Beispiel: Das Assistenzsystem ValueFacturing® entstand in langjähriger Detailarbeit in der firmeneigenen zerspanenden Fertigung der Maschinenfabrik Rheinhausen und realisiert die digitale Transformation auf dem Weg zur digitalen Hochleistungsfertigung ganz im Sinne einer Smart Factory.

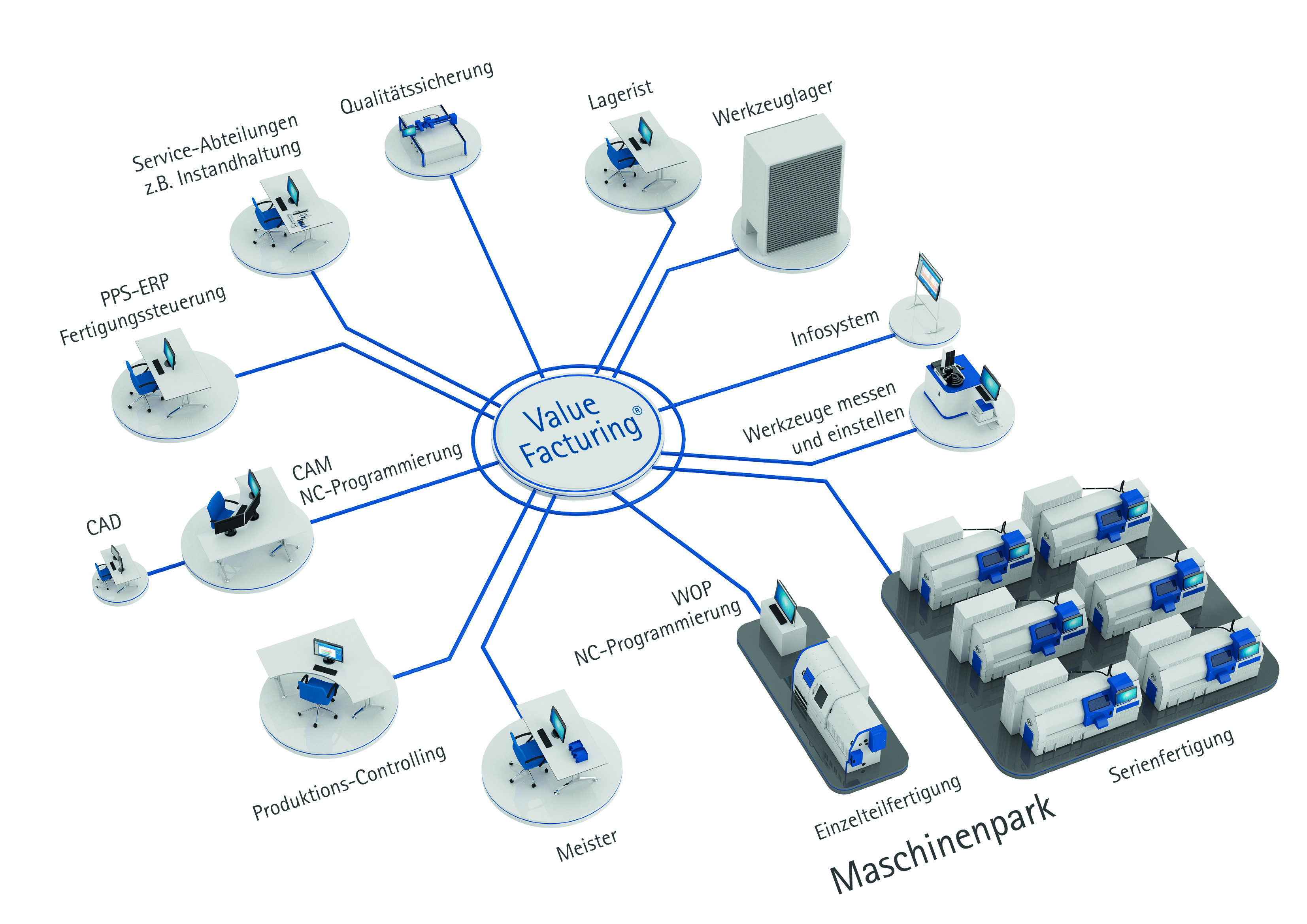

Das System vernetzt alle am Fertigungsprozess beteiligten Anlagen, Systeme und Personen. So leitet es beispielsweise Mitarbeiter bei ihrer Arbeit an, ermöglicht smarte Prozesse und befähigt zu besseren Entscheidungen.

Dafür werden einzelne Arbeitsgänge aus dem vom ERP-System ausgelösten Fertigungsauftrag direkt vom Assistenzsystem übernommen und bis zur Rückmeldung digital begleitet und gesteuert. Gleichzeitig erfolgt eine Rückmeldung über die verschiedenen Teilschritte aus der Produktion an das ERP-System. Damit wurde die Basis für ein Internet der Dinge in der Fertigung geschaffen. Physische Objekte wie Werkzeuge werden dank Cloud-Lösungen mit einer virtuellen Repräsentation in einer Internet-ähnlichen Struktur abgebildet.

Herzstück des Assistenzsystems ist die bidirektionale Online-Kommunikation in Echtzeit mit allen am Fertigungsprozess beteiligten Akteuren und der Fähigkeit, Informationen intelligent anzureichern. Das Assistenzsystem bietet neue innovative Features, die eine signifikante Rüstzeitenreduzierung und somit höhere Maschinennutzung ermöglichen. Mit ValueFacturing® gewinnen alle Prozessbeteiligten des Shopfloors mehr Transparenz über den aktuellen Stand ihrer Fertigung. Das Assistenzsystem unterstützt sie smart bei der Ausführung ihrer täglichen Aufgaben.

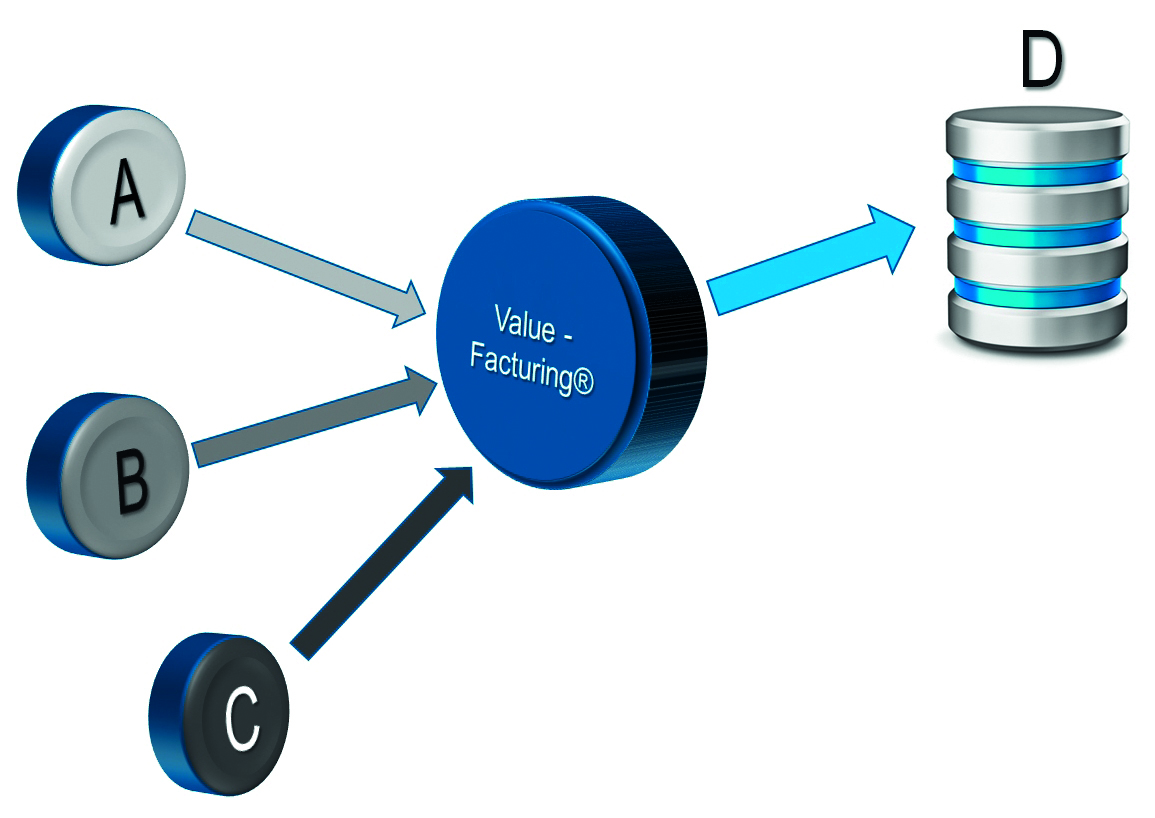

Der größte Vorteil allerdings ist die Fähigkeit der Datenanreicherung. Hierbei werden situationsabhängig neue Daten generiert. Zum Beispiel werden Fahrbefehle für Werkzeugeinstellgeräte beliebiger Hersteller und unterschiedlichster Softwarestände „just in time“ erzeugt. Hierbei werden vom Assistenzsystem von verschiedenen Systemen (A, B und C) vorhandene Daten für einen anfragenden Akteur (D) abgeholt. Durch intelligente Verknüpfung dieser Daten inklusive umfangreicher Berechnungslogik werden im Ergebnis neue, für einen effizienten Workflow erforderliche Daten erzeugt (Bild 3).

Dieser Effekt wird auch im folgenden ZVEI- Positionspapier, das zur Hannover Messe 2017 veröffentlicht wurde, beschrieben:

„Industrie 4.0 und MES – Voraussetzung für das digitale Betriebs- und Produktionsmanagement – Aufgabenstellungen und künftige Anforderungen“

|

|

A = beliebiges ERP-System |

Im Kapitel 3.3.5.4 „Dynamisches Ausführungsmanagement“ ist dort die Flexibilisierung betrieblicher Abläufe als wichtiger Bestandteil im digitalen Rüst-Workflow beschrieben. Die Umstellung von althergebrachten starren Abläufen in dynamische Abläufe ist Bestandteil der Digitalisierungsstrategie von Industrie 4.0. Als „starr“ bezeichnet man alle Systeme, deren Abläufe durch Vorbedingungen festgelegt sind. Als „dynamisch“ bezeichnet man alle Systeme, die ihre Vorbedingungen automatisch an eine neue Situation anpassen können.

Das Verfahren der dynamischen Datenanreicherung erfordert umfangreiches Wissen aus der jeweiligen fachspezifischen Domäne. Im Fall der Maschinenfabrik Reinhausen ist das die zerspanende Fertigung. Jahrzehntelang angesammeltes Know-how ist Kernbestandteil der dynamischen Datenanreicherung mit ValueFacturing®. Das erspart z. B. dem Mitarbeiter am Einstellgerät tagtäglich viel Zeit. Noch viel wertvoller ist allerdings der „Poka-Yoke“-Effekt (dt. „unglückliche Fehler vermeiden“), der dadurch ermöglicht wird, dass das fehlerträchtige Eintippen von starren Daten entfällt. Dieses dynamische Erzeugen der Daten ermöglicht auch jederzeit, den anfragenden Akteur (D) im Bild 2 auszutauschen oder durch Updates zu erweitern, denn die benötigten Daten werden immer passend für ihn „just in time“ automatisch neu generiert.

| Hintergrund |

| Die Maschinenfabrik Reinhausen GmbH (MR) ist weltweit führender Anbieter (ca. 50 Prozent Weltmarktanteil) von Laststufenschaltern für die Hochspannungstechnik. Das in Regensburg ansässige und weltweit tätige mittelständische Unternehmen erwirtschaftete im vergangenen Geschäftsjahr mit 3 550 Mitarbeitern und 49 Tochter- und Beteiligungsgesellschaften einen Umsatz von 750 Millionen Euro.

Seit Jahrzehnten zählt für die MR eine große Fertigungstiefe in Deutschland zu den bedeutenden Wettbewerbsvorteilen. Dabei hat sich die MR seit knapp 30 Jahren dem Ziel eines intelligenten Fertigungsflusses verschrieben – mit großem Erfolg. In der firmeneigenen zerspanenden Fertigung wurde in jahrzehntelanger Detailarbeit das Assistenzsystem ValueFacturing® mit richtungsweisenden Funktionen entwickelt. Der Nutzen dieser Lösung wirkt in den Wertschöpfungsketten im Zentrum der deutschen Produktionsindustrie und ist ein bedeutender Baustein von Industrie 4.0. Mit ValueFacturing® können vor allem die wirtschaftliche Fertigung der Losgröße 1, die Beherrschung von beliebiger Varianz und die Verkürzung der Lieferzeit signifikant und nachhaltig verbessert werden. |

State of the Art

Modernste Server-, Web- und Cloud-Technologien sichern die Systemverfügbarkeit und gewährleisten gleichzeitig maximale IT-Sicherheit. Durch Einsatz von ValueFacturing® auf Basis der Microsoft Azure Cloud lässt sich ein Rollout auf weitere Unternehmensstandorte weltweit bequem realisieren. Der Einsatz von ValueFacturing® in Verbindung mit Smart Devices ermöglicht Management und Mitarbeitern den Live-Blick in die Fertigung – und das weltweit. Das Internet of Things (IoT) wird so erlebbar. Die Benutzerverwaltung von ValueFacturing® ist mit einem umfangreichen Rechtesystem versehen und lässt eine gezielte Steuerung der zulässigen Aktivitäten je Mitarbeiter zu und erhöht so die Sicherheit. Umfangreiche Health-Checks zur effizienten Überprüfung des Systemzustandes in Realtime vereinfachen die Administration.

Data Mining mit ValueFacturing macht Big Data zu Smart Data

Das Sammeln von Echtzeit-Daten ermöglicht kennzahlenorientiertes Managen im Shopfloor. Um aus den tagesaktuellen Shopfloor-Daten Verbesserungen ableiten zu können, wird das Analytics-Portfolio von ValueFacturing® stetig ergänzt. Das Herausfiltern einzelner wichtiger Informationen aus diesen großen Datenmengen wird als „Data Mining“ oder Mustererkennung bezeichnet. Dazu werden Massendaten (Big Data) mit Datenanalyse- und Entdeckungsalgorithmen durchsucht mit dem Ziel, neue Muster, Querverbindungen und Trends zu erkennen.

Z.B. die Berechnung des Stückzählers durch ValueFacturing® erfordert Mustererkennungsmethoden und ist ein Meilenstein in der Maschinendatenerfassung (MDE). Dadurch werden die Rohdaten zu Smart Data, die neuen Erkenntnisgewinn bringen. Um Fehlinterpretationen weitestgehend zu vermeiden, müssen die Entdeckungsalgorithmen Ausreißer und manipulierte Daten erkennen und aus der Bewertung entfernen.

Schritt für Schritt werden so die „Enabler“ von Industrie 4.0 aus Bild 1 Realität. //

Autorenvita: Dipl.- Ing. (FH) Johann Hofmann

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…

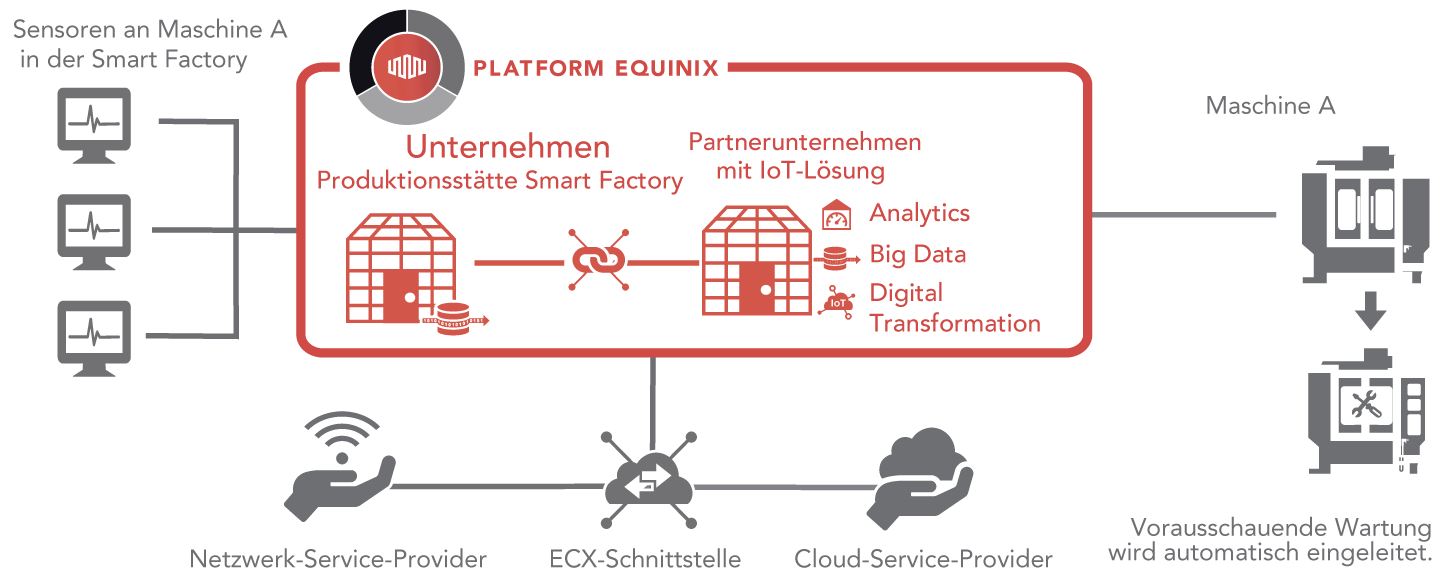

Für die in vielen Branchen übliche Nutzung des „Internet of Things“ (IoT) gibt es einen ausschlaggebenden Grund: Mit den gewonnenen Daten können Prozesse und Betriebsabläufe genauer gesteuert und die Auslastung kann effizienter geregelt werden. Hier fällt ein hohes Volumen relativ kleiner Datensätze an, wie sie von Sensoren erfasst und weitergemeldet werden. Doch neben der Herausforderung, große Mengen anfallender Daten zu verarbeiten und daraus Schlüsse zu ziehen, gilt es beim IoT weitere Hürden zu meistern. Denn um auf Echtzeit-Analysen basierende Entscheidungen zu treffen, sind vor allem die Geschwindigkeit der Datenverarbeitung und die Sicherheit der Datenübertragung von entscheidender Bedeutung. Smarte Sensoren und IoT-Geräte unterscheiden sich sowohl in ihrem Einsatzzweck als auch in der Vielschichtigkeit der von ihnen erhobenen Daten. Die verschiedenen Daten zu analysieren, um daraus Erkenntnisse abzuleiten, ist beim Einsatz des IoT ebenso eine Herausforderung wie die Einhaltung von Governance-Richtlinien bei der Datenverarbeitung.

Für die in vielen Branchen übliche Nutzung des „Internet of Things“ (IoT) gibt es einen ausschlaggebenden Grund: Mit den gewonnenen Daten können Prozesse und Betriebsabläufe genauer gesteuert und die Auslastung kann effizienter geregelt werden. Hier fällt ein hohes Volumen relativ kleiner Datensätze an, wie sie von Sensoren erfasst und weitergemeldet werden. Doch neben der Herausforderung, große Mengen anfallender Daten zu verarbeiten und daraus Schlüsse zu ziehen, gilt es beim IoT weitere Hürden zu meistern. Denn um auf Echtzeit-Analysen basierende Entscheidungen zu treffen, sind vor allem die Geschwindigkeit der Datenverarbeitung und die Sicherheit der Datenübertragung von entscheidender Bedeutung. Smarte Sensoren und IoT-Geräte unterscheiden sich sowohl in ihrem Einsatzzweck als auch in der Vielschichtigkeit der von ihnen erhobenen Daten. Die verschiedenen Daten zu analysieren, um daraus Erkenntnisse abzuleiten, ist beim Einsatz des IoT ebenso eine Herausforderung wie die Einhaltung von Governance-Richtlinien bei der Datenverarbeitung. Die Art und Weise, wie Menschen miteinander kommunizieren, unterliegt seit jeher stetiger Veränderung. Von der Entwicklung der Sprache über die Schrift hin zu Technologien wie dem Telegramm oder der Telekommunikation haben wir stets neue Wege gefunden, den Informationsaustausch zu vereinfachen und zu beschleunigen. Mit dem Eintritt ins digitale Zeitalter und vor allem dank des Internets konnte einer der bisher größten Meilensteine in der zwischenmenschlichen Kommunikation errungen werden: die Übertragung von Informationen in Echtzeit.

Die Art und Weise, wie Menschen miteinander kommunizieren, unterliegt seit jeher stetiger Veränderung. Von der Entwicklung der Sprache über die Schrift hin zu Technologien wie dem Telegramm oder der Telekommunikation haben wir stets neue Wege gefunden, den Informationsaustausch zu vereinfachen und zu beschleunigen. Mit dem Eintritt ins digitale Zeitalter und vor allem dank des Internets konnte einer der bisher größten Meilensteine in der zwischenmenschlichen Kommunikation errungen werden: die Übertragung von Informationen in Echtzeit.