Mit KI die „Sustainable Development Goals“ quantifizieren

Durch die automatisierte Auswertung von Satellitenbilddaten mittels Deep-Learning-Algorithmen den Zustand der Erde bestimmen

von Benjamin Bischke und Patrick Helber

Die Zusammenhänge und Wechselwirkungen in unserer Welt werden zunehmend komplexer und undurchsichtiger. Täglich generieren unzählige Sensoren und smarte Internet-of-Things(IoT)-Geräte immense Datenmengen. Eine korrekte Analyse dieser Daten trägt maßgeblich dazu bei, die Welt besser zu verstehen, und eröffnet in zahlreichen Branchen Möglichkeiten zur Umsetzung neuer Anwendungen und Optimierung bestehender Prozesse.

Bis vor wenigen Jahren war es äußerst schwierig, dieses riesige Volumen an Daten im Detail zu verstehen und neue Lösungsansätze basierend auf diesen Daten umzusetzen. Der Durchbruch der künstlichen Intelligenz (KI) im Kontext der Digitalisierung als Schlüsseltechnologie hat dies jedoch grundlegend verändert. Algorithmen aus dem Gebiet des maschinellen Lernens erlauben es, riesige Datenmengen innerhalb kürzester Zeit zu analysieren, Muster und Zusammenhänge aus den Daten zu extrahieren und basierend darauf schnellere und genauere Entscheidungen für die Zukunft treffen zu können.

Die künstliche Intelligenz nimmt immens an Bedeutung zu

Ob künstliche Intelligenz, maschinelles Lernen oder Deep Learning, in der Praxis werden diese Begriffe häufig als Synonyme verwendet. Dabei besitzen die drei Begrifflichkeiten große Unterschiede in ihrer Bedeutung und stehen in einer strikten Hierarchie zueinander. Die künstliche Intelligenz ist der Oberbegriff für alle Methoden und Technologien, die ein intelligentes Verhalten vorweisen. Das maschinelle Lernen ist dabei ein Teilgebiet der KI, welches eine Vielzahl an (Lern-)Methoden basierend auf der mathematischen Optimierung und Statistik umfasst. Deep Learning wiederum ist ein spezieller Teilbereich des maschinellen Lernens, der versucht, die statistischen Korrelationen in den Daten durch künstliche neuronale Netze abzubilden.

In der Fachliteratur teilt man die Methoden der KI in zwei Teilbereiche auf:

Die symbolische KI und die statistische KI.

- Bei der symbolischen KI werden zunächst Fakten, Ereignisse und ihre Zusammenhänge gesammelt und als ein abstraktes Modell in einer eindeutigen Repräsentation dargestellt. Basierend auf dieser Repräsentation können mathematische Operationen definiert werden, die es erlauben, logische Schlussfolgerungen zu ziehen oder komplexere Vorgänge zu planen. Nachteilig bei einem solchen Ansatz ist jedoch, dass zunächst eine möglichst vollständige Wissensbasis erstellt werden muss, was in der Praxis häufig sehr zeitintensiv und fehleranfällig ist. Darüber hinaus sind die entsprechenden Algorithmen in ihren Entscheidungen häufig durch das vorab definierte Regelwerk begrenzt und können nur sehr schwer mit einer Unsicherheit in den Daten umgehen.

- Im Gegensatz dazu steht die statistische KI, bei der versucht wird, intelligentes Verhalten mittels mathematischer Modelle und statistischer Verfahren (wie beispielsweise mit neuronalen Netzen) nachzubilden. Diese statistischen Lernverfahren extrahieren latente Strukturen und Korrelation in den Daten und bilden dieses Wissen in einem mathematischen Modell ab. Anschließend lassen sich mit dem gelernten Modell auf ähnliche Daten neue Entscheidungen sowie Vorhersagen über die Zukunft treffen.

In diesem Kontext ist das maschinelle Lernen (ML) als eines der wichtigsten und nutzbringendsten Teilgebiete der statistischen KI besonders hervorzuheben. Gerade im Zuge der Digitalisierung steht das maschinelle Lernen bei vielen Unternehmen im Fokus der Aufmerksamkeit, um sich einen Vorsprung gegenüber den Wettbewerbern zu sichern.

Die Anwendungen von maschinellen Verfahren sind vielschichtig und branchenübergreifend für zahlreiche Unternehmen relevant: So können beispielsweise im Bereich der Medizin mithilfe maschineller Lernverfahren die Wechselwirkungen mehrerer Medikamente vorhergesagt werden. Im Rahmen der Wirtschaftsprüfung können mithilfe des maschinellen Lernens komplexe Geschäftsprozesse aus Millionen von undurchsichtigen Transaktionsdaten gelernt werden. Dies erlaubt es, Anomalien, die beispielsweise im Zusammenhang mit der Wirtschaftskriminalität stehen, automatisiert zu identifizieren.

„Die künstliche Intelligenz ist der Oberbegriff für alle Methoden und Technologien, die ein intelligentes Verhalten vorweisen.“

Die Verfahren des maschinellen Lernens bauen auf mathematischen Theorien auf, wobei insbesondere die Gebiete der Optimierung und Statistik zur Anwendung kommen. Dabei verarbeiten die Verfahren die Eingabedaten und erstellen je nach Anwendung ein spezifisches mathematisches Modell. Das Finden der besten Parameter für das entsprechende Modell nennt man in der Fachsprache das Trainieren oder Lernen eines Modells. Mithilfe der gelernten Modelle lassen sich dann Wahrscheinlichkeiten für zukünftige Ereignisse berechnen oder riesige Datenmengen auf relevante Informationen reduzieren und hinsichtlich bedeutender Eigenschaften gruppieren.

Großes Momentum im maschinellen Lernen durch Deep Learning

Ein Teilbereich des maschinellen Lernens ist Deep Learning, das besonders im Fokus rund um die aktuelle Hochphase der KI steht. Bei Deep Learning wird versucht, das menschliche Gehirn in einem vereinfachten mathematischen Modell mittels künstlicher neuronaler Netze abzubilden. Abstrakt betrachtet stellt Deep Learning hierfür ein sehr mächtiges Framework bereit, mit dem neuronale Netze mit unterschiedlichen Architekturen trainiert werden können. Diese Netze sind in der Lage, entscheidende Merkmale, die für die Lösung eines Problems relevant sind, automatisch aus den Daten zu lernen. Im Gegensatz zu klassischen Verfahren des maschinellen Lernens, bei denen die Merkmale von dem Menschen aufwendig entworfen und definiert werden müssen, lernen die neuronalen Netze selbstständig die Korrelationen und Merkmale aus den Daten.

„Heutzutage nehmen Satelliten eine riesige Datenmenge an Bildern pro Tag auf, welche in der Praxis händisch nicht auszuwerten sind.“

Mathematisch kann gezeigt werden, dass die neuronalen Netze eine

beliebige mathematische Funktion abbilden können. Zur Lösung komplexer

und nicht linearer Problemstellungen werden jedoch Netzwerke mit

besonders vielen Schichten aus Neuronen (und somit ein tiefschichtiges

Netzwerk) benötigt, woher auch der Begriff des „Deep Learnings“

resultiert. Diese vielschichtigen Netzwerke erlauben es zwar, komplexe

Probleme näherungsweise besser zu lösen, gleichzeitig erfordert ein

solcher Ansatz aber auch eine besonders hohe Anzahl an freien

Parametern, die durch ein aufwendiges Training bestimmt werden müssen.

Das eigentliche Training ist ein nicht konvexes Optimierungsproblem, bei

dem die Netzwerkparameter näherungsweise bestimmt werden müssen.

Aufgrund der hohen Parameteranzahl werden hierfür zwei wichtige Voraussetzungen benötigt:

- eine strukturierte, repräsentative Datenbasis mit Labels und

- eine leistungsstarke Rechenkraft.

Durch die Vielzahl an Sensoren und die Verfügbarkeit von Ressourcen über das Internet ist der erste Punkt mittlerweile oftmals einfach zu erfüllen. Bei der Rechenpower wurden ursprünglich Grafikkarten zweckentfremdet, um die mathematischen Operationen schneller zu berechnen als durch herkömmliche „Central Processing Unit“(CPU)-Prozessoren. Aktuell bieten führende Grafikkartenhersteller wie Nvidia dedizierte Prozessorchips an, die sich auf die mathematischen Operationen des Deep Learnings spezialisiert haben und es erlauben, Tausende von Operationen zu parallelisieren. Durch die Supercomputer von Nvidia wie die DGX-1- und DGX-2-Systeme(1) lassen sich neuronale Netze mittlerweile innerhalb von wenigen Minuten trainieren. Bis vor wenigen Jahren wurden hierfür mehrere Wochen oder gar Monate benötigt.

Deep Learning in der Erdbeobachtung für die „Sustainable Development Goals“

Die Vereinten Nationen (UN) haben im Jahr 2012 auf der Rio+20-Konferenz Ziele für die nachhaltige Entwicklung unserer Welt festgelegt. Im Rahmen dieser Agenda wurden 17 Zielsetzungen für eine nachhaltige ökonomische, soziale und ökologische Entwicklung bestimmt. Diese nachhaltige Zielsetzung ist unter dem Namen „Sustainable Development Goals“ (SDGs) wie auch unter dem Namen Agenda 2030 oder Weltzukunftsvertrag bekannt und ist am 1. Januar 2016 mit einer geplanten Umsetzung bis zum Jahre 2030 in Kraft getreten(2). Im Rahmen dieser Agenda finden sich Ziele, wie die Ernährung für die gesamte Weltbevölkerung nachhaltig zu sichern sowie eine nachhaltige Städte- und Siedlungsentwicklung voranzutreiben.

Eine mögliche Hilfe bei der Erreichung dieser Nachhaltigkeitsziele bieten Erdbeobachtungsdaten insbesondere in Form von Luft- und Satellitenbildern. Durch die Auswertung dieser Daten können Aussagen über die Bestellung von landwirtschaftlichen Feldern oder auch über das aktuelle Lagebild nach einer Naturkatastrophe getroffen werden. Der starke Anstieg an verfügbaren Erdbeobachtungsdaten, insbesondere durch Luft- und Satellitenbilddaten, ermöglicht eine niemals zuvor mögliche Analyse der Erde.

Heutzutage nehmen Satelliten eine riesige Datenmenge an Bildern pro Tag auf, welche in der Praxis händisch nicht auszuwerten sind. Die erzeugten Daten sowie der Fortschritt auf dem Gebiet der künstlichen Intelligenz erlauben die Entwicklung einer automatisierten Lösung. Dabei kann eine lokale Auswertung einzelner z. B. von einer Naturkatastrophe betroffener Gebiete sowie eine detaillierte globale Analyse des Zustands der Erde vorgenommen werden. Die so entwickelte künstliche Intelligenz kann als Grundpfeiler für eine global automatisierte Erdbeobachtungslösung dienen und somit zur Erreichung der von den Vereinten Nationen bestimmten Nachhaltigkeitsziele maßgeblich beitragen. Ein Beispiel hierfür ist die Auswertung von Erdbeobachtungsdaten vor und nach dem Eintreten von Naturkatastrophen.

Deep Learning im Rahmen des Katastrophenschutzes

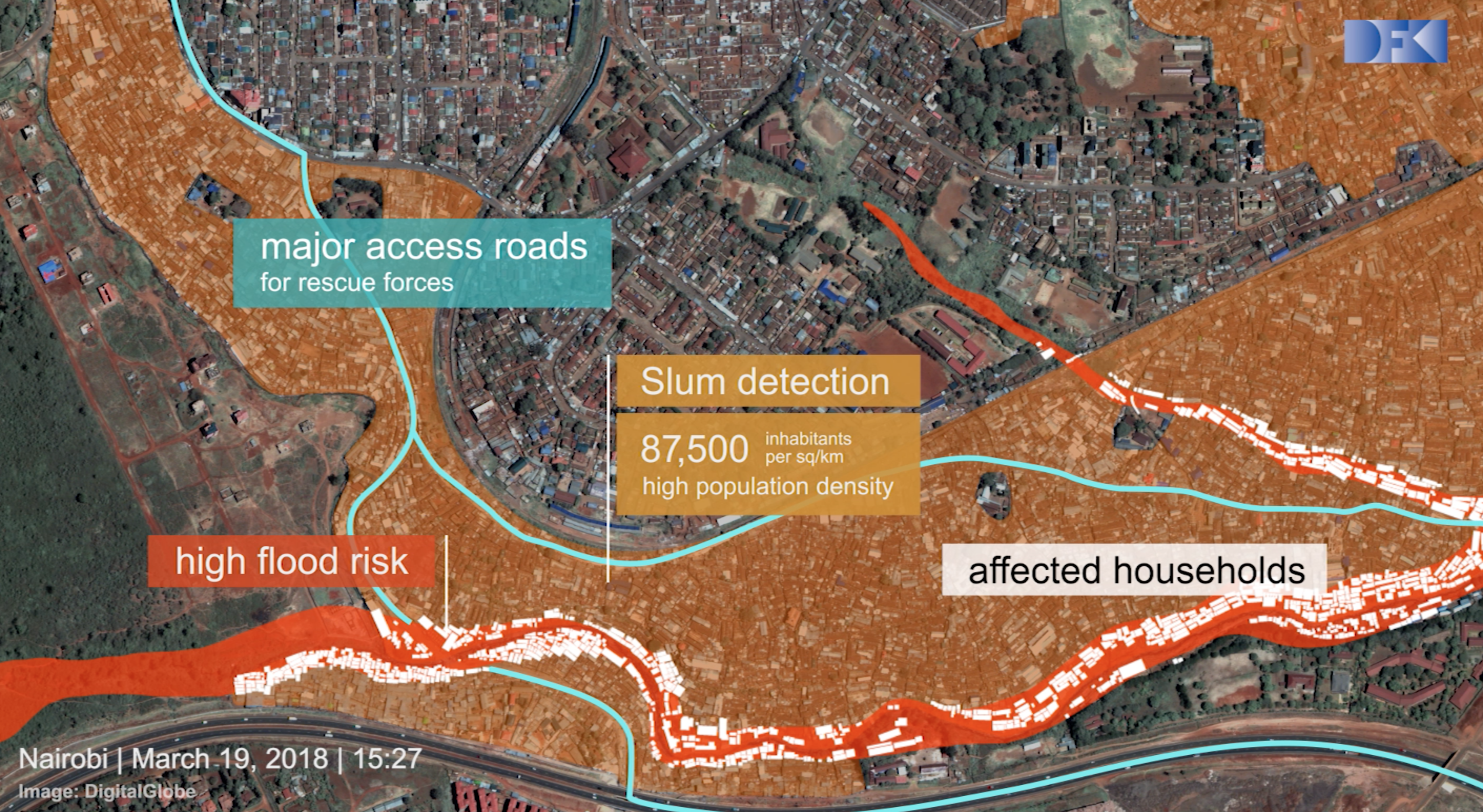

Das Deutsche Forschungszentrum für künstliche Intelligenz (DFKI) hat sich seit 2016 mit dem Start des Forschungsprojekts „Deep Eye“ insbesondere der Analyse von Naturkatastrophen mittels Satellitenbilder unter der Zielsetzung „AI for Good“ beschäftigt(3). Derzeit werden Aufnahmen vor und nach Katastrophen zwar computergestützt, jedoch manuell ausgewertet. Eine vollständig automatisierte Verarbeitung der Satellitenbilddaten gestützt durch Methoden der künstlichen Intelligenz hilft, entsprechende Bilder effektiver und effizienter auszuwerten und somit schneller im Falle einer Naturkatastrophe zu agieren. Im Mittelpunkt des DFKI-Projekts „Deep Eye“ steht die Verbesserung der im Notfall verfügbaren Ressourcen.

Das Forscherteam entwickelte mehrere Systeme, wie zum Beispiel „Deep Eye“, um Satellitenbilder mit tiefen neuronalen Netzwerken zu analysieren(4). Ziel dieser Systeme ist es, Schäden sowie Überschwemmungsflächen automatisch zu erkennen, die Auswirkungen des Überschwemmungsgebietes zu quantifizieren und die Zugänglichkeit der Infrastruktur während der Naturkatastrophen hervorzuheben.

Das Deutsche Forschungszentrum für künstliche Intelligenz (DFKI) hat zur Umsetzung dieser Zielsetzung die Ausgründung Vision Impulse(5) ins Leben gerufen. Der Fokus des DFKI-Spin-offs liegt auf der automatisierten Analyse von Luft- und Satellitenbilddaten mittels Deep Learning. Neben der effektiven Schadenskalkulation nach dem Eintreten einer Naturkatastrophe haben die zukunftsweisenden Technologien der Ausgründung das Potenzial, Unternehmen bei dem Erreichen ihrer Nachhaltigkeitsziele zu unterstützen. //

Autorenvitae

|

|

| Benjamin Bischke | Patrick Helber |

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…