Voll vernetzt für mehr Transparenz und Effizienz

Sensorik bildet die Basis für das Internet der Dinge und Industrie 4.0.

Sensorik bildet die Basis für das Internet der Dinge und Industrie 4.0.

Daten gehören zum wertvollsten Kapital eines Unternehmens. Durch die Integration neuer Technologien werden diese Daten nutzbar gemacht.

von Francis Cepero

Lange war es nur erfahrenen Data Scientists vorbehalten, künstliche Intelligenz und Machine Learning zur Lösung komplexer Aufgaben zu nutzen. Seit einigen Jahren ist nun eine Trendwende hin zur Anwendung in der breiten Masse zu beobachten. Künstliche Intelligenz (KI) und Machine Learning (ML) sind in unserem Alltag angekommen.

Lange war es nur erfahrenen Data Scientists vorbehalten, künstliche Intelligenz und Machine Learning zur Lösung komplexer Aufgaben zu nutzen. Seit einigen Jahren ist nun eine Trendwende hin zur Anwendung in der breiten Masse zu beobachten. Künstliche Intelligenz (KI) und Machine Learning (ML) sind in unserem Alltag angekommen.

Die Durchbrüche bei Sprach- und Bilderkennung, maschineller Übersetzung oder autonomem Fahren sind darauf zurückzuführen. Für den breiten Einsatz im Mainstream gibt es zwei Gründe:

Die zur Verfügung stehende Technik ist benutzerfreundlicher, leistungsfähiger und günstiger denn je.

Es ist erheblich einfacher geworden, Daten für die KI zu sammeln. Auch in KMU fallen genügend verwertbare Informationen an, um ein ML-Projekt zu starten.

Laut einer Untersuchung von Crisp Research über Machine Learning im Unternehmenseinsatz aus dem Jahr 2017 beschäftigen sich über 63 Prozent der befragten Unternehmen damit. 72 Prozent davon setzen schon konkrete Projekte um oder haben erste Erfahrungen mit Prototypen gesammelt.

Klassifizierung: Ist ein Objekt dieses oder jenes? Ähnlich wie Aschenputtel durchforstet KI Datensätze anhand bestimmter Fragestellungen: Ist auf dem Bild Produkt A oder Produkt B zu sehen? Ist diese E-Mail Spam? Hat dieses Produkt einen Defekt?

Vorhersagen: Welcher numerische Wert kommt in einer Sequenz als nächster?

Ein Beispiel ist die Prognose des Absatzes für ein Produkt, basierend auf Daten wie bisherigen Verkaufszahlen, Verbraucherstimmung oder auch Wetter. Untersucht wird, wann und mit welcher Wahrscheinlichkeit ein Ereignis eintritt.

Clustering: Was gehört zusammen?

Dateninstanzen mit gemeinsamen oder ähnlichen Merkmalen werden zusammengruppiert. Dies findet u. a. Anwendung in der Marktforschung. Anhand demografischer Daten, Präferenzen und Kaufverhalten lassen sich gut abgegrenzte Konsumentengruppen bilden.

Korrelation: Welche Ereignisse treten zusammen auf?

Es geht darum, Zusammenhänge als Korrelationen (wenn das, dann dies) und nicht als Kausalität (dies verursacht das) zu erkennen. Zum Beispiel: Ein kritischer Systemzustand wird immer dann erreicht, wenn bestimmte Parameter (Temperatur, Druck) eine gewisse Schwelle überschreiten. Die genaue Art der Beziehung zwischen beiden Ereignissen muss der Mensch interpretieren. Ein häufiger Fehler ist hier die Verwechslung von Korrelation mit Kausalität. Bei der Kausalität ist Ereignis A die Ursache für Ereignis B. Dies ist bei Korrelationen nicht zwangsläufig gegeben. Ein Beispiel für diesen typischen Fehler: Die Mehrzahl der Bevölkerung stirbt im Bett. Sollte man deshalb lieber nicht schlafen gehen?

Optimierungen: Welches ist die beste Lösung für eine Aufgabe?

KI optimiert die Ergebnisse für eine bestimmte Zielfunktion. Ein gängiges Beispiel ist die Planung einer Route, die Zeit und Kraftstoffverbrauch optimal vereint.

Anomalie-Erkennung: Was passt nicht?

Mit dieser Unterkategorie der Klassifizierung lässt sich herausfinden, welche Daten eines bestimmten Satzes außergewöhnlich sind. Ein Beispiel aus der Praxis: Sie trainieren ein System auf die Vibrationswerte einer Maschine. Bei der kontinuierlichen Überwachung wird bei neuen Werten deutlich, ob die Maschine noch normal arbeitet oder nicht.

Ranking: Gibt es Empfehlungen?

Basierend auf Trainingsdaten werden Handlungsvorschläge entwickelt. Klassisches Beispiel sind Systeme, die einem Kunden Produkte vorschlagen, die er basierend auf seinem Kaufverhalten und verwandten Personengruppen als nächstes kaufen könnte.

| Kernaussagen |

|

|

|

Die vorausschauende Instandhaltung kombiniert Anomalie-Erkennung, Korrelation und Vorhersagen: Wann tritt eine Anomalie auf? Wann wird dies wieder passieren? Wie oft tritt sie wieder auf, bis sie sich negativ auf den Betriebszustand der Maschine auswirkt? Dafür nutzt ein ML-System die Daten mehrerer IoT-Sensoren, die zur Überwachung relevanter Parameter wie Temperatur oder Vibration verbaut wurden. Diese und andere Daten (etwa von Mikrofonen oder Kameras) können mittels Deep Learning schnell analysiert werden. Das ermöglicht die bessere Planung von Wartungsarbeiten und die Reduzierung von Personalkosten und Ausfallzeiten. So sind Einsparungen von ein bis zwei Prozent des Gesamtumsatzes möglich.

ML kann beispielsweise die Routenplanung optimieren, was den Kraftstoffverbrauch reduziert und die Lieferzeiten verkürzt. Sensoren, die Fahrzeugleistung und Fahrerverhalten überwachen, geben den Fahrern Echtzeit-Feedback. Etwa, wann Bremsen oder Beschleunigen sinnvoll wäre, um kraftstoffoptimiert zu fahren. Dies reduziert zudem die Wartungskosten der gesamten Flotte. Ein europäisches Transportunternehmen hat so seine Treibstoffkosten um 15 Prozent gesenkt.

| Einfach anfangen – egal wie! | |

| 1. | Sprechen Sie mit Experten. Diese wissen aufgrund ihrer Erfahrung sehr gut, wo sich ML in Ihrer Organisation effizient einsetzen ließe. |

| 2. | Starten Sie mit einem Piloten. Nach der ersten Evaluierung fallen Ihnen bestimmt kleinere Projekte ein, die wie geschaffen für KI sind. So gewinnen Sie sowohl Sicherheit im Umgang mit der Materie als auch wertvolles Wissen für die weitere Skalierung. |

| 3. | Alle Macht der Basis. Meistens sind es die Fachabteilungen, die KI-Projekte forcieren. Mit deren Support ist die Erfolgswahrscheinlichkeit ungleich höher. |

| 4. | Die Menschen nicht vergessen. Bei Digitalisierung und KI reagieren viele Menschen noch mit Skepsis oder Angst. Um dem entgegenzuwirken, ist es notwendig, die Belegschaft zu beteiligen und ihre Bedenken ernst zu nehmen. |

Eine einfach zu bedienende Lösung wie die „A1 Digital Machine Learning Plattform powered by BigML“ macht es möglich, dass auch „Nicht-ITler“ ohne Programmierkenntnisse ML-Algorithmen auf komplexe Daten anwenden können, um wichtige Erkenntnisse zu gewinnen. A1 Digital hat hier die Erfahrung gemacht, dass ein breiteres Interesse an den Themen ML und KI vorhanden ist: Konzernweit wurde ein Training für 20 Key-User organisiert. Nach kurzer Zeit hat sich dies so sehr herumgesprochen, dass es 115 Anmeldungen gab. Viele Firmen, vor allem aus der Finanzbranche, gingen ähnlich vor. Mit dem Ergebnis, dass ML in vielen Abteilungen nicht mehr nur von Datenexperten mit Programmierkenntnissen, sondern von Personen mit den unterschiedlichsten Hintergründen angewendet wird. //

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…

Obwohl Active Sourcing zu den Top-Recruiting-Trends zählt, greift es zu kurz. Denn es genügt längst nicht mehr, interessante Kandidaten auf dem Arbeitsmarkt zu identifizieren und zu kontaktieren.

Um die Smart Factory Wirklichkeit werden zu lassen, sind digitale Assistenzsysteme für die Fertigung unabdingbar geworden.

von Dipl.- Ing. (FH) Johann Hofmann

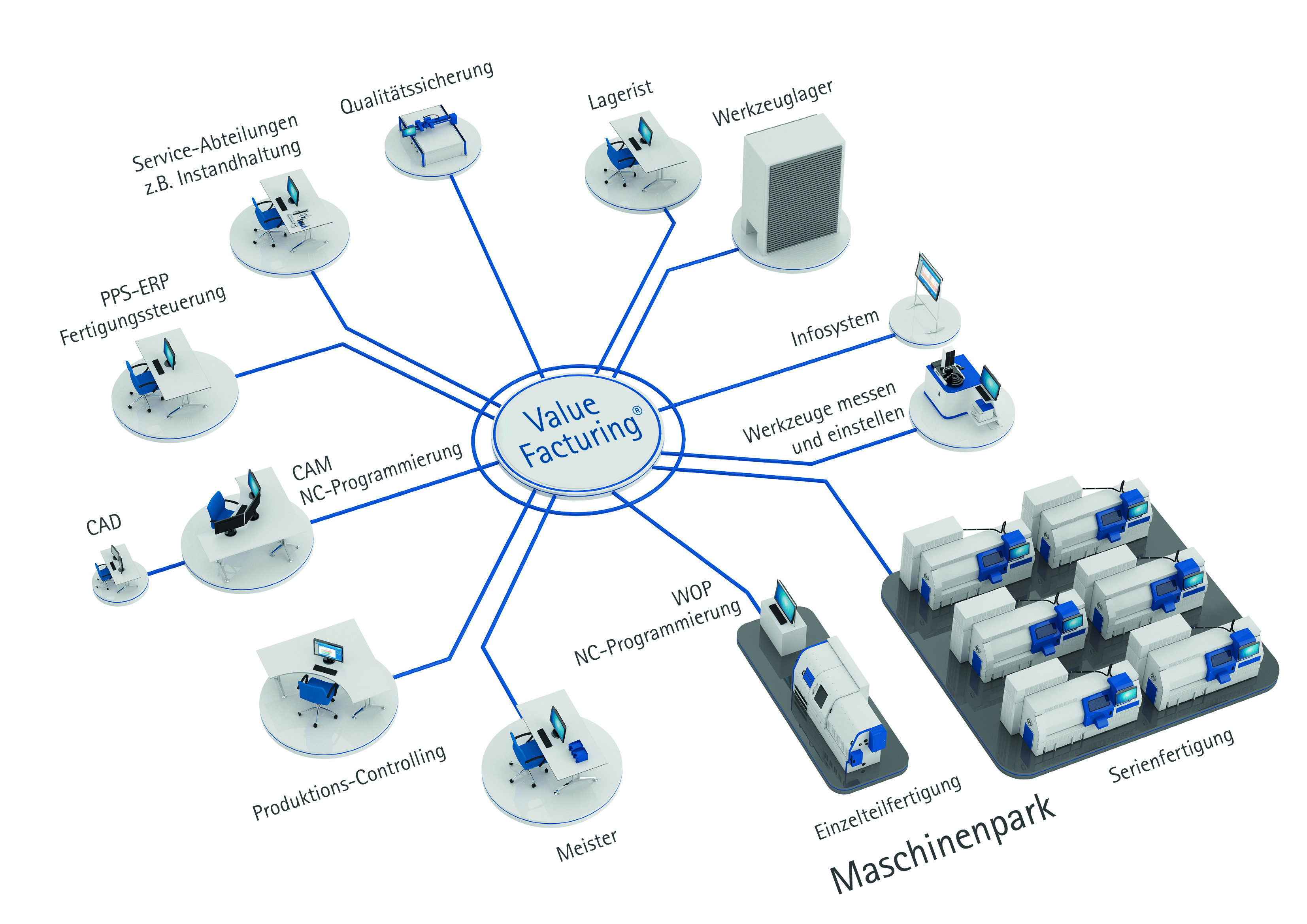

Es braucht Erfindungsgeist und Ausdauer, wenn Visionen wahr werden sollen. Die Realisierung der Vision der Hochleistungsfertigung der Zukunft ist dafür ein hervorragendes Beispiel: Das Assistenzsystem ValueFacturing® entstand in langjähriger Detailarbeit in der firmeneigenen zerspanenden Fertigung der Maschinenfabrik Rheinhausen und realisiert die digitale Transformation auf dem Weg zur digitalen Hochleistungsfertigung ganz im Sinne einer Smart Factory.

Das System vernetzt alle am Fertigungsprozess beteiligten Anlagen, Systeme und Personen. So leitet es beispielsweise Mitarbeiter bei ihrer Arbeit an, ermöglicht smarte Prozesse und befähigt zu besseren Entscheidungen.

Dafür werden einzelne Arbeitsgänge aus dem vom ERP-System ausgelösten Fertigungsauftrag direkt vom Assistenzsystem übernommen und bis zur Rückmeldung digital begleitet und gesteuert. Gleichzeitig erfolgt eine Rückmeldung über die verschiedenen Teilschritte aus der Produktion an das ERP-System. Damit wurde die Basis für ein Internet der Dinge in der Fertigung geschaffen. Physische Objekte wie Werkzeuge werden dank Cloud-Lösungen mit einer virtuellen Repräsentation in einer Internet-ähnlichen Struktur abgebildet.

Herzstück des Assistenzsystems ist die bidirektionale Online-Kommunikation in Echtzeit mit allen am Fertigungsprozess beteiligten Akteuren und der Fähigkeit, Informationen intelligent anzureichern. Das Assistenzsystem bietet neue innovative Features, die eine signifikante Rüstzeitenreduzierung und somit höhere Maschinennutzung ermöglichen. Mit ValueFacturing® gewinnen alle Prozessbeteiligten des Shopfloors mehr Transparenz über den aktuellen Stand ihrer Fertigung. Das Assistenzsystem unterstützt sie smart bei der Ausführung ihrer täglichen Aufgaben.

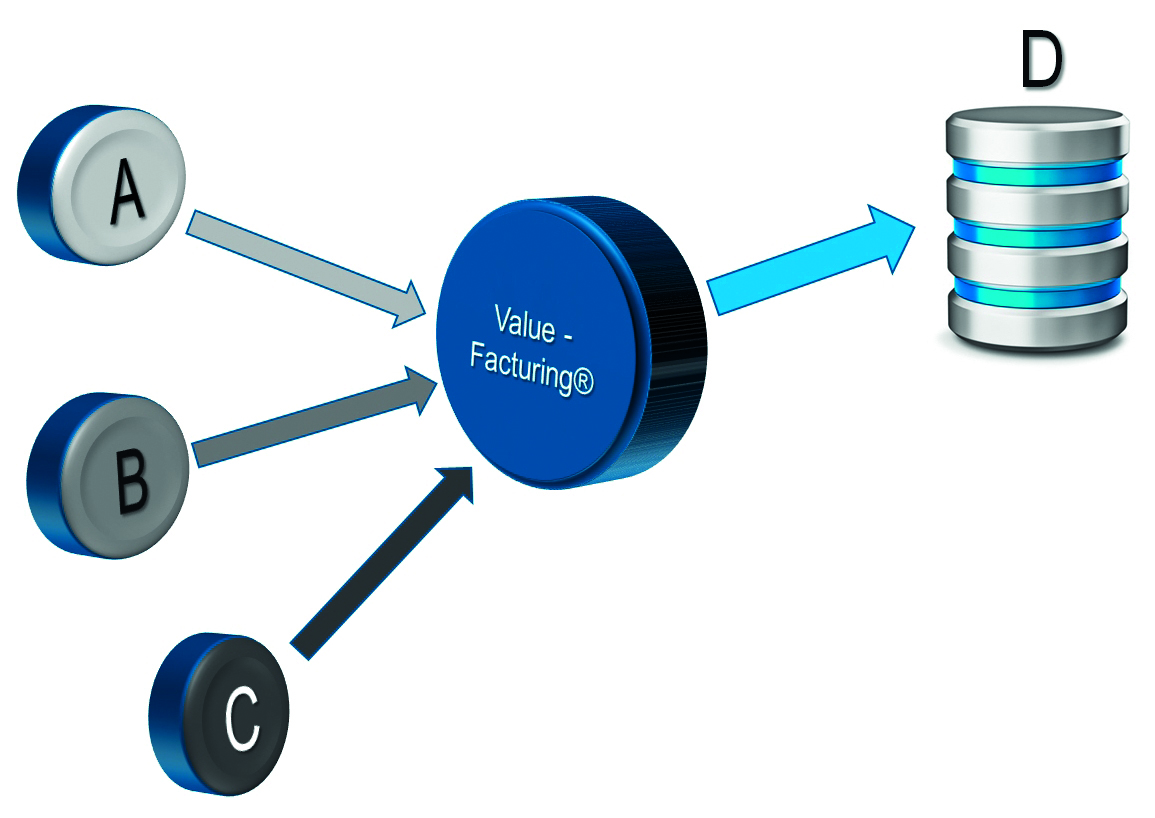

Der größte Vorteil allerdings ist die Fähigkeit der Datenanreicherung. Hierbei werden situationsabhängig neue Daten generiert. Zum Beispiel werden Fahrbefehle für Werkzeugeinstellgeräte beliebiger Hersteller und unterschiedlichster Softwarestände „just in time“ erzeugt. Hierbei werden vom Assistenzsystem von verschiedenen Systemen (A, B und C) vorhandene Daten für einen anfragenden Akteur (D) abgeholt. Durch intelligente Verknüpfung dieser Daten inklusive umfangreicher Berechnungslogik werden im Ergebnis neue, für einen effizienten Workflow erforderliche Daten erzeugt (Bild 3).

Dieser Effekt wird auch im folgenden ZVEI- Positionspapier, das zur Hannover Messe 2017 veröffentlicht wurde, beschrieben:

„Industrie 4.0 und MES – Voraussetzung für das digitale Betriebs- und Produktionsmanagement – Aufgabenstellungen und künftige Anforderungen“

|

|

A = beliebiges ERP-System |

Im Kapitel 3.3.5.4 „Dynamisches Ausführungsmanagement“ ist dort die Flexibilisierung betrieblicher Abläufe als wichtiger Bestandteil im digitalen Rüst-Workflow beschrieben. Die Umstellung von althergebrachten starren Abläufen in dynamische Abläufe ist Bestandteil der Digitalisierungsstrategie von Industrie 4.0. Als „starr“ bezeichnet man alle Systeme, deren Abläufe durch Vorbedingungen festgelegt sind. Als „dynamisch“ bezeichnet man alle Systeme, die ihre Vorbedingungen automatisch an eine neue Situation anpassen können.

Das Verfahren der dynamischen Datenanreicherung erfordert umfangreiches Wissen aus der jeweiligen fachspezifischen Domäne. Im Fall der Maschinenfabrik Reinhausen ist das die zerspanende Fertigung. Jahrzehntelang angesammeltes Know-how ist Kernbestandteil der dynamischen Datenanreicherung mit ValueFacturing®. Das erspart z. B. dem Mitarbeiter am Einstellgerät tagtäglich viel Zeit. Noch viel wertvoller ist allerdings der „Poka-Yoke“-Effekt (dt. „unglückliche Fehler vermeiden“), der dadurch ermöglicht wird, dass das fehlerträchtige Eintippen von starren Daten entfällt. Dieses dynamische Erzeugen der Daten ermöglicht auch jederzeit, den anfragenden Akteur (D) im Bild 2 auszutauschen oder durch Updates zu erweitern, denn die benötigten Daten werden immer passend für ihn „just in time“ automatisch neu generiert.

| Hintergrund |

| Die Maschinenfabrik Reinhausen GmbH (MR) ist weltweit führender Anbieter (ca. 50 Prozent Weltmarktanteil) von Laststufenschaltern für die Hochspannungstechnik. Das in Regensburg ansässige und weltweit tätige mittelständische Unternehmen erwirtschaftete im vergangenen Geschäftsjahr mit 3 550 Mitarbeitern und 49 Tochter- und Beteiligungsgesellschaften einen Umsatz von 750 Millionen Euro.

Seit Jahrzehnten zählt für die MR eine große Fertigungstiefe in Deutschland zu den bedeutenden Wettbewerbsvorteilen. Dabei hat sich die MR seit knapp 30 Jahren dem Ziel eines intelligenten Fertigungsflusses verschrieben – mit großem Erfolg. In der firmeneigenen zerspanenden Fertigung wurde in jahrzehntelanger Detailarbeit das Assistenzsystem ValueFacturing® mit richtungsweisenden Funktionen entwickelt. Der Nutzen dieser Lösung wirkt in den Wertschöpfungsketten im Zentrum der deutschen Produktionsindustrie und ist ein bedeutender Baustein von Industrie 4.0. Mit ValueFacturing® können vor allem die wirtschaftliche Fertigung der Losgröße 1, die Beherrschung von beliebiger Varianz und die Verkürzung der Lieferzeit signifikant und nachhaltig verbessert werden. |

Modernste Server-, Web- und Cloud-Technologien sichern die Systemverfügbarkeit und gewährleisten gleichzeitig maximale IT-Sicherheit. Durch Einsatz von ValueFacturing® auf Basis der Microsoft Azure Cloud lässt sich ein Rollout auf weitere Unternehmensstandorte weltweit bequem realisieren. Der Einsatz von ValueFacturing® in Verbindung mit Smart Devices ermöglicht Management und Mitarbeitern den Live-Blick in die Fertigung – und das weltweit. Das Internet of Things (IoT) wird so erlebbar. Die Benutzerverwaltung von ValueFacturing® ist mit einem umfangreichen Rechtesystem versehen und lässt eine gezielte Steuerung der zulässigen Aktivitäten je Mitarbeiter zu und erhöht so die Sicherheit. Umfangreiche Health-Checks zur effizienten Überprüfung des Systemzustandes in Realtime vereinfachen die Administration.

Das Sammeln von Echtzeit-Daten ermöglicht kennzahlenorientiertes Managen im Shopfloor. Um aus den tagesaktuellen Shopfloor-Daten Verbesserungen ableiten zu können, wird das Analytics-Portfolio von ValueFacturing® stetig ergänzt. Das Herausfiltern einzelner wichtiger Informationen aus diesen großen Datenmengen wird als „Data Mining“ oder Mustererkennung bezeichnet. Dazu werden Massendaten (Big Data) mit Datenanalyse- und Entdeckungsalgorithmen durchsucht mit dem Ziel, neue Muster, Querverbindungen und Trends zu erkennen.

Z.B. die Berechnung des Stückzählers durch ValueFacturing® erfordert Mustererkennungsmethoden und ist ein Meilenstein in der Maschinendatenerfassung (MDE). Dadurch werden die Rohdaten zu Smart Data, die neuen Erkenntnisgewinn bringen. Um Fehlinterpretationen weitestgehend zu vermeiden, müssen die Entdeckungsalgorithmen Ausreißer und manipulierte Daten erkennen und aus der Bewertung entfernen.

Schritt für Schritt werden so die „Enabler“ von Industrie 4.0 aus Bild 1 Realität. //

Autorenvita: Dipl.- Ing. (FH) Johann Hofmann

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…

Durch die automatisierte Auswertung von Satellitenbilddaten mittels Deep-Learning-Algorithmen den Zustand der Erde bestimmen

von Benjamin Bischke und Patrick Helber

Die Zusammenhänge und Wechselwirkungen in unserer Welt werden zunehmend komplexer und undurchsichtiger. Täglich generieren unzählige Sensoren und smarte Internet-of-Things(IoT)-Geräte immense Datenmengen. Eine korrekte Analyse dieser Daten trägt maßgeblich dazu bei, die Welt besser zu verstehen, und eröffnet in zahlreichen Branchen Möglichkeiten zur Umsetzung neuer Anwendungen und Optimierung bestehender Prozesse.

Bis vor wenigen Jahren war es äußerst schwierig, dieses riesige Volumen an Daten im Detail zu verstehen und neue Lösungsansätze basierend auf diesen Daten umzusetzen. Der Durchbruch der künstlichen Intelligenz (KI) im Kontext der Digitalisierung als Schlüsseltechnologie hat dies jedoch grundlegend verändert. Algorithmen aus dem Gebiet des maschinellen Lernens erlauben es, riesige Datenmengen innerhalb kürzester Zeit zu analysieren, Muster und Zusammenhänge aus den Daten zu extrahieren und basierend darauf schnellere und genauere Entscheidungen für die Zukunft treffen zu können.

Ob künstliche Intelligenz, maschinelles Lernen oder Deep Learning, in der Praxis werden diese Begriffe häufig als Synonyme verwendet. Dabei besitzen die drei Begrifflichkeiten große Unterschiede in ihrer Bedeutung und stehen in einer strikten Hierarchie zueinander. Die künstliche Intelligenz ist der Oberbegriff für alle Methoden und Technologien, die ein intelligentes Verhalten vorweisen. Das maschinelle Lernen ist dabei ein Teilgebiet der KI, welches eine Vielzahl an (Lern-)Methoden basierend auf der mathematischen Optimierung und Statistik umfasst. Deep Learning wiederum ist ein spezieller Teilbereich des maschinellen Lernens, der versucht, die statistischen Korrelationen in den Daten durch künstliche neuronale Netze abzubilden.

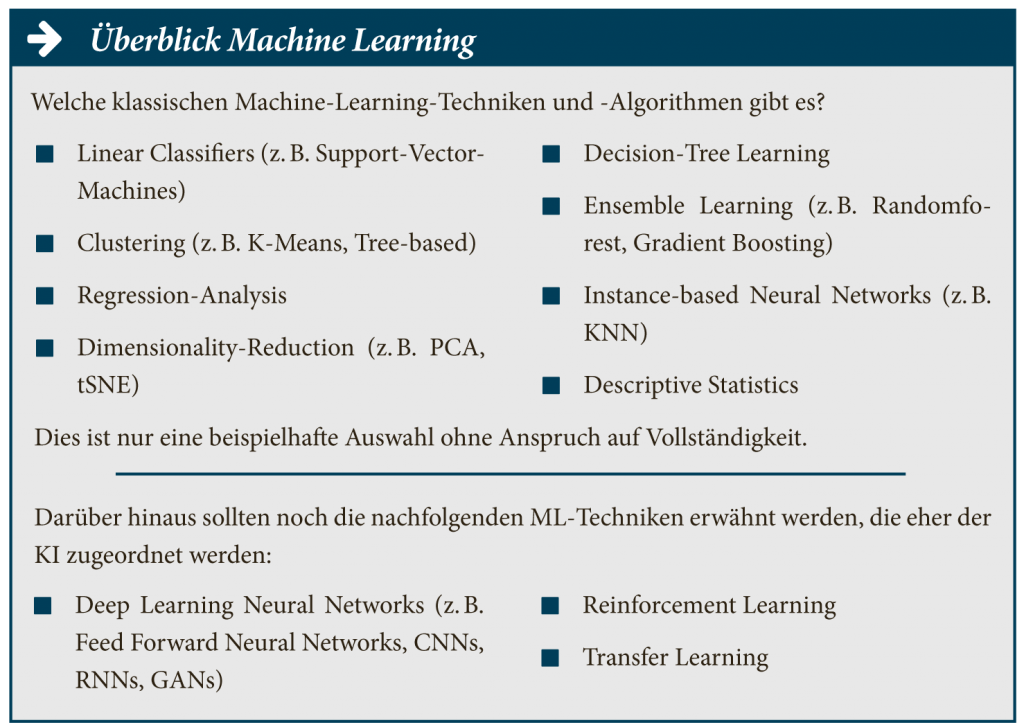

In der Fachliteratur teilt man die Methoden der KI in zwei Teilbereiche auf:

Die symbolische KI und die statistische KI.

In diesem Kontext ist das maschinelle Lernen (ML) als eines der wichtigsten und nutzbringendsten Teilgebiete der statistischen KI besonders hervorzuheben. Gerade im Zuge der Digitalisierung steht das maschinelle Lernen bei vielen Unternehmen im Fokus der Aufmerksamkeit, um sich einen Vorsprung gegenüber den Wettbewerbern zu sichern.

Die Anwendungen von maschinellen Verfahren sind vielschichtig und branchenübergreifend für zahlreiche Unternehmen relevant: So können beispielsweise im Bereich der Medizin mithilfe maschineller Lernverfahren die Wechselwirkungen mehrerer Medikamente vorhergesagt werden. Im Rahmen der Wirtschaftsprüfung können mithilfe des maschinellen Lernens komplexe Geschäftsprozesse aus Millionen von undurchsichtigen Transaktionsdaten gelernt werden. Dies erlaubt es, Anomalien, die beispielsweise im Zusammenhang mit der Wirtschaftskriminalität stehen, automatisiert zu identifizieren.

„Die künstliche Intelligenz ist der Oberbegriff für alle Methoden und Technologien, die ein intelligentes Verhalten vorweisen.“

Die Verfahren des maschinellen Lernens bauen auf mathematischen Theorien auf, wobei insbesondere die Gebiete der Optimierung und Statistik zur Anwendung kommen. Dabei verarbeiten die Verfahren die Eingabedaten und erstellen je nach Anwendung ein spezifisches mathematisches Modell. Das Finden der besten Parameter für das entsprechende Modell nennt man in der Fachsprache das Trainieren oder Lernen eines Modells. Mithilfe der gelernten Modelle lassen sich dann Wahrscheinlichkeiten für zukünftige Ereignisse berechnen oder riesige Datenmengen auf relevante Informationen reduzieren und hinsichtlich bedeutender Eigenschaften gruppieren.

Ein Teilbereich des maschinellen Lernens ist Deep Learning, das besonders im Fokus rund um die aktuelle Hochphase der KI steht. Bei Deep Learning wird versucht, das menschliche Gehirn in einem vereinfachten mathematischen Modell mittels künstlicher neuronaler Netze abzubilden. Abstrakt betrachtet stellt Deep Learning hierfür ein sehr mächtiges Framework bereit, mit dem neuronale Netze mit unterschiedlichen Architekturen trainiert werden können. Diese Netze sind in der Lage, entscheidende Merkmale, die für die Lösung eines Problems relevant sind, automatisch aus den Daten zu lernen. Im Gegensatz zu klassischen Verfahren des maschinellen Lernens, bei denen die Merkmale von dem Menschen aufwendig entworfen und definiert werden müssen, lernen die neuronalen Netze selbstständig die Korrelationen und Merkmale aus den Daten.

„Heutzutage nehmen Satelliten eine riesige Datenmenge an Bildern pro Tag auf, welche in der Praxis händisch nicht auszuwerten sind.“

Mathematisch kann gezeigt werden, dass die neuronalen Netze eine

beliebige mathematische Funktion abbilden können. Zur Lösung komplexer

und nicht linearer Problemstellungen werden jedoch Netzwerke mit

besonders vielen Schichten aus Neuronen (und somit ein tiefschichtiges

Netzwerk) benötigt, woher auch der Begriff des „Deep Learnings“

resultiert. Diese vielschichtigen Netzwerke erlauben es zwar, komplexe

Probleme näherungsweise besser zu lösen, gleichzeitig erfordert ein

solcher Ansatz aber auch eine besonders hohe Anzahl an freien

Parametern, die durch ein aufwendiges Training bestimmt werden müssen.

Das eigentliche Training ist ein nicht konvexes Optimierungsproblem, bei

dem die Netzwerkparameter näherungsweise bestimmt werden müssen.

Aufgrund der hohen Parameteranzahl werden hierfür zwei wichtige Voraussetzungen benötigt:

Durch die Vielzahl an Sensoren und die Verfügbarkeit von Ressourcen über das Internet ist der erste Punkt mittlerweile oftmals einfach zu erfüllen. Bei der Rechenpower wurden ursprünglich Grafikkarten zweckentfremdet, um die mathematischen Operationen schneller zu berechnen als durch herkömmliche „Central Processing Unit“(CPU)-Prozessoren. Aktuell bieten führende Grafikkartenhersteller wie Nvidia dedizierte Prozessorchips an, die sich auf die mathematischen Operationen des Deep Learnings spezialisiert haben und es erlauben, Tausende von Operationen zu parallelisieren. Durch die Supercomputer von Nvidia wie die DGX-1- und DGX-2-Systeme(1) lassen sich neuronale Netze mittlerweile innerhalb von wenigen Minuten trainieren. Bis vor wenigen Jahren wurden hierfür mehrere Wochen oder gar Monate benötigt.

Die Vereinten Nationen (UN) haben im Jahr 2012 auf der Rio+20-Konferenz Ziele für die nachhaltige Entwicklung unserer Welt festgelegt. Im Rahmen dieser Agenda wurden 17 Zielsetzungen für eine nachhaltige ökonomische, soziale und ökologische Entwicklung bestimmt. Diese nachhaltige Zielsetzung ist unter dem Namen „Sustainable Development Goals“ (SDGs) wie auch unter dem Namen Agenda 2030 oder Weltzukunftsvertrag bekannt und ist am 1. Januar 2016 mit einer geplanten Umsetzung bis zum Jahre 2030 in Kraft getreten(2). Im Rahmen dieser Agenda finden sich Ziele, wie die Ernährung für die gesamte Weltbevölkerung nachhaltig zu sichern sowie eine nachhaltige Städte- und Siedlungsentwicklung voranzutreiben.

Eine mögliche Hilfe bei der Erreichung dieser Nachhaltigkeitsziele bieten Erdbeobachtungsdaten insbesondere in Form von Luft- und Satellitenbildern. Durch die Auswertung dieser Daten können Aussagen über die Bestellung von landwirtschaftlichen Feldern oder auch über das aktuelle Lagebild nach einer Naturkatastrophe getroffen werden. Der starke Anstieg an verfügbaren Erdbeobachtungsdaten, insbesondere durch Luft- und Satellitenbilddaten, ermöglicht eine niemals zuvor mögliche Analyse der Erde.

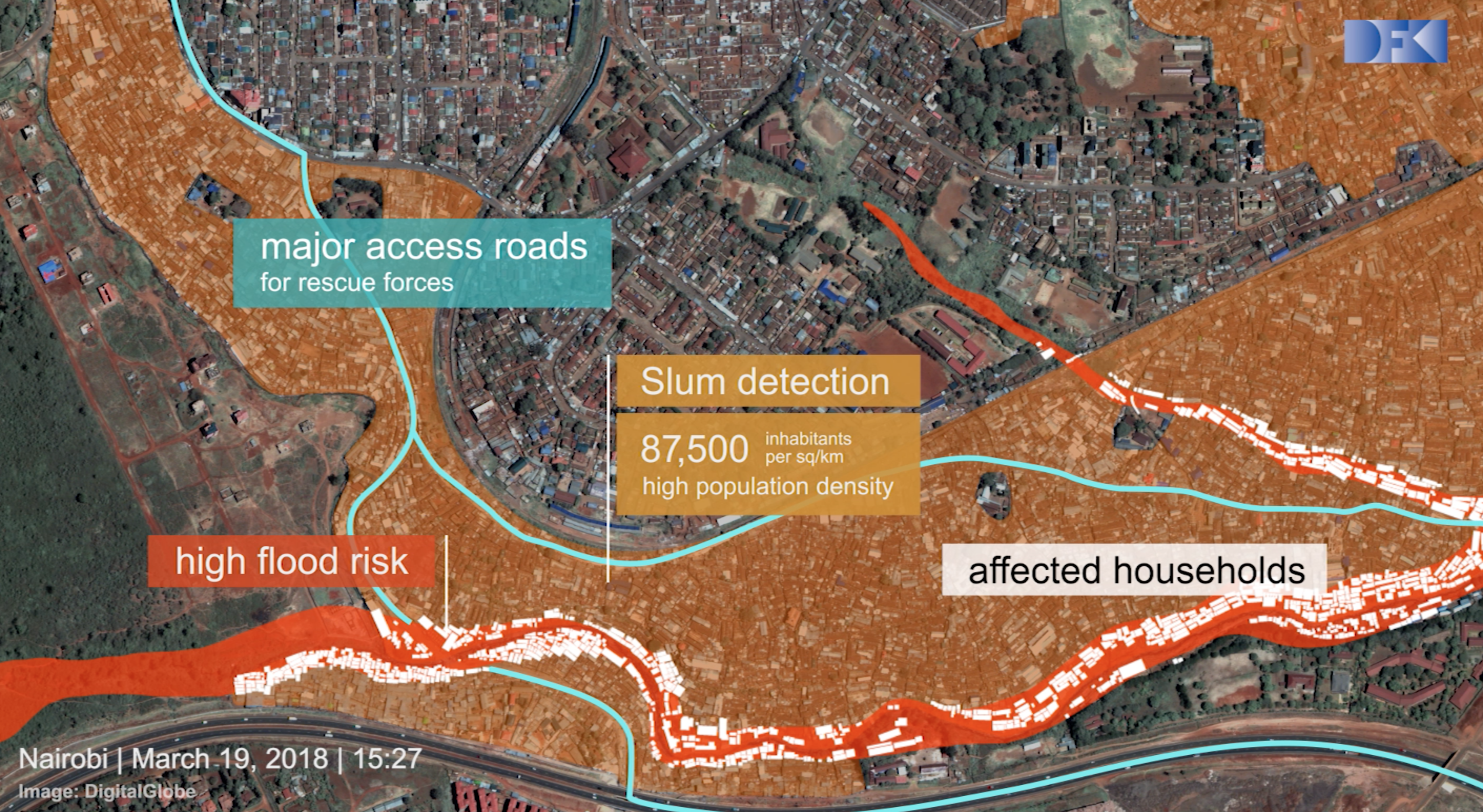

Heutzutage nehmen Satelliten eine riesige Datenmenge an Bildern pro Tag auf, welche in der Praxis händisch nicht auszuwerten sind. Die erzeugten Daten sowie der Fortschritt auf dem Gebiet der künstlichen Intelligenz erlauben die Entwicklung einer automatisierten Lösung. Dabei kann eine lokale Auswertung einzelner z. B. von einer Naturkatastrophe betroffener Gebiete sowie eine detaillierte globale Analyse des Zustands der Erde vorgenommen werden. Die so entwickelte künstliche Intelligenz kann als Grundpfeiler für eine global automatisierte Erdbeobachtungslösung dienen und somit zur Erreichung der von den Vereinten Nationen bestimmten Nachhaltigkeitsziele maßgeblich beitragen. Ein Beispiel hierfür ist die Auswertung von Erdbeobachtungsdaten vor und nach dem Eintreten von Naturkatastrophen.

Das Deutsche Forschungszentrum für künstliche Intelligenz (DFKI) hat sich seit 2016 mit dem Start des Forschungsprojekts „Deep Eye“ insbesondere der Analyse von Naturkatastrophen mittels Satellitenbilder unter der Zielsetzung „AI for Good“ beschäftigt(3). Derzeit werden Aufnahmen vor und nach Katastrophen zwar computergestützt, jedoch manuell ausgewertet. Eine vollständig automatisierte Verarbeitung der Satellitenbilddaten gestützt durch Methoden der künstlichen Intelligenz hilft, entsprechende Bilder effektiver und effizienter auszuwerten und somit schneller im Falle einer Naturkatastrophe zu agieren. Im Mittelpunkt des DFKI-Projekts „Deep Eye“ steht die Verbesserung der im Notfall verfügbaren Ressourcen.

Das Forscherteam entwickelte mehrere Systeme, wie zum Beispiel „Deep Eye“, um Satellitenbilder mit tiefen neuronalen Netzwerken zu analysieren(4). Ziel dieser Systeme ist es, Schäden sowie Überschwemmungsflächen automatisch zu erkennen, die Auswirkungen des Überschwemmungsgebietes zu quantifizieren und die Zugänglichkeit der Infrastruktur während der Naturkatastrophen hervorzuheben.

Das Deutsche Forschungszentrum für künstliche Intelligenz (DFKI) hat zur Umsetzung dieser Zielsetzung die Ausgründung Vision Impulse(5) ins Leben gerufen. Der Fokus des DFKI-Spin-offs liegt auf der automatisierten Analyse von Luft- und Satellitenbilddaten mittels Deep Learning. Neben der effektiven Schadenskalkulation nach dem Eintreten einer Naturkatastrophe haben die zukunftsweisenden Technologien der Ausgründung das Potenzial, Unternehmen bei dem Erreichen ihrer Nachhaltigkeitsziele zu unterstützen. //

Autorenvitae

|

|

| Benjamin Bischke | Patrick Helber |

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…

Das IoT ist voller Daten. Sie auszuwerten, ist der zentrale Schlüssel, sich den Nutzen des Internets der Dinge zu erschließen.

von Daniel Metzger

Für die in vielen Branchen übliche Nutzung des „Internet of Things“ (IoT) gibt es einen ausschlaggebenden Grund: Mit den gewonnenen Daten können Prozesse und Betriebsabläufe genauer gesteuert und die Auslastung kann effizienter geregelt werden. Hier fällt ein hohes Volumen relativ kleiner Datensätze an, wie sie von Sensoren erfasst und weitergemeldet werden. Doch neben der Herausforderung, große Mengen anfallender Daten zu verarbeiten und daraus Schlüsse zu ziehen, gilt es beim IoT weitere Hürden zu meistern. Denn um auf Echtzeit-Analysen basierende Entscheidungen zu treffen, sind vor allem die Geschwindigkeit der Datenverarbeitung und die Sicherheit der Datenübertragung von entscheidender Bedeutung. Smarte Sensoren und IoT-Geräte unterscheiden sich sowohl in ihrem Einsatzzweck als auch in der Vielschichtigkeit der von ihnen erhobenen Daten. Die verschiedenen Daten zu analysieren, um daraus Erkenntnisse abzuleiten, ist beim Einsatz des IoT ebenso eine Herausforderung wie die Einhaltung von Governance-Richtlinien bei der Datenverarbeitung.

Für die in vielen Branchen übliche Nutzung des „Internet of Things“ (IoT) gibt es einen ausschlaggebenden Grund: Mit den gewonnenen Daten können Prozesse und Betriebsabläufe genauer gesteuert und die Auslastung kann effizienter geregelt werden. Hier fällt ein hohes Volumen relativ kleiner Datensätze an, wie sie von Sensoren erfasst und weitergemeldet werden. Doch neben der Herausforderung, große Mengen anfallender Daten zu verarbeiten und daraus Schlüsse zu ziehen, gilt es beim IoT weitere Hürden zu meistern. Denn um auf Echtzeit-Analysen basierende Entscheidungen zu treffen, sind vor allem die Geschwindigkeit der Datenverarbeitung und die Sicherheit der Datenübertragung von entscheidender Bedeutung. Smarte Sensoren und IoT-Geräte unterscheiden sich sowohl in ihrem Einsatzzweck als auch in der Vielschichtigkeit der von ihnen erhobenen Daten. Die verschiedenen Daten zu analysieren, um daraus Erkenntnisse abzuleiten, ist beim Einsatz des IoT ebenso eine Herausforderung wie die Einhaltung von Governance-Richtlinien bei der Datenverarbeitung.

In der Fertigung lassen sich Maschinen mit Sensoren ausstatten, die für eine vorausschauende Instandhaltung („Predictive Maintenance“) herangezogen werden können. Im Gegensatz zum herkömmlichen Ansatz, Wartungen nach vorher definierten Arbeitsstunden oder geleisteter Stückzahl stattfinden zu lassen, meldet die Maschine den Status ihrer Abnutzung und ihres technischen Zustandes aktiv an einen Produktionsserver, der das Wartungsintervall individuell auf diese eine Maschine abstimmt. Damit wird zweierlei erreicht: Einerseits wird verspätete Wartung und eventuell einhergehender Schaden vermieden, andererseits entstehen keine zu kurzen Wartungszyklen. Beides schont die finanziellen und logistischen Ressourcen des Unternehmens. Auch die Logistik während und nach der Produktion wird durch Big Data im IoT wesentlich erleichtert. Besonders in der Just-in-time-Fertigung ist es sowohl für produzierende Betriebe als auch Zulieferer wichtig, nachvollziehen zu können, wo sich Werkstücke aktuell befinden. Damit sollen Lagerhaltungskosten weitgehend ausgeschlossen werden.

„Die verschiedenen Daten zu analysieren, um daraus Erkenntnisse abzuleiten, ist beim Einsatz des IoT ebenso eine Herausforderung wie die Einhaltung von Governance-Richtlinien bei der Datenverarbeitung.“

Doch auch andere Branchen setzen mittlerweile auf Big Data und Industry of Things. So sind Energieversorgungsunternehmen durch Veränderungen, beispielsweise bei der Energieerzeugung, mit neuen Anforderungen an ihre betrieblichen Prozesse konfrontiert. Dazu kommt der Wandel der Kundenanforderungen. Auch die vermehrte Nutzung alternativer Heizarten bei Endkonsumenten, beispielsweise Wärmepumpen oder Solaranlagen, führt zu einer weiteren Komplexität beim Stromvertrieb. So sollten Konsumenten mit Preisnachlässen dafür belohnt werden, wenn sie den Strom zu einem Zeitpunkt verbrauchen, an dem er besonders günstig für den Vertrieb bereitsteht. Hierzu messen intelligente Stromzähler („Smart Meter“) den Energieverbrauch und können diese Informationen den Versorgern zeitnah übermitteln. In einem System mit automatisierten Stromzählern werden Verbrauchsdaten in Echtzeit analysiert und entsprechende Muster erkannt, die zur Prognose herangezogen werden. Auch können Sensoren und intelligente Stromzähler rechtzeitig vor drohenden Ausfällen einzelner Komponenten im Stromnetz warnen. Die gewonnenen Daten werden in einer Big-Data-Lösung zusammengefasst, die detaillierten Aufschluss über die aktuelle und künftige Situation liefert. Dadurch wird es Energieversorgern ermöglicht, die Ausfallsicherheit in erheblichem Maß zu steigern, um so die Versorgungssicherheit der Verbraucher zu garantieren.

Neue medizinische Methoden, verbesserte Behandlungen oder die bessere Anpassung von Medikamenten sind mit enormen Investitionen in Forschung verbunden. Dafür benötigt der Gesundheitssektor – mehr denn je – eine solide Datenbasis. Aber auch die Behandlung der Patienten selbst muss in Zeiten knapper Gesundheitskassen effizienter gestaltet werden. So kann die Erfassung von Patientendaten über mobile Tracker einen vollständigen Überblick über den Gesundheitsstatus bieten. Ein solcher Tracker(1) kann mittels Hautsensor beispielsweise den Blutzuckerspiegel messen. Das gilt ebenso für Vitalfunktionen wie eine Messung von Puls oder Blutdruck, wie sie manche Smartwatch oder mancher Fitnesstracker bereits bietet. Durch den Abgleich von Echtzeit-Analysedaten und Machine-Learning-Modellen, basierend auf historischen Patientendaten, wird eine vorausschauende und nachhaltige Patientenüberwachung gewährleistet. Daraus können Ärzte frühzeitig Abweichungen von individuellen Normalwerten erkennen und so im Idealfall Menschenleben retten. Außerdem ist es möglich, dass diese Daten – anonymisiert – dazu führen, auch anderen Patienten schnell eine erfolgreiche Behandlungsmethode zur Verfügung zu stellen. Zusätzlich können unterstützende Reha- und Wellnessanwendungen entwickelt, getestet und bei Erfolg breit angewendet werden. Dies geschieht über mit dem Internet verbundene Geräte, die beispielsweise Blutdruck und Herzfrequenz überwachen sowie Aufschluss über Cholesterinwerte oder andere medizinisch relevante Faktoren bieten. Mittels maschinellen Lernens können Ärzte, Krankenhäuser und Pharmaunternehmen positive Musterveränderungen erfassen und konsequent weiterentwickeln.

„Um all diese Massendaten effizient verarbeiten zu können und den eingangs erwähnten weiteren Herausforderungen Rechnung zu tragen, ist eine Big-Data-Plattform zum Echtzeit-Streaming erforderlich, die die verschiedenen beteiligten Prozesse sicher und schnell verarbeitet.“

Die Basis der Geschäftstätigkeiten von Versicherungen sind Daten. Sie berechnen Risiken und legen daraufhin die Höhe der Raten für Versicherungspolicen fest. Dies erfolgte bislang über theoretische mathematische Modelle, die auf regelmäßigen Marktanalysen, Studien und Statistiken beruhten. Mit dem zunehmenden Wettbewerbsdruck müssen Versicherer ihre Angebote vielschichtiger und an die Zielgruppe angepasster entwickeln. Auch die Art und Weise, wie und wogegen sich Konsumenten und Unternehmen versichern wollen, ändert sich – etwa durch die Veränderung im Falle von Gebäudeschäden durch den Klimawandel oder die Einführung neuer Technologien wie etwa dem autonomen Fahren im Straßenverkehr.

Sowohl das Konzept von Smart Cities(2) als auch von Smart Cars ist ohne Big Data schwer vorstellbar. In Smart Cars finden sich mehrere Hundert IoT-Komponenten, die assistiertes oder vollautonomes Fahren ermöglichen. So kann das Fahrzeug selbstständig auf plötzlich auftretende Vorfälle reagieren oder eine autonome Navigation ermöglichen. Der Fahrer wird zudem beispielsweise automatisch darauf hingewiesen, wann sein nächster Ölwechsel fällig ist und er zum Service in die Werkstatt muss. Ist das Fahrzeug mit einer Smart City verbunden, kann diese mit dem Smart Car kommunizieren, um die Verkehrsströme effizient zu leiten und Verkehrsstaus sowie die durch den Straßenverkehr anfallende Umweltbelastung zu minimieren.

Hier messen in Straßen verbaute Sensoren den Verkehrsfluss sowie die Parksituation und reagieren entsprechend. Doch Smart Cities sind nicht nur im Verkehrsbereich attraktiv. Auch bei der Sicherstellung der kommunalen Versorgung beziehungsweise in der Entsorgung hilft der Einsatz von Big Data. Diese Systeme führen dazu, dass sich die Ressourcen der Städte besser planen und einsetzen lassen, um Bürgern eine höhere Servicequalität bieten zu können.

Um all diese Massendaten effizient verarbeiten zu können und den eingangs erwähnten weiteren Herausforderungen Rechnung zu tragen, ist eine Big-Data-Plattform zum Echtzeit-Streaming erforderlich, die die verschiedenen beteiligten Prozesse sicher und schnell verarbeitet. So ermöglicht Hortonworks Dataflow (HDF) IoT-Implementierungen innerhalb eines Unternehmens als End-to-End-Plattform. Sie sammelt, kuratiert und analysiert IoT-Streaming-Daten in Echtzeit, von den Perimetern bis hin zum Zentrum eines Unternehmens. Apache NiFi liefert dabei Datenerfassung, -transformation und -routing von IoT-Streamingdaten. Daneben bietet Apache Kafka innerhalb von HDF eine leistungsstarke Stream-Verarbeitungs-Engine zur Erzeugung von Predictive Analytics. //

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…

Diese entscheidenden Vorteile bringt die Arbeitszeiterfassung für Unternehmen.

Wandel durch Technologie ist für Vermögensverwalter spätestens seit der Einführung digitaler Plattformen und Anwendungen sowie dem Aufkommen von Robo-Advisors eine Selbstverständlichkeit. Aktuell arbeitet die Finanzindustrie an der Implementierung künstlicher Intelligenz (KI) und ausgefeilter Analytik. Doch die Einführung dieser Technologien allein wird definitiv nicht ausreichen, um auch künftigen Erfolg zu garantieren.

Digitale Infrastrukturen und das Internet of Things

von Jan Mahler

Die Art und Weise, wie Menschen miteinander kommunizieren, unterliegt seit jeher stetiger Veränderung. Von der Entwicklung der Sprache über die Schrift hin zu Technologien wie dem Telegramm oder der Telekommunikation haben wir stets neue Wege gefunden, den Informationsaustausch zu vereinfachen und zu beschleunigen. Mit dem Eintritt ins digitale Zeitalter und vor allem dank des Internets konnte einer der bisher größten Meilensteine in der zwischenmenschlichen Kommunikation errungen werden: die Übertragung von Informationen in Echtzeit.

Die Art und Weise, wie Menschen miteinander kommunizieren, unterliegt seit jeher stetiger Veränderung. Von der Entwicklung der Sprache über die Schrift hin zu Technologien wie dem Telegramm oder der Telekommunikation haben wir stets neue Wege gefunden, den Informationsaustausch zu vereinfachen und zu beschleunigen. Mit dem Eintritt ins digitale Zeitalter und vor allem dank des Internets konnte einer der bisher größten Meilensteine in der zwischenmenschlichen Kommunikation errungen werden: die Übertragung von Informationen in Echtzeit.

Seit einigen Jahren macht ein gänzlich neues Schlagwort Karriere: das Internet der Dinge (IoT). Im Internet der Dinge kommuniziert – ganz einfach gesagt – alles mit allem. Mit dem Entstehen intelligenter Geräte findet Kommunikation nicht mehr nur unter Menschen statt – sondern auch zwischen Geräten, mit denen wir im Alltag in Berührung kommen. Laut einer aktuellen Studie soll die Anzahl der an das IoT angeschlossenen Geräte bis 2022 bereits mehr als 50 Milliarden betragen. Manch einer bezeichnet das Internet der Dinge deshalb treffenderweise auch als das „Internet of Everything“.

Die Grundidee von IoT ist einfach. Es geht darum, Geräte über das Internet zu verbinden und sie mit uns, untereinander oder mit bestimmten Anwendungen kommunizieren zu lassen. Steigt die Anzahl an Geräten, die miteinander kommunizieren, so steigt auch die Menge an Daten, die bei dieser Kommunikation entstehen und im Umlauf sind. Komplexität entsteht dabei einerseits durch die Datenmenge selbst, andererseits aber auch durch die Vielzahl an unterschiedlichen Geräten, die diese Daten in Form von Signalen übermitteln. Je größer die Datenmengen, desto größer ist natürlich auch die Nachfrage nach IT-Infrastrukturen und Rechenzentren. Denn damit Daten sinnbringend und in Echtzeit gesammelt, übermittelt und ausgewertet werden können, sind sowohl die Rechenleistung, die Bereitstellung von direkten und sicheren Verbindungen im Rechenzentrum als auch die Abbildung einer globalen Verflechtung von großer Bedeutung.

| Strukturelle Herausforderungen zur Anwendung von IoT | |

| • | Integration in die bestehende IT (inklusive Nutzbarkeit hybrider Cloud-Modelle) und in angrenzende IoT-Ökosysteme |

| • | Die Bereitstellung und Verarbeitung der Daten dort, wo sie gebraucht werden |

| • | Daten inhaltlich nutzbar machen |

| • | Den Business-Case definieren und umsetzen |

| • | Garantierte Datensicherheit trotz globaler Verfügbarkeit |

| • | Geschwindigkeit (Latenz, Skalierung, Anpassung) |

Die Anforderungen an die zugrunde liegende IT-Infrastruktur sind sehr hoch: Sie muss sowohl skalierbar als auch auf ein derartiges Datenvolumen ausgelegt sein. Denn ein solch immenser Zuwachs an Daten, die das Internet jede Sekunde durchqueren, bedeutet, dass das Internet sich schon bald weiterentwickeln muss.

„Für Unternehmen, die auf IoT zurückgreifen, ist es nicht nur wichtig, mit wem, wie schnell und zuverlässig sie sich im Markt verbinden, sondern auch, wie flexibel diese Interaktion gestaltet werden kann.“

Eine solche Evolution bietet Interconnection. Interconnection ist wie ein zweites Internet zu verstehen, das auf direkten, privaten Verbindungen zwischen allen denkbaren Marktteilnehmern – also Unternehmen, Technologieanbietern, IT-Service-Providern und deren Partnern – basiert. Durch Interconnection entstehen physische Verbindungen zwischen den Rechnern einzelner Akteure in einem neutralen Umfeld, wie etwa dem Rechenzentrum. So können sich Teilnehmer ein- und desselben Ökosystems über kurze Wege verknüpfen und Informationen schnell und zuverlässig – das heißt ohne Ausfälle und mit niedrigen Latenzzeiten – mit anderen Teilnehmern austauschen. Dieser Ansatz garantiert, dass der Datentransfer sicher ist – insbesondere mit Blick auf digitale Zahlmethoden, wie etwa über Apps oder Online-Accounts.

Für Unternehmen, die auf IoT zurückgreifen, ist es nicht nur wichtig, mit wem, wie schnell und zuverlässig sie sich im Markt verbinden, sondern auch, wie flexibel diese Interaktion gestaltet werden kann. Besteht ein großer Bedarf an Speicherplatz, Rechenleistung oder Verbindungen, lassen sich zum Beispiel über die Cloud neue Kapazitäten, unabhängig vom eigenen Standort, hinzufügen und erweitern. Aufbau und Pflege solcher dynamischer IT-Infrastrukturen stellt jedoch viele Unternehmen vor eine Herausforderung. Deshalb lagern Unternehmen ihre IT-Infrastrukturen immer häufiger in Rechenzentren aus und verlassen sich auf die Expertise externer Anbieter. Dieser Lösungsansatz ist nicht nur schneller und flexibler, sondern auch kostengünstiger als der Aufbau einer eigenen IT-Infrastruktur.

„Der Weg von den Rohdaten zum tatsächlichen Geschäftswert beginnt mit der Datenbeschaffung, gefolgt von einer Datenanalyse, die hilft, Muster zu erkennen und endet mit der Verteilung an relevante Parteien, die diese Informationen und die darauf gewonnen Erkenntnisse für das weitere Geschäft verwerten. An all diesen Teilschritten innerhalb der Wertschöpfungskette sind Equinix IT-Infrastruktur-Lösungen beteiligt und wirken somit als Enabler. Sie bilden die Brücke zwischen dem, was durch IoT möglich ist und dem Fundament, das notwendig ist, um das volle Potenzial von IoT über alle Anwendungsbereiche hinweg gänzlich auszuschöpfen.“

– Donald Badoux, Managing Director von Equinix in Deutschland –

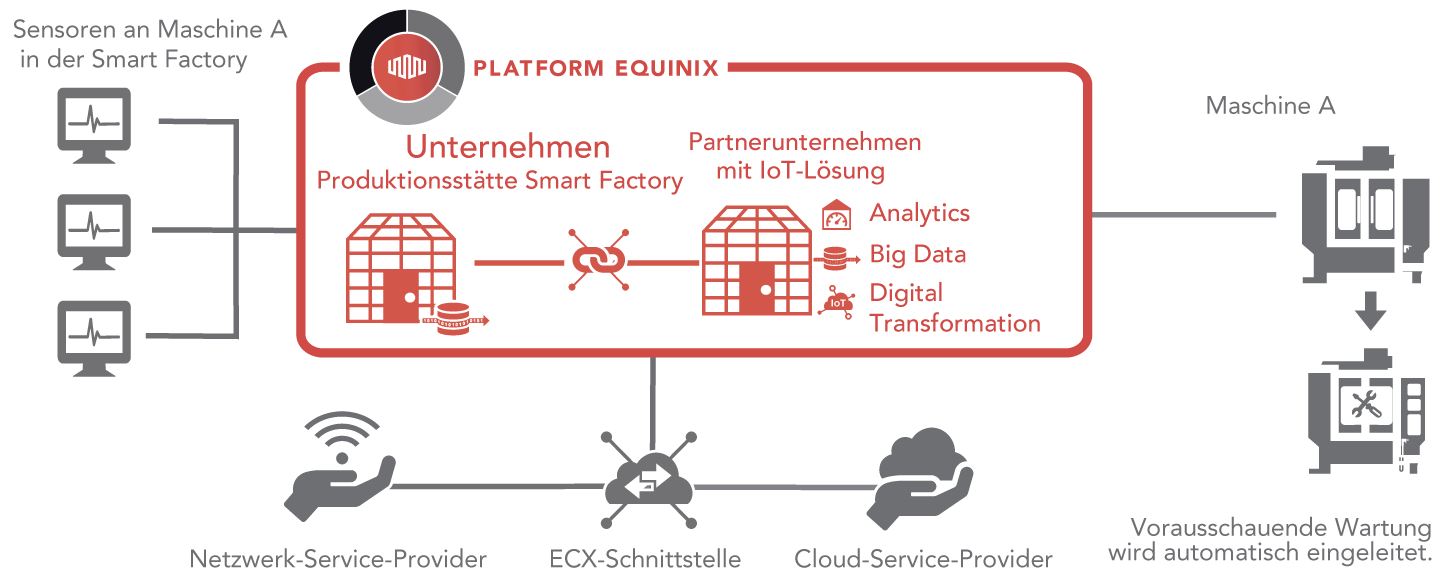

IoT birgt ein enormes Potenzial. In den Augen der Wirtschaft ist das Internet der Dinge ein aussichtsreicher Bereich, von dem sich Unternehmen massive Umsätze versprechen. Denn gewonnene Daten können auf vielfältige Weise gewinnbringend eingesetzt werden. Geht es zum Beispiel um IoT-Anwendungen im Bereich der Produktion, spricht man auch oft von Industrie 4.0. Sie stützt sich im Kern auf die Funktionen von Analytics und IoT, um Prozesse zu automatisieren und die Effizienz in der Fertigung sowie der Wartung von Maschinen und Systemen zu optimieren.

Ein Beispiel aus dem Bereich Industrie 4.0 ist die automatische Auswertung von Daten zur Optimierung von Wartungszyklen – auch „Predictive Maintenance“ genannt. Intelligente Sensoren erfassen Daten, diese werden ausgewertet und liefern Erkenntnisse, wann bestimmte Bauteile von Maschinen in der Produktion repariert oder sogar ersetzt werden müssen.

Die automatische Datenauswertung hilft bei der Reduktion des Energieaufwandes zur Heizung oder Kühlung von Maschinen und trägt damit zu einer Steigerung der Produktivität und Auslastung bei. Betriebsabläufe werden optimiert und Kosten eingespart. Auf einer anderen Ebene hilft die automatische Datenanalyse auch dabei, Kundenverhalten zu verstehen und deren Vorlieben zu erkennen. So können Unternehmen ihre Geschäftsmodelle und Angebote besser auf ihre Zielgruppen anpassen. Aus unternehmerischer Perspektive bietet IoT somit auch den Schlüssel zum Ausbau eigener Wettbewerbsvorteile.

| Vorteile von IoT | |

| • | IoT als Basis-Technologie zur Entwicklung neuer Geschäftsmodelle und Produkte (Innovation) |

| • | Steigende Umsätze durch die Verbesserung von bestehenden Produkten und Services |

| • | Geringere Ausfallzeiten und Senkung der Produktionskosten |

| • | Flexible Produktionsabläufe bzw. schnelle Anpassung an veränderte Anforderungen |

| • | Besseres Monitoring durch Echtzeit-Sensordaten und gesamtheitliche Übersicht über den Status von Produktionsprozessen |

Basis für eine erfolgreiche Integration von IoT in bestehende Prozesse sind hohe Datenübertragungsraten und effektive Breitbandverbindungen. Hohe Latenzzeiten oder gar Ausfälle im Zugang zu den Daten können für Unternehmen fatale Folgen haben. Dass die zugrunde liegende Infrastruktur nicht nur schnell und mit hoher Leistung arbeitet, sondern auch zuverlässig zur Verfügung steht bzw. im Notfall auch auf Back-ups zurückgegriffen werden kann, wird für Unternehmen – insbesondere auch im Rahmen von Industrie 4.0 – immer wichtiger.

Der digitale Wandel wird die Art und Weise, wie Wertschöpfung in der sogenannten vierten industriellen Revolution erzielt werden kann, fundamental verändern. Klassische Faktoren und Regeln der Unternehmensentwicklung, wie etwa Unternehmensgröße, Stabilität und langfristiges Wachstum, die bisher Kennzahlen für Erfolg und Misserfolg waren, verlieren in den kommenden Jahren an Bedeutung. Stattdessen wird es für Unternehmen immer wichtiger, die heutigen und zukünftigen technologischen Möglichkeiten bei der Umsetzung neuer, digitaler Geschäftsmodelle für sich zu nutzen und bestehende Modelle in Frage zu stellen. Mit einer technologischen Umwelt, die sich stetig verändert, wird die Frage danach, wie flexibel Unternehmen Anpassungen vornehmen, entscheidend für deren Erfolg sein.

Unternehmen von morgen müssen nicht nur das entsprechende Know-how und ein hohes Maß an Flexibilität besitzen, sondern auch grundsätzliche strategische Entscheidungen darüber treffen, wie und zu welchem Zweck die Einbindung von IoT erreicht werden soll. Denn während IoT-Lösungen heute überwiegend in der Prozessoptimierung zur Anwendung kommen, wird es in der Zukunft auch darum gehen, neue Produkte und Services und damit auch neuen Umsatz mithilfe von IoT zu entwickeln. Ist das Ziel gesetzt, kann mithilfe individueller IT-Lösungen von Partnern das entsprechende Fundament – also die jeweils am besten geeignete Infrastruktur – gelegt werden.

„Während IoT-Lösungen heute überwiegend in der Prozessoptimierung zur Anwendung kommen, wird es in der Zukunft auch darum gehen, neue Produkte und Services und damit auch neue Umsatzpotenziale mithilfe von IoT zu erschließen.“

Insbesondere kleine Unternehmen und Start-ups haben hier einen Vorteil. Sie können neue Technologien oftmals schneller adaptieren als Großkonzerne oder auch mittelständische Unternehmen. Beide sind in ihrer Flexibilität insofern eingeschränkt, als sie durch Veränderung und Umstrukturierung das Risiko eingehen, die eigenen bestehenden Umsätze zu belasten. Und doch: Die Digitalisierung bietet Möglichkeiten für jede Unternehmensgröße. Vor allem der Mittelstand hat das Potenzial, von IoT-Plattformen zu profitieren. Wichtig ist, dass auch kleine Unternehmen und Mittelständler diese einmalige Chance nicht aus den Augen verlieren und frühzeitig in den Einsatz von IoT investieren. //

For an English version of this article, please click here

Der Beitrag wurde auch im Open-Content-Buchprojekt „Handbuch IoT“ veröffentlicht.

Lesen Sie hier mehr…

New Work: KI, RPA und die Blockchain sorgen für Veränderungen. Fachkräfte für die zunehmend datengetriebene Arbeitswelt sind rar und ihre Bindung zum Unternehmen daher umso wichtiger.

Künstliche Intelligenz im Bankenbereich – was ist alles möglich, sinnvoll und mit vertretbarem Aufwand realisierbar?

Kerstin Götz, Geschäftsführerin Troi GmbH, im Hintergrundgespräch mit der Redaktion über die VUCA-Welt und New-Work-Konzepte für Agenturen

Frau Götz, in wieweit kann Ihre Lösung Agenturen bei der Etablierung von New-Work-Konzepten unterstützen?

Agenturen müssen ein schwankendes Projektgeschäft effizient und strukturiert planen. New Work Konzepte und Work-Life-Balance spielen zudem eine immer entscheidendere Rolle. Zusätzlich zu einer teilweise undurchsichtigen Projektlage kommt also die Organisation von Ressourcen über Remote-Konstellationen oder flexible Arbeitszeitmodelle.

Diesen Herausforderungen kann Rechnung getragen werden durch eine umfassende und vor allem smarte System-Lösung, die Mitarbeitern zum einen die Kollaboration erleichtert und zum anderen wichtige Informationen für unternehmensrelevante Entscheidungen liefert.

Welchen Stellenwert nimmt in unserer „agilen Zeit“ das Echtzeit-Reporting ein?

Um eine agile Entscheidungsfindung zu fördern ist es unabdingbar, aktuelle Unternehmens-Daten 24/7 parat zu haben. Gerade hieran scheitert es jedoch oft. Denn nicht immer sind die so entscheidenden Daten in der Kürze der Zeit verfügbar. Oder sie müssen entsprechend aufbereitet werden, um ein aussagekräftiges Reporting zu ergeben. Ressourcen dies zu tun sind nicht immer greifbar und die Fehleranfälligkeit ist hoch. Aus diesem Grund haben wir ein mobiles Echtzeit-Reporting geschaffen, das immer den aktuellen Projektstand, die Teamperformance sowie die Umsatz- und Margenentwicklung aufzeigt.

Was hat es mit Ihrer neuen TROI Live App auf sich und wie tief konnten Sie diese in Ihre Lösung intergrieren?

Die App ist die logische Ergänzung zu Troi, die den Funktionsumfang der Weblösung vollumfänglich nutzt, um diese in aussagekräftigen Dashboards zu visualisieren. Die Grundlage für die Daten speist sich komplett aus dem Troi System und wertet diese transparent in Echtzeit aus. Ebenso können Projekt- und Arbeitszeiten einfach erfasst und ausgewertet werden. Damit muss sich die Agentur über die aktuellen Entwicklungen bzgl. der Arbeitszeiterfassung keine Gedanken mehr machen. Die Zeiterfassung ist bei uns ein fest integrierter Bestandteil – gerade in Anbetracht der New Work Arbeitswelt.

Welche Prozesse im Agenturalltag sind eigentlich automatisierbar?

Alle Prozesse sind automatisierbar – von der Projektakquise bis zur Abrechnung. In Troi ist der Projektworkflow ein durchgängiger Prozess, der mit der Projektkalkulation beginnt und mit einer vorbereitenden Buchhaltung endet. Und selbst hier ist über diverse Schnittstellen eine Anknüpfung an weitere Systeme möglich, um diesen Prozess zu erweitern. Damit erhält man einen durchgängigen Datenflow, der den Mitarbeitern die Arbeit enorm erleichtert und die Konzentration auf die wertschöpfende Tätigkeit fokussiert.

Frau Götz, vor welchen Herausforderungen stehen Agenturen und Dienstleister im Kontext der digitalen Transformation?

Für die neue VUCA Welt gilt es, mit geeigneten Systemen und Prozessen gewappnet zu sein. In einem Umfeld, in dem Parameter, wie Volatilität, Unsicherheit, Komplexität und Mehrdeutigkeit an der Tagesordnung sind, ist es wichtig Transparenz zu allen relevanten Kennzahlen zu haben, um konkurrenzfähig zu bleiben und schnell fundierte Entscheidungen treffen zu können. Dieser Vorsprung ist wichtig um zeitnah reagieren zu können. Und nur, wenn alle Stakeholder ein klares Bild vom aktuellen Stand des Business haben, kann eine effiziente Steuerung erfolgen – vor allem im Einklang mit New Work Prinzipien. Denn hier muss eine Kommunikation oft remote erfolgen.

Welche Features, Module und Tools konnten Sie in Ihre Lösung intergieren?

Der Kernbereich ist die Projektabwicklung, sie ist der Dreh- und Angelpunkt einer jeden Agentur. Also ist auch in Troi das Projektmanagement das zentrale Modul. Wie bereits erwähnt, geht es bei Troi aber darum, den gesamten Projektalltag abzubilden. Dies beginnt bereits viel früher, nämlich bei der Projektakquise bzw. der Kontaktpflege. Die gesamte Kundenhistorie kann in unserem System datenschutzkonform dokumentiert werden. Damit ist immer eine Nachvollziehbarkeit gewährleistet. Aber nicht nur die zentrale Projekt- und Ressourcensteuerung erfolgt über Troi, auch die Erfassung der Projekt-Aufwände durch die verschiedenen Gewerke erfolgt über das System. Durch die Projektkalkulation und die erfassten Aufwände erfolgt ein automatisiertes Projektreporting. Der Projektverantwortliche kann so immer steuern, ob das Projekt noch im Bugdet und im Zeitplan liegt. Ein projektübergreifendes Reporting (das MIS Reporting) bietet gerade für Führungsverantwortliche und Geschäftsführer ein wichtiges Steuerungsmodul. Hier wird in Echtzeit das aktuelle Ergebnis über alle Projekte hinweg ausgewiesen.

Welche Rolle nimmt dabei das Projektmanagement ein?

Sowohl die Kalkulation, die Erstellung und Zuweisung von Projektaufgaben, als auch die zeitliche Planung erfolgt über das System. Das Aufgabenmanagement wird hier anschaulich über ein Kanban Board dargestellt und die Milestone-Planung über ein Gant Chart. Systemisch ist es möglich, sowohl agil als auch traditionell vorzugehen, das hängt von der Ausrichtung des Projektmanagements in der jeweiligen Agentur ab. Wir sehen oft, dass viele Agenturen mit hybriden Modellen arbeiten, denn nicht auf alle Projekte lässt sich die eine oder die andere Methode gänzlich anwenden. Wichtig ist aber, dass Troi durch die Automatisierung des Projektmanagement-Workflows sowie durch ein (device-übergreifendes) Controlling eine agile Entscheidungsfindung fördert und Agenturen damit unterstützt, sich im Projektmanagement weiterzuentwickeln. Und gemeinsam mit unseren Partnern lernen und entwickeln auch wir uns täglich weiter.

Weitere Informationen unter:

www.troi.de/live

In einer vernetzten Welt gewinnt ein zentrales Element zunehmend an Bedeutung: die Plattform, auf der die Dienstleistung betrieben wird.

von Jan Rodig

Viele Industrieunternehmen arbeiten mit Hochdruck daran, ihre Produkte zu vernetzen, um ergänzende digitale Services anzubieten und sich neue Erlösquellen zu erschließen. Eine der zentralen Entscheidungen in diesem Zusammenhang: Nutzt man als Basis für die eigene IoT- beziehungsweise Industrie-4.0-Lösung eine der über 500 am Markt verfügbaren IoT-Plattformen oder entwickelt man eine solche Plattform besser selbst?

Jan Rodig, CEO des unabhängigen IoT-Dienstleisters tresmo, teilt seine Praxiserfahrungen aus über 35 IoT-Projekten.

Der aktuelle Wirtschaftsaufschwung dauert bereits neun Jahre an, viele Unternehmen arbeiten an der Kapazitätsgrenze. Da fällt es oft nicht leicht, die gewaltigen Herausforderungen der Digitalisierung anzugehen, die mit dem IoT („Internet of Things“) beziehungsweise der Industrie 4.0 nun auch das produzierende Gewerbe in seinen Grundfesten erschüttert. Diese Entwicklung macht selbst vor stolzen Vorzeigebranchen wie der Automobilindustrie nicht halt: Fast alle Hersteller bauen sich gegenwärtig intensiv zu Mobilitätsdienstleistern um, die zukünftig selbstfahrende und -fliegende autonome Taxiflotten betreiben, statt Autos zu verkaufen. Auch im Maschinen- und Anlagenbau sowie in der Elektroindustrie sind Veränderungen spürbar: Physische Produkte werden zunehmend kommoditisiert, IoT-Anwendungen wie Condition Monitoring und Predictive Maintenance zum Standard, Differenzierungs- und Monetarisierungsmöglichkeiten verschieben sich von der reinen Hardware zu Softwarelösungen.

Aufmacherbild / Quelle / Lizenz

Bild von Gerd Altmann auf Pixabay

Industrie-4.0-Case-Study: Nachrüstung eines bestehenden Maschinenparks mit IoT-fähigen Kontrolleinheiten

Smart Mobilty, Smart Factory, „Smart X“: Eine smarte Zukunft benötigt kooperative Ansätze und horizontale Vernetzungen.

Die Herausforderungen der Digitalisierung sind überaus vielseitig und vielschichtig – und erfordern letztendlich durchgängig integrierte Systemlösungen. Das geht nur in stärker kooperativen Modellen. Eco-Systeme sind dafür eine bewährte Blaupause: Sie eröffnen neue Chancen und Geschäftsmöglichkeiten.

Stellen wir uns eine Smart City in der digitalen Zukunft vor, dann denken wir an eine urbane Ansiedlung, in der das Leben (hoffentlich) nicht nur weiterhin lebenswert ist, sondern völlig neue Qualitäten ermöglicht. Eine Stadt, die uns mithilfe von Digitalisierung den Alltag erleichtert, nachhaltig mit Energie und Ressourcen umgeht, sicher ist, Bildung und Beschäftigung ermöglicht, moderne Gesundheitsdienste für alle bereitstellt, immer wieder ein Hort des Aufbruchs und der Innovation ist und so weiter und so fort. Menschen jeden Alters müssen zu jedem Zeitpunkt mit ihren Erwartungen abgeholt, ihre Anforderungen an Mobilität und Immobilität befriedigt werden. Es gilt, die Bewegungsströme von Menschen, Fahrzeugen und Waren zu managen, genau wie alle erforderlichen Ressourcen und sämtliche Abfallprodukte der Gesellschaft. Und das eigentlich auch immer im Kontext aller Smart Cities auf der Welt. Dienstleistungen müssen für alle einfach benutzbar, bezahlbar, ausreichend, effizient und sicher verfügbar sein. Dazu müssen Daten gesammelt, intelligent ausgewertet und zwischen den verschiedenen Teilnehmern ausgetauscht werden. Das ist sicherlich eine Chance und Herausforderung zugleich – und manch einer mag auch sofort an die damit verbundenen Bedrohungen denken.

Mit der Umsetzung des Internet of Things entstehen vielschichtige, integrierte Netzwerke von Dingen und menschlichen Interaktionen. Smart Mobility oder Smart Factory … es sind die „Smart X“, die verschiedene Teilaspekte einer in der Zukunft notwendigerweise integrierten Zielinfrastruktur adressieren. Das Internet of Things ist dabei nicht Selbstzweck, sondern muss bereits während der Phase der Erforschung seiner Möglichkeiten auf die Lieferung der Werte für die digitale Zukunft der Gesellschaft (siehe oben) ausgerichtet sein. Alle damit verbundenen Herausforderungen können jedoch nicht von einem einzelnen Unternehmen – und sei es noch so mächtig – gelöst werden. Und auch die Politik wird dafür entscheidende Voraussetzungen und Rahmenbedingungen schaffen müssen. Für die smarte Zukunft werden daher stärker kooperative Ansätze und horizontale Vernetzungen benötigt. Eco-Systeme sind diesbezüglich eine sehr valide Modellbetrachtung mit vielen bereits sehr erfolgreichen Implementierungen im Markt.

Flexible Wunschkonfiguration der benötigten ERP-Funktionalitäten ohne Investitionsrisiko

Dinge schöpfen, Daten schaffen, Dinge… Der digitale Zwilling winkt dem, der sich selbst preisgibt.

Das Marktforschungs- und Beratungsunternehmen IDC geht davon aus, dass bis 2025 rund 80 Milliarden Geräte direkt mit dem Internet verbunden sein werden. Gestärkt durch den Smartphone-Siegeszug vernetzen Geräte, Maschinen und Menschen sich zunehmend.

Das IoT dringt nach und nach in alle Lebensbereiche vor und besetzt diese in Form eines Consumer IoT. Smartphones, Wearables, Smarthome-Devices und smarte Assistenten sind dabei ständig mit dem Internet verbunden. Fortwährend sammeln und analysieren sie Daten, wodurch Anbieter Services und physische Produkte personalisieren und den gestiegenen Kundenerwartungen gerecht werden können.

Die neu entstandenen personalisierten smarten Produkte wiederum aggregieren selbst weiter fröhlich Daten und eine endlose Personalisierungsspirale beginnt sich zu drehen. Gepaart mit der schnellen Adaption neuer Technologien entsteht zeitgleich ein Mentalitätswandel.

Diese Seite benutzt Cookies. Mit der Nutzung dieser Seite stimmen Sie den Datenschutzeinstellungen zu.

OKEinstellungenWir können Cookies anfordern, die auf Ihrem Gerät eingestellt werden. Wir verwenden Cookies, um uns mitzuteilen, wenn Sie unsere Webseite besuchen, wie Sie mit uns interagieren, Ihre Nutzererfahrung verbessern und Ihre Beziehung zu unserer Webseite anpassen.

Klicken Sie auf die verschiedenen Kategorienüberschriften, um mehr zu erfahren. Sie können auch einige Ihrer Einstellungen ändern. Beachten Sie, dass das Blockieren einiger Arten von Cookies Auswirkungen auf Ihre Erfahrung auf unseren Webseite und auf die Dienste haben kann, die wir anbieten können.

Diese Cookies sind unbedingt erforderlich, um Ihnen über unsere Webseite verfügbare Dienste bereitzustellen und einige ihrer Funktionen zu nutzen.

Da diese Cookies für die Bereitstellung der Website unbedingt erforderlich sind, wirkt sich die Ablehnung auf die Funktionsweise unserer Webseite aus. Sie können Cookies jederzeit blockieren oder löschen, indem Sie Ihre Browsereinstellungen ändern und das Blockieren aller Cookies auf dieser Webseite erzwingen. Dies wird Sie jedoch immer dazu auffordern, Cookies zu akzeptieren / abzulehnen, wenn Sie unsere Webseite erneut besuchen.

Wir respektieren es voll und ganz, wenn Sie Cookies ablehnen möchten, aber um zu vermeiden, Sie immer wieder zu fragen, erlauben Sie uns bitte, ein Cookie dafür zu speichern. Sie können sich jederzeit abmelden oder sich für andere Cookies anmelden, um eine bessere Erfahrung zu erzielen. Wenn Sie Cookies ablehnen, entfernen wir alle gesetzten Cookies in unserer Domain.

Wir stellen Ihnen eine Liste der auf Ihrem Computer in unserer Domain gespeicherten Cookies zur Verfügung, damit Sie überprüfen können, was wir gespeichert haben. Aus Sicherheitsgründen können wir keine Cookies von anderen Domains anzeigen oder ändern. Sie können diese in den Sicherheitseinstellungen Ihres Browsers überprüfen.

Diese Cookies sammeln Informationen, die entweder in aggregierter Form verwendet werden, um zu verstehen, wie unsere Webseite verwendet wird oder wie effektiv unsere Marketingkampagnen sind, oder um unsere Webseite und Anwendung für Sie anzupassen, um Ihre Erfahrung zu verbessern.

Wenn Sie nicht möchten, dass wir Ihren Besuch auf unserer Website erfassen, können Sie das tracking in Ihrem Browser hier deaktivieren:

Wir verwenden auch verschiedene externe Dienste wie Google Webfonts, Google Maps und externe Videoanbieter. Da diese Anbieter möglicherweise personenbezogene Daten wie Ihre IP-Adresse erfassen, können Sie diese hier sperren. Bitte beachten Sie, dass dies die Funktionalität und das Erscheinungsbild unserer Website erheblich beeinträchtigen kann. Änderungen werden wirksam, sobald Sie die Seite neu laden.

Google Webfont-Einstellungen:

Google Map-Einstellungen:

Google reCaptcha-Einstellungen:

Einbettung von Vimeo- und Youtube-Videos:

Die folgenden Cookies werden ebenfalls benötigt - Sie können auswählen, ob Sie sie zulassen möchten:

Sie können unsere Cookies und Datenschutzeinstellungen im Detail auf unserer Datenschutzrichtlinie nachlesen.

Datenschutz