Dies ist ein Gastbeitrag von Christian Endres, Referent Corporate Communications, toplink GmbH

Die Digitalisierung ist auf dem Vormarsch. Ein Umfeld, in dem viele Mitarbeiter erwarten, dass ihr Unternehmen in eine neue Arbeitswelt investiert. Da Firmen aber individuell aufgestellt sind, gibt es selten pauschale Ansätze und Lösungen.

Mit seinen Mitte der 1970er Jahre entwickelten Visionen der New Work stellte der österreichisch-US-amerikanische Sozialphilosoph Frithjof Bergmann bisherige Arbeitsstrukturen als längst überholt dar. Die zentralen Pfeiler seines zukunftsweisenden Konzeptes: Selbstständigkeit, Freiheit und Teilhabe an der Gemeinschaft. Werte, die dem Individuum vor allem eins bieten sollen: Handlungsfreiheit. Das Ziel: flache Hierarchien, eine gute Work-Life-Balance und Eigenverantwortung der Mitarbeiter.

Neue Organisations- und Arbeitsansätze wie Jobsharing, Recruiting, Remote Work, Employer Branding, Talent Management sowie agile Arbeitsmethoden wie Scrum und Kanban sind heute Teil der New Work. Was Bergmann schon damals erkannte: Kreativer Gestaltungsfreiraum und die Entfaltung der eigenen Persönlichkeit führt zu motivierten Mitarbeitern, die wiederum zur Innovation und somit maßgeblich zum Erfolg des Unternehmens beitragen.

Digital meets New Work

Das heutige Bild von modernen Arbeitsumgebungen ist sehr heterogen. Klar ist: Menschen arbeiten unabhängig von Ort und Zeit mit Laptop, Tablet oder Smartphone. Der Arbeitsplatz der Zukunft bietet aber viel mehr als nur ein flexibles Arbeitsumfeld. Unternehmen schaffen zeitgemäße Raumkonzepte und investieren in die neueste Technologie. Kognitive Systeme und digitale Assistenten unterstützen die Mitarbeiter in ihrem Arbeitsalltag. Zwar kann der digitale Arbeitsplatz ohne eine angemessene technologische Architektur nicht erfolgreich zustande kommen, in erster Linie geht es Unternehmen aber darum, eine Arbeitsatmosphäre zu schaffen, die Zusammenarbeit unterstützt.

In einer aktuellen Studie von Crisp Research wurden IT- und Business-Entscheider zu Work 4.0-Konzepten befragt. Auf die Kernfrage der Studie („Welche Auswirkungen hat die Digitalisierung des Arbeitsplatzes für Unternehmen, Mitarbeiter und die Wirtschaft in Zukunft?“) ergibt sich eine klare Antwort: Die effiziente Digitalisierung der Geschäftsprozesse benötigt neben der technologischen Ausstattung auch einen Wandel in Organisation, Führung und Unternehmenskultur.

Drei Fragen sollten sich Unternehmen im Zuge ihrer Digital-Workplace-Umsetzung stellen:

- Wie sollen meine Mitarbeiter zukünftig arbeiten?

- Welche Anforderungen stellen die Mitarbeiter an eine moderne Arbeitsumgebung?

- Welche Maßnahmen helfen mir im War for Talents?

Auf keine dieser Fragen gibt es einfache Antworten, da viele Faktoren eine Rolle spielen. Es kommt auf die Firmenkultur an und darauf, wo und vor welchen Aufgaben das Unternehmen steht. Unabhängig von der Wirtschaftsbranche begegnet die Geschäftsführung einer gleichen Herausforderung: Eine eigene digitale Agenda zu bestimmen. Wichtig hierbei ist, dass die Strategie des digitalen Wandels formuliert wird. Bevor die neuen Applikationen, Kommunikationslösungen und Endgeräte im Unternehmen genutzt werden, müssen einzelne Bestandteile, wie Infrastruktur, Management und Sicherheit, in einem Basis-Konzept stehen.

Für den Arbeitsplatz der Zukunft braucht es neben neuester Technologie auch eine Arbeitsatmosphäre, die Zusammenarbeit unterstützt.

Den Anwender mit auf die Reise nehmen

Ausgangspunkt für eine Strategie sollte immer eine Analyse der Interessengruppen, Prozesse, Ziele und Konzepte sein. Dabei ist es für Unternehmen entscheidend, die unterschiedlichen Bedürfnisse der Anwender zu berücksichtigen und ihr Angebot strategisch danach auszurichten. Ob als Kanal beispielsweise Chat oder E-Mail genutzt wird, ist eigentlich egal. Wichtig ist im Ergebnis, dass es optimale Instrumente gibt, einfach zusammenzuarbeiten. Kommunikationslösungen wie Skype for Business oder Slack können ihr Potenzial nicht ausschöpfen, wenn die Mitarbeiter weiterhin lieber E-Mails verschicken oder Tischtelefone nutzen.

Unternehmen, die den Digitalisierungsgrad ihrer Arbeitsplätze weiter steigern wollen, müssen sicherstellen, dass Anwender die neuen Möglichkeiten effektiv nutzen. Daher ist der Aufbau des Skill-Sets der späteren Nutzer im Rahmen des digitalen Wandels durch kontinuierliche Trainings besonders wichtig. Entscheidend ist es aber, die Anforderungen der Mitarbeiter in den Mittelpunkt zu rücken und das Angebot strategisch auf die unterschiedlichen Bedürfnisse aller Generationen auszurichten. Eine klare Kommunikationsstrategie über die Handlungsfelder, Aktionen und kommenden Neuerungen im Unternehmen trägt der Motivation und Akzeptanz der Mitarbeiter bei.

Resümee

Die Zukunft des Arbeitsplatzes stellt sich als komplexes, vielschichtiges Modell dar, bei dem es nicht den einen Konsens gibt. Sicher ist aber: Die Zufriedenheit im Job ist heute eng verknüpft mit der Sehnsucht nach Selbstbestimmung, maximaler Flexibilität und Kreativität. Die Work-Life-Balance bestimmt, ob Mitarbeiter gerne, engagiert und motiviert arbeiten. Im Wettbewerb um Talente spielt der Faktor Moderner Arbeitsplatz daher eine entscheidende Rolle. Hier klug zu investieren, ist wichtig für den künftigen Unternehmenserfolg.

Weitere Informationen unter:

www.toplink.de

Bildquelle / Lizenz:

https://www.pexels.com/de/foto/arbeiten-arbeitsplatz-arme-ausdruck-1169953/

https://www.pexels.com/de/foto/person-frau-buro-arbeiten-7374/

Was haben Ökosysteme mit Händlern und Marktplätzen zu tun? Eine Menge – denn der Marktplatz der Zukunft verhält sich ähnlich wie ein Ökosystem in der Natur, wo verschiedene Lebewesen einen gemeinsamen Lebensraum teilen und aufeinander angewiesen sind. Auch auf digitalen Marktplätzen stehen Anbieter aus verschiedenen Branchen miteinander und mit ihren Nutzern in Verbindung. So entsteht ein gemeinsamer Lebensraum von unterschiedlichen Diensten, Händlern und Nutzern.

Was haben Ökosysteme mit Händlern und Marktplätzen zu tun? Eine Menge – denn der Marktplatz der Zukunft verhält sich ähnlich wie ein Ökosystem in der Natur, wo verschiedene Lebewesen einen gemeinsamen Lebensraum teilen und aufeinander angewiesen sind. Auch auf digitalen Marktplätzen stehen Anbieter aus verschiedenen Branchen miteinander und mit ihren Nutzern in Verbindung. So entsteht ein gemeinsamer Lebensraum von unterschiedlichen Diensten, Händlern und Nutzern.

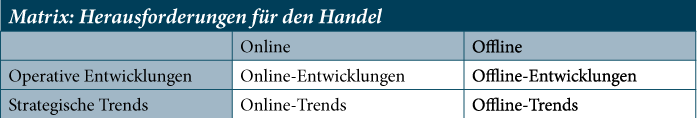

Die Dynamik im Marketing ist ungebrochen. Budgets werden immer schneller zwischen Print und Online, Personen und Maschinen, Inhouse und Dienstleistern hin- und hergeschoben. Die digitale Transformation ist Gegenstand zahlloser Kongresse und Veröffentlichungen. Im Handel führt diese Entwicklung dazu, dass sich Unternehmen nicht mehr nur dem stärker operativ geprägten Geschäft widmen dürfen. Handel ist Wandel bedeutet daher auch, sich besonders mit strategisch relevanten Umbrüchen auseinanderzusetzen.

Die Dynamik im Marketing ist ungebrochen. Budgets werden immer schneller zwischen Print und Online, Personen und Maschinen, Inhouse und Dienstleistern hin- und hergeschoben. Die digitale Transformation ist Gegenstand zahlloser Kongresse und Veröffentlichungen. Im Handel führt diese Entwicklung dazu, dass sich Unternehmen nicht mehr nur dem stärker operativ geprägten Geschäft widmen dürfen. Handel ist Wandel bedeutet daher auch, sich besonders mit strategisch relevanten Umbrüchen auseinanderzusetzen.