Kein Weg führt an der Kreislaufwirtschaft vorbei

Gastbeitrag von Tim Seewöster:

Es ist keine Neuheit: Die Ressourcen auf unserem Planeten sind endlich. Kein Tag zeigt dies so deutlich wie der Earth Overshoot Day. Dieser markiert den Zeitpunkt, an dem wir weltweit alle Ressourcen aufgebraucht haben, die uns eigentlich für das Jahr zur Verfügung stehen. Ab diesem Moment leben wir das restliche Jahr quasi “auf Pump”. 2024 fällt der Tag auf den ersten August – einen Tag früher als noch 2023. Was schon schlimm ist, verschlechtert sich noch weiter, wenn sich der Blick auf die Stichtage der einzelnen Länder richtet. Deutschland erreicht so schon am zweiten Mai seinen Overshoot Day, im ungefähr gleichen Zeitraum wie die meisten Industrienationen. Trauriger “Erster” der Liste ist Qatar, hier wurden bereits am elften Februar alle für ein Jahr verfügbaren Ressourcen aufgebraucht.

Tim Seewöster erklärt: Refurbishing, zu deutsch Wiederaufbereiten, bezeichnet den Prozess, in dem gebrauchte Unterhaltungselektronik – vor allem Smartphones, Laptops oder Tablets – in einen Zustand “wie neu” versetzt werden.

Kreislaufwirtschaft ist der Weg nach vorn

Klar ist, dass die großen Lösungen zur Bekämpfung der Klimakrise in der Politik entstehen müssen. Doch auch jede und jeder Einzelne hat die Möglichkeit und die Verantwortung, im Rahmen des Machbaren zu handeln. Ein Stichwort lautet Kreislaufwirtschaft. Diese ist in einer modernen Wirtschaft kein nettes Extra, sondern eine Notwendigkeit. Seltene Erden, Wasser und jegliche Form der Energie sind schlicht zu kostbar, um die durch sie entstandenen Produkte – nach oft künstlich verkürzten Erstnutzungs-Zeiträumen – einfach wegzuschmeißen. Vielmehr geht es um die Maximierung der Nutzung der Produkte über ihren gesamten Lebenszyklus. Besonders in der Elektronikindustrie, wo der Ressourcenverbrauch und die Umweltbelastung extrem hoch sind, gibt es hohe Einsparpotenziale. Hier kann das sogenannte Refurbishment Abhilfe schaffen.

Refurbishment: Vom Geheimtipp zum Trendsetter

Refurbishment ist das neue Bio. Denn erinnern wir uns kurz zurück: Bio-Produkte, einst ein vor allem in Reformhäusern auffindbarer Trend, wurden anfangs belächelt. Heute stehen sie für einen gesunden und bewussten Umgang mit Lebensmitteln, hohe Qualitätsstandards und ein gutes Gefühl beim Einkaufen. Ähnlich verhält es sich mit dem Refurbishment. Was einst als Nische galt, entwickelt sich mehr und mehr zum Mainstream. Doch was ist das genau?

Refurbishing, zu deutsch Wiederaufbereiten, bezeichnet den Prozess, in dem gebrauchte Unterhaltungselektronik – vor allem Smartphones, Laptops oder Tablets – in einen Zustand “wie neu” versetzt werden. Dafür bieten Refurbisher, wie wir von „asgoodasnew”, sowohl eine Möglichkeit, um seine alten Geräte an uns zu verkaufen, als auch eine Plattform, um wiederaufbereitete Produkte zu erwerben. Diese werden vorher von Fachpersonal getestet, gereinigt, gegebenenfalls werden Bauteile ausgetauscht. Am Ende der Wertschöpfungskette steht ein Produkt, das von fabrikneuer Ware technisch faktisch nicht zu unterscheiden ist und dabei bis zu 30% günstiger ist. Die meisten professionellen Refurbisher bieten im Anschluss eine erneuerte Garantie.

Warum das wichtig ist? Ganz einfach: Es spart Ressourcen. Ein wiederaufbereitetes Gerät benötigt keine neuen Rohstoffe und nur einen Bruchteil der Energie, die bei der Produktion von Elektronik anfallen. Diese macht etwa 80 Prozent des gesamten Fußabdrucks eines Gerätes aus. Der Effekt ist also enorm.

Das trifft den Zeitgeist. Vor allem die jüngeren Generationen haben keine Berührungsängste mit dem Refurbishment mehr: Aus der Generation Z hat schon etwa jeder Dritte ein wiederaufbereitetes Gerät erworben. Die zunehmende Preis-Sensibilisierung trägt ebenfalls dazu bei, dass Menschen, die nicht auf moderne Technik verzichten wollen, sich nach günstigen Optionen umsehen.

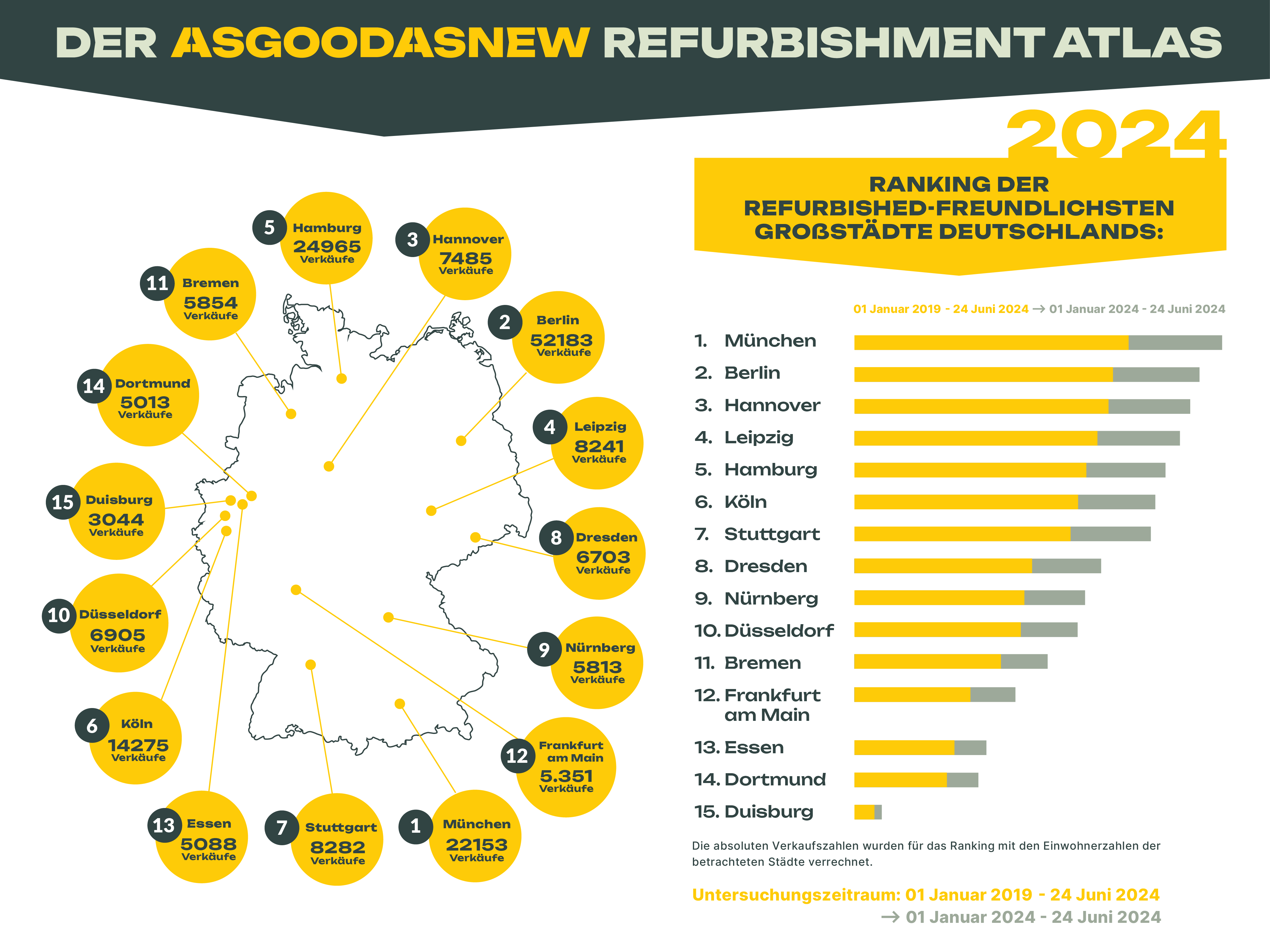

Der Refurbishment Atlas 2024

Spannende Insights dazu liefert der Refurbishment Atlas, den wir jedes Jahr veröffentlichen. In ihm werden unsere gesamten Verkäufe innerhalb eines Jahres gesammelt und anhand der Postleitzahl den deutschen Großstädten zugeordnet. Durch eine Verrechnung mit der Einwohnerzahl der jeweiligen Stadt ergibt sich die refurbish-freundlichste Stadt des Landes. Das Ergebnis: München bleibt Spitzenreiter vor Berlin und Hannover. In der Landeshauptstadt Bayerns hat statistisch eine von 68 Personen bereits refurbished Elektronik erworben. Schlusslicht bleibt das Ruhrgebiet mit Essen, Dortmund und Duisburg auf den letzten Rängen. Hier ist es gerade einmal eine Person aus 165, die wiederaufbereitete Ware gekauft hat.

Zeit zu handeln

Der Earth Overshoot Day zeigt auf anschauliche Weise, wie weit wir noch wirklichem klimafreundlichen Handeln entfernt sind und vor allem, wie viel Verantwortung dabei auf den Industrienationen liegt. Trotzdem – oder gerade deswegen – liegt die Verantwortung bei uns allen, die nötigen Maßnahmen zu fordern und den eigenen ökologischen Fußabdruck zu verringern. Zusammen wird groß, was wir klein beginnen: Am Ende ist es der Druck aus der Bevölkerung, der Veränderung schafft. Der Refurbishment Altas und ein Blick auf die jüngeren Generationen machen genau dort Hoffnung.

Kurzbiografie Tim Seewöster

Tim Seewöster ist Geschäftsführer und Co-CEO von asgoodasnew. Der promovierte Ökonom ist seit Anfang 2022 bei asgoodasnew und bildet zusammen mit Stefan Groitl eine Doppelspitze in der Geschäftsführung. Vorher arbeitete er unter anderem für Payback, Sparwelt und The Reach Group.

„Künstliche Intelligenz ist der Schlüssel zur Zukunft und unser KI-Playbook öffnet diese Tür für Unternehmen”, sagt Eva Werle, Vizepräsidentin im BVDW und CEO der Basilicom GmbH. „Es bietet das notwendige Wissen und die Werkzeuge, um KI nicht nur erfolgreich, sondern auch ethisch und nachhaltig einzusetzen.”.

„Künstliche Intelligenz ist der Schlüssel zur Zukunft und unser KI-Playbook öffnet diese Tür für Unternehmen”, sagt Eva Werle, Vizepräsidentin im BVDW und CEO der Basilicom GmbH. „Es bietet das notwendige Wissen und die Werkzeuge, um KI nicht nur erfolgreich, sondern auch ethisch und nachhaltig einzusetzen.”.